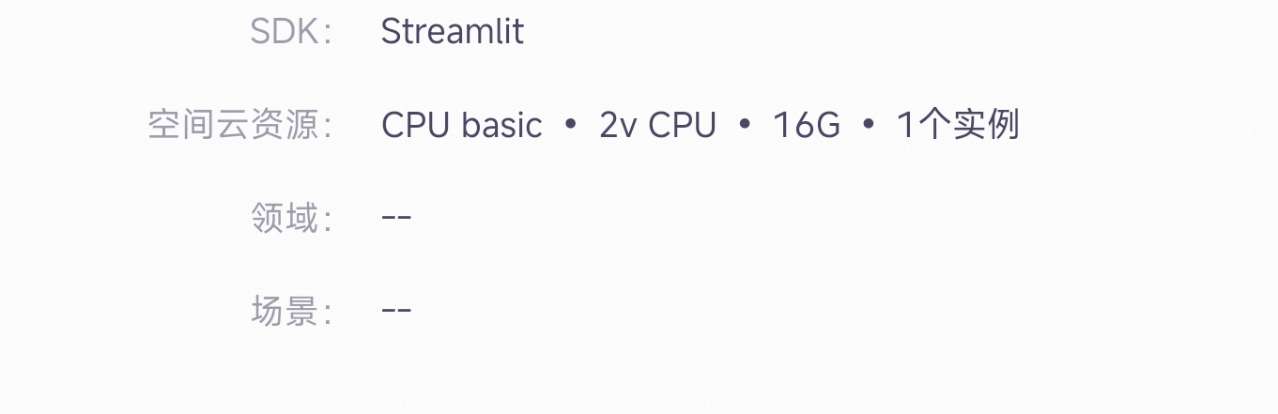

ModelScope中提供的这个免费的cpu最大能跑多大的模型呢?

llama.cpp、qwen.cpp、chatglm.cpp在电脑上可以看下。此回答来自钉群魔搭ModelScope开发者联盟群 ①。

ModelScope中提供的免费CPU资源能够运行的模型大小取决于多种因素,包括模型的参数量、计算复杂度以及优化程度等。

具体来说,以下是一些影响模型在免费CPU上运行能力的因素:

综上所述,虽然没有具体的模型大小限制,但是在实际使用中,用户需要根据自己的模型和计算需求来评估是否能够在免费的CPU资源上顺利运行。如果遇到资源限制,可以考虑使用上述提到的优化技术和分布式训练方法,或者寻求更强大的计算资源。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352