from swift.llm import (

get_model_tokenizer, get_template, inference, ModelType, get_default_template_type

)

model_type = ModelType.qwen_1_8b_chat

template_type = get_default_template_type(model_type)

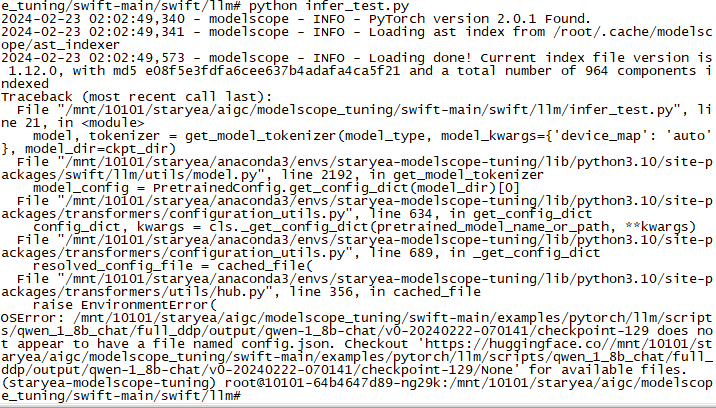

model, tokenizer = get_model_tokenizer(model_type, model_kwargs={'device_map': 'auto'}, model_dir=ckpt_dir)

template = get_template(template_type, tokenizer) ModelScope 以上是推理代码,执行报错,是啥情况?

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352