Flink CDC中,在支持分片独立消费的CDC binlog数据源中,如何高效地将各分片的offset以JSON格式或其他合适方式存储在SourceRecord的sourceOffset Map中?对于具有shardId和pos属性的CDC记录,应如何设计并更新offsetMap以跟踪每个分片的消费位置?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在Flink CDC中,为了高效地将各分片的offset以JSON格式或其他合适方式存储在SourceRecord的sourceOffset Map中,并跟踪每个分片的消费位置,您可以采取以下步骤:

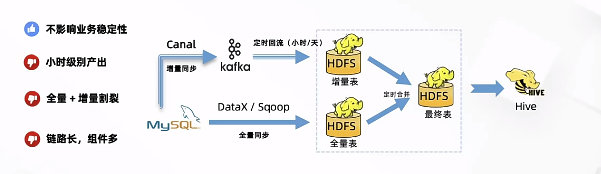

综上所述,以上步骤可以帮助您在Flink CDC中高效地管理和跟踪各个分片的消费位置。此外,Flink CDC还支持全量和增量一体化同步,以及无锁读取和并行读取等高级特性,这些特性可以进一步提高数据处理的效率和实时性。

在Flink CDC中,针对支持分片独立消费的CDC binlog数据源(如MySQL、TiDB等),通常会为每个分片维护一个独立的offset记录。对于具有shardId(即分区ID)和pos(binlog位置)属性的CDC记录,设计并更新SourceRecord的sourceOffset Map可以按照以下方式进行:

// 假设 SourceRecord 的 sourcePartition 包含了 shardId 信息

Map<String, Object> sourcePartition = new HashMap<>();

sourcePartition.put("shardId", shardId);

// sourceOffset Map 用于存储每个分片的消费位置

Map<String, Object> sourceOffset = new HashMap<>();

// 更新 offset 时,以 shardId 作为 key,并将 pos 作为 value 存储

sourceOffset.put(shardId, pos);

// 创建或更新 SourceRecord 时,设置其 partition 和 offset 信息

SourceRecord record = new SourceRecord(

sourcePartition,

sourceOffset,

topicName, // Kafka Topic 或其他目标 Sink 的名称

schema, // 数据的 Schema

value // CDC 记录的实际数据

);

// 在 Flink 的 SourceFunction 中,每当处理完一条记录后,需要根据新的 pos 更新 sourceOffset

public void process(SourceContext<T> context) throws Exception {

while (true) {

SourceRecord record = fetchNextRecord(); // 获取下一条 CDC 记录

String shardId = (String) record.sourcePartition().get("shardId");

Long pos = (Long) record.sourceOffset().get(shardId);

// 处理记录

// ...

// 更新 offset,这里假设 fetchNextRecord 已经获取到了新的 pos

Long newPos = getNextPosition(record); // 获取新位置

sourceOffset.put(shardId, newPos);

// 发送数据到 Flink 的上下文

context.collect(transformToInternalFormat(record));

}

}

// 确保在 checkpoint 时保存这些 offset

@Override

public void snapshotState(FunctionSnapshotContext context) throws Exception {

// 使用 Flink State API 将 sourceOffset 保存至状态后端,确保在故障恢复时能够正确恢复消费位点

stateBackend.getOrCreate(keyedOffsetsStateDescriptor).put(currentShardId, sourceOffset);

}

@Override

public void initializeState(FunctionInitializationContext context) throws Exception {

// 从状态后端恢复 offset

ValueState<Map<String, Object>> offsetsState = context.getKeyedStateStore().getState(keyedOffsetsStateDescriptor);

Map<String, Object> restoredOffsets = offsetsState.get();

if (restoredOffsets != null) {

sourceOffset.putAll(restoredOffsets);

}

}

以上代码示例展示了如何基于Apache Flink的数据流编程模型来跟踪和管理分片级别的binlog消费位置。实际应用中,需要根据具体的Flink CDC连接器实现来调整细节。例如,在使用Flink CDC官方提供的连接器时,连接器内部可能已经实现了类似的逻辑来自动管理和持久化offset信息,用户无需手动处理这部分细节。如果是自定义实现,则需要自行编写上述逻辑以保证checkpoint与恢复过程中的offset一致性。

在Flink CDC中,为了高效地将各分片存储并跟踪每个分片的消费位置,可以采用以下方法:

public class CustomSourceRecord extends DebeziumSourceRecord {

private String shardId;

private long pos;

// Getters and setters for shardId and pos

}

CopyCopy

public class CustomDebeziumSourceFunction extends DebeziumSourceFunction {

@Override

public void initialize(Context context) {

// Set the shard information and initialize the offsetMap

}

@Override

public void next(CustomSourceRecord value) {

// Update the offsetMap with the shardId and pos information

}

}

CopyCopy

@Override

public void initialize(Context context) {

super.initialize(context);

sourceOffsetMap = new HashMap<>();

// Initialize the sourceOffsetMap with the shardId and pos information

}

CopyCopy

@Override

public void next(CustomSourceRecord value) {

// Update the sourceOffsetMap with the shardId and pos information

sourceOffsetMap.put(value.getShardId(), value.getPos());

// Process the record as usual

}

CopyCopy

DataStream source = env.addSource(new CustomDebeziumSourceFunction(sourceOffsetMap));

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。