DataWorks指定了split.size 为什么input 的 records 还会如此不均等呢?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

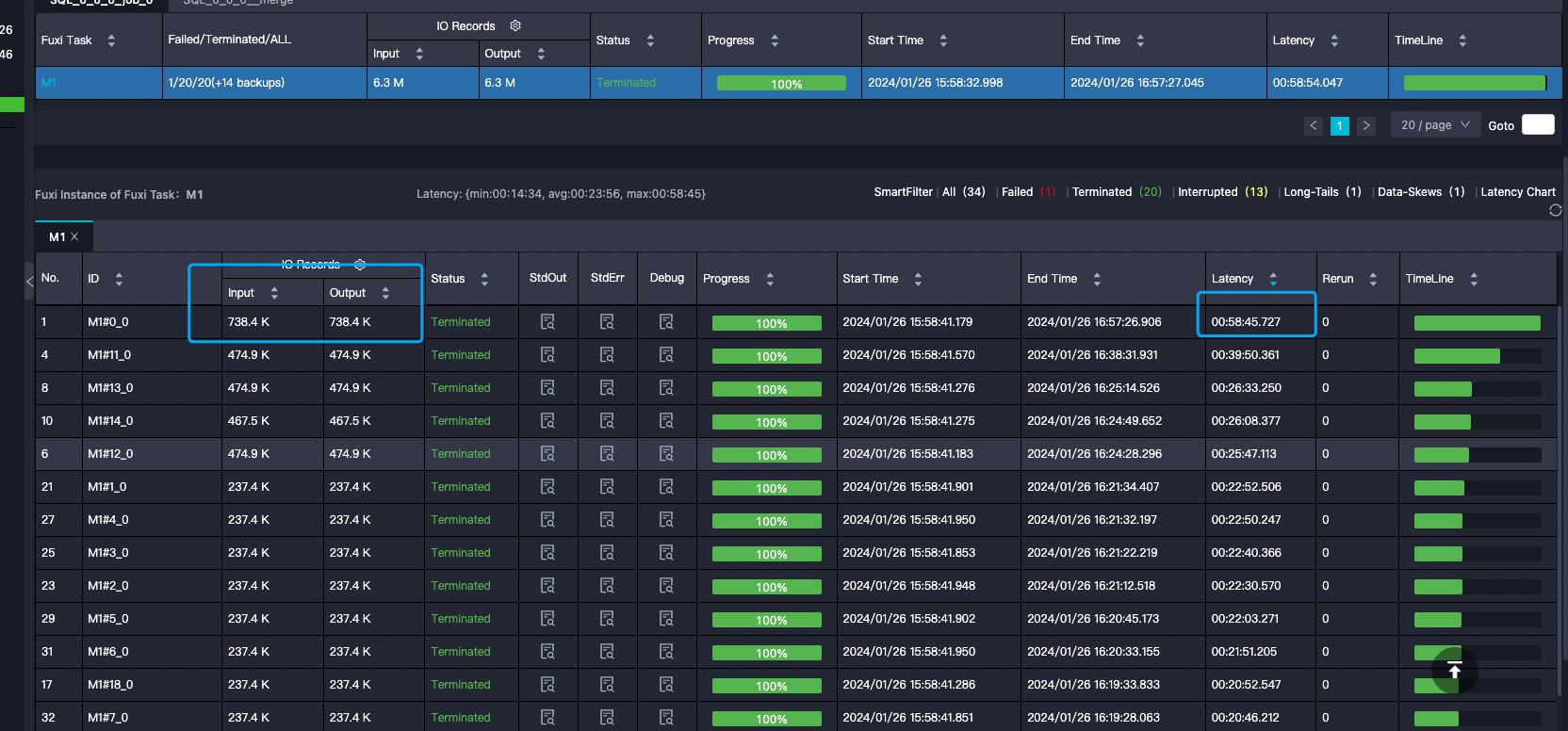

在DataWorks中,尽管可以通过设置split_size来控制Map任务的数据输入量,但在某些情况下,您可能会发现输入的records分布并不均匀。这可能是由于以下原因造成的:

split_size,也无法完全保证每个split的数据量相等。split或split_part等函数对字符串进行拆分,这可能会影响records的最终分布。因为拆分操作可能会导致某些records的数据量增加。split_size参数的影响范围:虽然split_size可以控制单个Map任务的最大数据输入量,但它并不能直接决定records的分布情况。它主要是用来控制每个Map任务处理的数据量,而不是确保数据在所有Map任务中均匀分布。为了改善records的分布情况,您可以尝试以下方法:

综上所述,虽然split_size是一个重要的参数,但它并不是唯一影响records分布的因素。在实际操作中,需要综合考虑多种因素,通过不断的测试和调整来优化数据处理流程。

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。