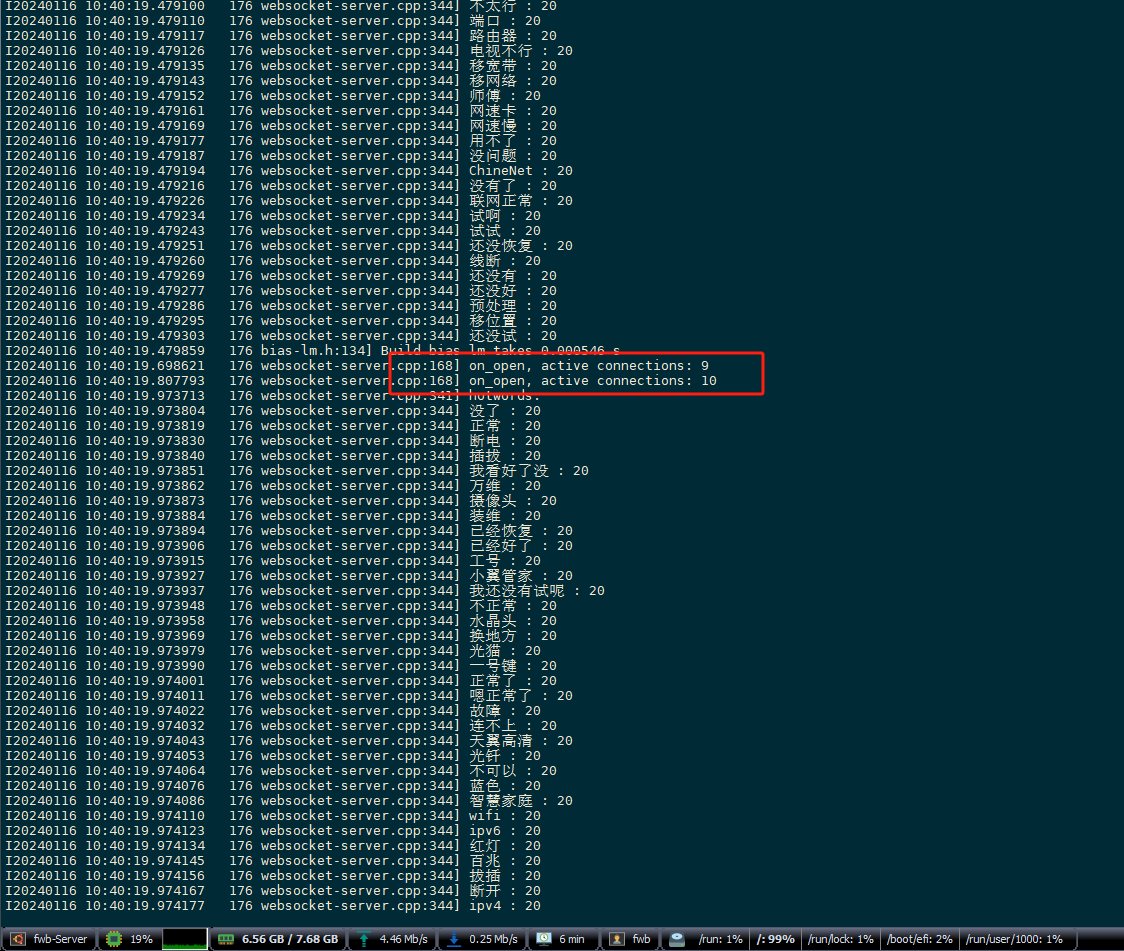

使用python多线程调用后,已经出现了有10个连接了,但是cpu使用率一直在20%以下,modelscope-funasr的cpu使用率上不去该怎么解决?

您在使用 Python 多线程调用 modelscope-funasr 时,发现尽管已经建立了 10 个连接,但 CPU 使用率仍然低于 20%。这表明当前的多线程实现可能未能充分利用 CPU 资源,导致性能瓶颈。以下是可能导致该问题的原因及解决方案。

Python 的 CPython 实现中存在全局解释器锁(GIL),它会限制同一时刻只有一个线程可以执行 Python 字节码。对于计算密集型任务(如语音处理或模型推理),多线程无法有效利用多核 CPU。

解决方法: - 切换到多进程模型:使用 multiprocessing 或 concurrent.futures.ProcessPoolExecutor 来替代多线程。每个进程拥有独立的 Python 解释器和内存空间,从而绕过 GIL 的限制。

from concurrent.futures import ProcessPoolExecutor

def process_task(data):

# 在这里调用 modelscope-funasr 的处理逻辑

pass

with ProcessPoolExecutor() as executor:

results = list(executor.map(process_task, data_list))

如果 modelscope-funasr 的任务本身计算量较小,或者输入数据不足以充分占用 CPU 资源,则即使增加线程数,CPU 使用率也可能较低。

解决方法: - 增加任务复杂度:检查输入数据的规模和复杂度,确保其能够充分占用 CPU 资源。例如,增加批量处理的数据量或提高模型的推理复杂度。 - 调整线程池大小:尝试减少线程数,避免过多线程之间的上下文切换开销。根据经验,建议线程数不超过 CPU 核心数的 1.5 倍。

如果 modelscope-funasr 的任务涉及大量 I/O 操作(如读取音频文件或网络通信),则 CPU 可能会因等待 I/O 完成而处于空闲状态。

解决方法: - 优化 I/O 操作:使用异步 I/O(如 asyncio)或非阻塞 I/O 库来减少等待时间。 - 预加载数据:将输入数据提前加载到内存中,避免运行时频繁读取磁盘或网络资源。

如果您使用的是基于 TensorRT 的推理模型,可以通过创建多个 Context 并行处理 Batch 数据来提升 CPU 和 GPU 的利用率。

解决方法: - 启用多 Context 模式:参考 TensorRT 的多线程优化方案,为每个线程分配独立的 Context,并行处理不同的 Batch 数据。

import threading

import tensorrt as trt

def infer(engine, data):

# 创建独立的 Context 并执行推理

context = engine.create_execution_context()

# 执行推理逻辑

pass

threads = []

for i in range(2): # 创建两个线程

t = threading.Thread(target=infer, args=(engine, data_list[i]))

threads.append(t)

t.start()

for t in threads:

t.join()

如果您使用的是阿里云 ECS 的突发性能实例(如 t6 系列),其 CPU 使用率可能受到可用 CPU 积分的限制。当积分耗尽时,实例的性能会被限制在基准性能以下。

解决方法: - 监控 CPU 积分:登录 ECS 管理控制台,查看当前实例的 CPU 积分余额和消耗情况。 - 切换到无性能约束模式:在无性能约束模式下,实例可以通过透支或付费使用 CPU 积分突破性能限制。 - 升级实例规格:如果长期需要高 CPU 使用率,建议升级到固定性能实例(如 c6 系列)。

通过以上方法,您可以有效提升 modelscope-funasr 的 CPU 使用率,充分发挥计算资源的潜力。