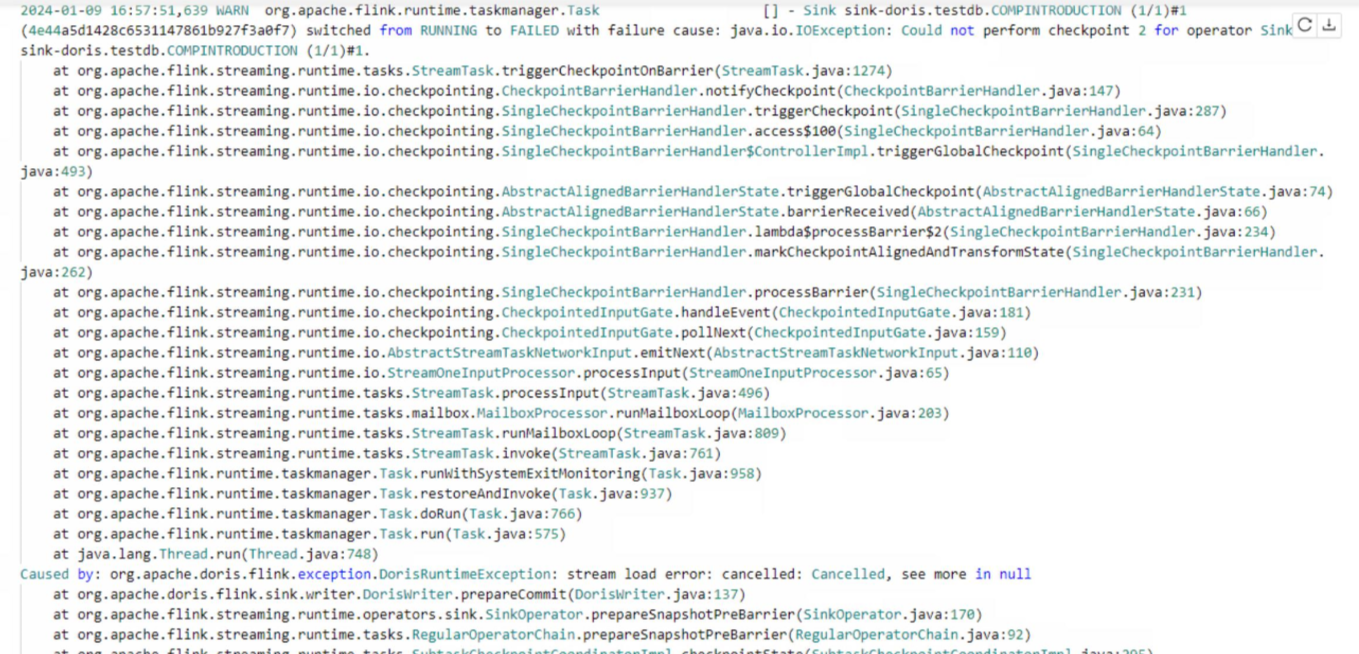

Flink CDC里这个问题怎么解决?flink cdc oracle sink to doris (小数据量无报错,大数据量卡住报checkpoint超时)

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

这个问题可能是由于Flink CDC在处理大数据量时,checkpoint超时导致的。你可以尝试以下方法来解决这个问题:

增加checkpoint的超时时间。你可以在Flink配置文件中设置taskmanager.network.memory.min和taskmanager.network.memory.max参数,以增加任务管理器的网络内存。这将有助于减少checkpoint的时间。

调整Flink CDC的并行度。你可以通过设置sink.parallelism参数来调整Flink CDC的并行度。这将有助于提高处理大数据量的速度。

优化Doris表结构。你可以尝试优化Doris表的结构,以提高查询性能。例如,你可以为经常用于查询条件的列创建索引。

使用分区表。如果你的数据量非常大,可以考虑将数据存储在分区表中。这样,Flink CDC可以更有效地处理数据。

考虑使用其他数据同步工具。如果Flink CDC仍然无法满足你的需求,你可以考虑使用其他数据同步工具,如Apache Kafka Connect、Debezium等。这些工具可能更适合处理大数据量。

你可以参考一下排查

1.任务配置:可以看下chk的间隔以及超时时长,在业务允许的范围能不能调大、chk的大小均值、增量还是全量,有没有突增很多

2.任务性能:数据量多大,看看有没有背压,sink写的慢的话的,刷新间隔、条数都可以调大一下、也可以试下调大并发。

3.doris排查:看看doris的一些监控在这个时间段有没有问题、性能怎样

4.服务器排查:看看服务器上这个任务的io、cpu、内存有没有达到峰值、算力资源不足。此回答来自钉群Flink CDC 社区。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。