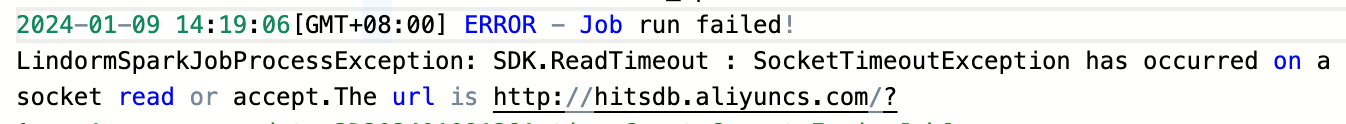

DMS里突然一直报这个错是什么原因?之前任务跑得好好的啊。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

这个错误可能是由于网络连接问题或者服务器负载过高导致的。你可以尝试以下方法解决这个问题:

sparkConf参数来调整超时时间。例如:from pyspark import SparkConf, SparkContext

conf = SparkConf().setAppName("LindormSparkJob").set("spark.hadoop.lindorm.read.timeout", "600")

sc = SparkContext(conf=conf)

这里将超时时间设置为600秒(10分钟)。你可以根据实际情况调整这个值。