Flink CDC这个看着最小是有一个线程的,但是看你报错 一个都没有?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的问题“Flink CDC这个看着最小是有一个线程的,但是看你报错一个都没有?”,结合知识库中的相关资料,以下是详细且专业的解答:

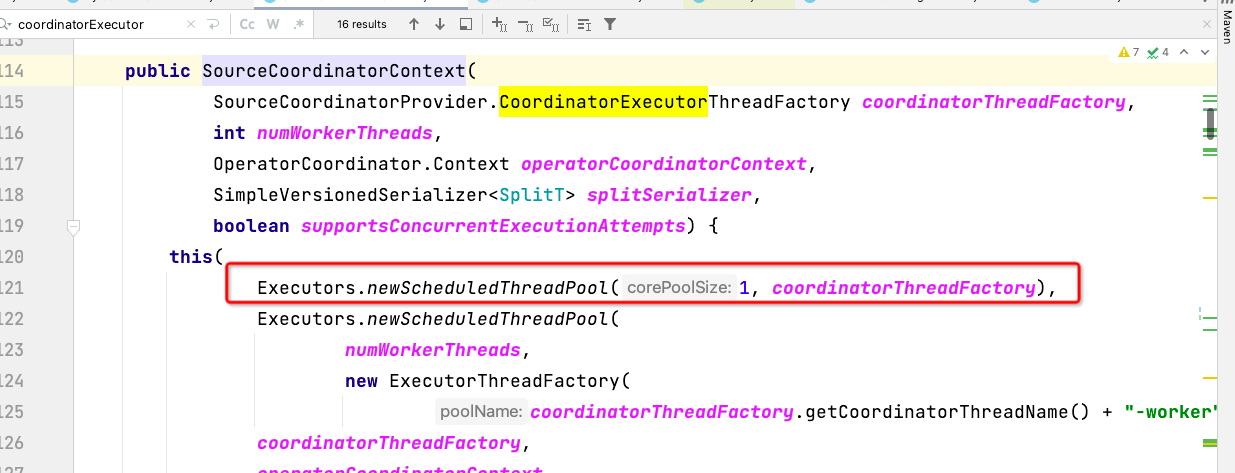

Flink CDC 是基于 Flink 的流处理能力实现的实时数据捕获工具,其核心功能是通过监听数据库的日志(如 MySQL 的 binlog 或 PostgreSQL 的 wal)来捕获数据变更,并将这些变更实时传输到目标存储系统。在运行过程中,Flink CDC 通常会启动多个线程来处理数据捕获、转换和分发等任务。

然而,如果出现“一个线程都没有”的错误提示,可能与以下原因有关: - 资源配置不足:Task Manager 的 CPU 或内存资源不足,导致无法启动线程。 - 作业配置错误:某些关键参数未正确设置,导致作业无法正常初始化线程。 - 依赖问题:缺少必要的依赖或类加载失败,导致线程无法启动。 - 异常退出:由于某些异常(如 OOM 或 RPC 超时),线程未能成功启动。

Flink CDC 作业需要足够的 CPU 和内存资源来启动线程。如果 Task Manager 的资源不足,可能会导致线程无法启动。

解决方案: - 检查资源配置页面,确保 Task Manager 的 CPU 和内存资源充足。 - 如果 Source 出现 finish split response timeout 异常,可能是 Task 的 CPU 使用率过高导致无法响应 Coordinator 的 RPC 请求。此时需要增加 Task Manager 的 CPU 资源。

某些关键参数未正确设置可能导致线程无法启动。例如: - Postgres CDC 参数:slot.name 参数在 8.0.1 版本之后为必填项。如果未设置该参数,可能会导致作业无法启动线程。 - Debezium 属性参数:debezium.* 参数用于细粒度控制 Debezium 客户端的行为。如果配置错误,可能会导致线程初始化失败。

解决方案: - 确保所有必填参数均已正确设置。例如,Postgres CDC 中的 schema-name 和 table-name 必须填写。 - 检查 debezium.* 参数是否符合要求。例如,'debezium.snapshot.mode' = 'never' 可以避免全量快照的执行。

如果缺少必要的依赖或类加载失败,可能会导致线程无法启动。例如: - 内置连接器使用附加依赖 JAR 时,可能会出现 connector class not found 异常。 - 在本地 IDEA 运行时,可能会出现 ClassNotFoundException MySqlSourceReaderMetrics 错误。

解决方案: - 确保所有必要的依赖均已正确加载。如果使用附加依赖 JAR,请检查类加载路径。 - 在本地开发环境中,确保 MySQL CDC JAR 已正确引入。

某些异常(如 OOM 或 RPC 超时)可能导致线程未能成功启动。例如: - 在异步线程中使用 JDBC 读取数据库时,可能会出现 OOM 无法透出的问题。

解决方案: - 检查日志文件,定位具体的异常信息。 - 如果是 OOM 问题,可以尝试增加 JVM 堆内存或优化数据处理逻辑。

slot.name 参数为必填项。建议每个表都设置该参数,以避免出现 PSQLException: ERROR: replication slot "debezium" is active for PID 974 报错。scan.incremental.snapshot.enabled 参数为实验性功能,仅支持实时计算引擎 8.0.6 及以上版本。启用该功能前,请确保满足前提条件。针对“Flink CDC 看着最小是有一个线程的,但是报错一个都没有”的问题,建议按照以下步骤排查: 1. 检查资源配置,确保 Task Manager 的 CPU 和内存资源充足。 2. 核对作业配置,确保所有必填参数均已正确设置。 3. 检查依赖加载情况,避免出现类加载失败的问题。 4. 查看日志文件,定位具体的异常信息并采取相应措施。

如果问题仍未解决,建议提交工单并提供详细的日志信息,以便进一步排查。

希望以上解答能够帮助您快速定位并解决问题!您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。