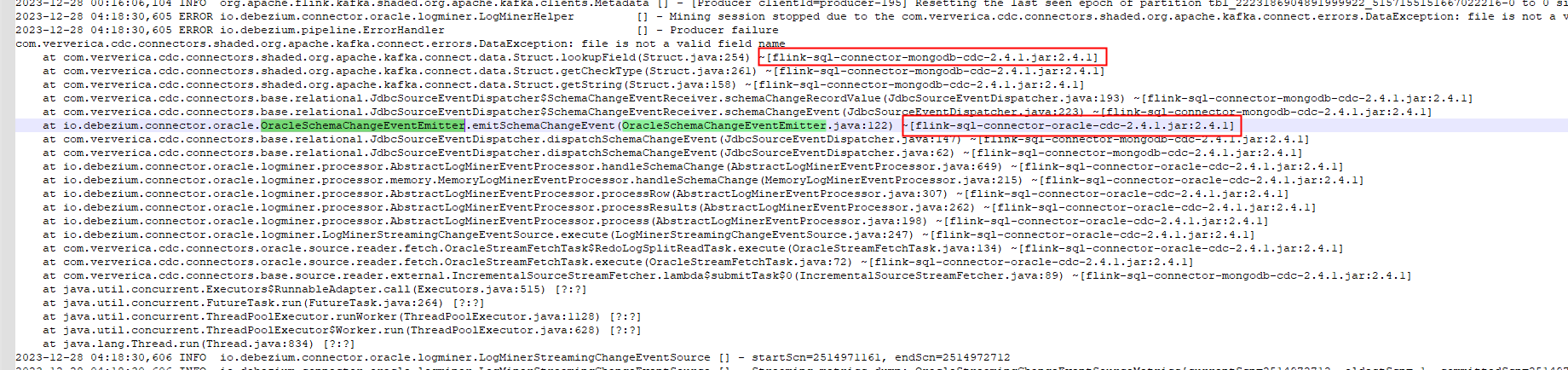

Flink CDC怎么还能看到mongodb的错误呢,我用的是oracle-cdc呀?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

您的问题提到使用的是 Oracle CDC,但询问为何能看到 MongoDB 的错误。这表明可能存在配置或依赖上的混淆。以下是详细分析和解决方法:

Flink CDC 支持多种数据库的连接器(如 Oracle、MongoDB 等),每个连接器是独立开发的,互不干扰。如果您在使用 Oracle CDC 时看到 MongoDB 的错误,可能的原因包括: - 项目中引入了 MongoDB CDC 的依赖:检查您的 Maven 或 Gradle 配置文件,是否意外引入了 flink-connector-mongodb 的依赖。 - 代码中误用了 MongoDB CDC 的配置:例如,您可能在代码中同时初始化了 MongoDB 和 Oracle 的数据源。

在 Maven 中,确保只引入了 Oracle CDC 的依赖,而不是 MongoDB 的依赖。例如:

<!-- 正确:Oracle CDC 依赖 -->

<dependency>

<groupId>com.ververica</groupId>

<artifactId>flink-connector-oracle-cdc</artifactId>

<version>${vvr.version}</version>

</dependency>

<!-- 错误:MongoDB CDC 依赖 -->

<dependency>

<groupId>com.alibaba.ververica</groupId>

<artifactId>flink-connector-mongodb</artifactId>

<version>${vvr.version}</version>

</dependency>

如果发现 MongoDB 的依赖被引入,请移除相关依赖并重新构建项目。

在 Flink 作业中,数据源的配置决定了从哪个数据库读取数据。如果您在代码中同时配置了 MongoDB 和 Oracle 的数据源,可能会导致 MongoDB 的错误日志出现。

以下是一个典型的 Oracle CDC 数据源配置示例:

OracleSource.builder()

.hostname("oracle-host")

.port(1521)

.database("ORCLCDB")

.schemaList("inventory")

.tableList("inventory.products")

.username("flinkuser")

.password("flinkpw")

.deserializer(new JsonDebeziumDeserializationSchema())

.build();

如果您在代码中误用了 MongoDB 数据源,例如:

MongoDBSource.builder()

.hosts("mongo.example.com:27017")

.username("mongouser")

.password("mongopasswd")

.databaseList("testdb")

.collectionList("testcoll")

.startupOptions(StartupOptions.initial())

.deserializer(new JsonDebeziumDeserializationSchema())

.build();

请删除或注释掉与 MongoDB 相关的代码。

如果您已经确认代码中没有使用 MongoDB CDC,但仍看到 MongoDB 的错误日志,可能是以下原因: - 共享的日志系统:您的日志系统可能同时记录了多个数据源的错误信息。检查日志来源,确认是否为 MongoDB 的错误。 - 环境配置问题:某些环境中可能存在多个 Flink 作业运行,其中一个作业使用了 MongoDB CDC,导致日志混杂。

changeStream 权限。根据您的描述,问题的根本原因可能是 项目中意外引入了 MongoDB CDC 的依赖或配置。请按照以下步骤排查: 1. 检查 Maven/Gradle 配置文件,移除 MongoDB CDC 的依赖。 2. 检查代码中是否误用了 MongoDB 数据源配置。 3. 确认日志来源,过滤掉与 MongoDB 相关的日志。

如果问题仍未解决,请提供更多上下文信息(如完整的依赖配置和代码片段),以便进一步分析。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。