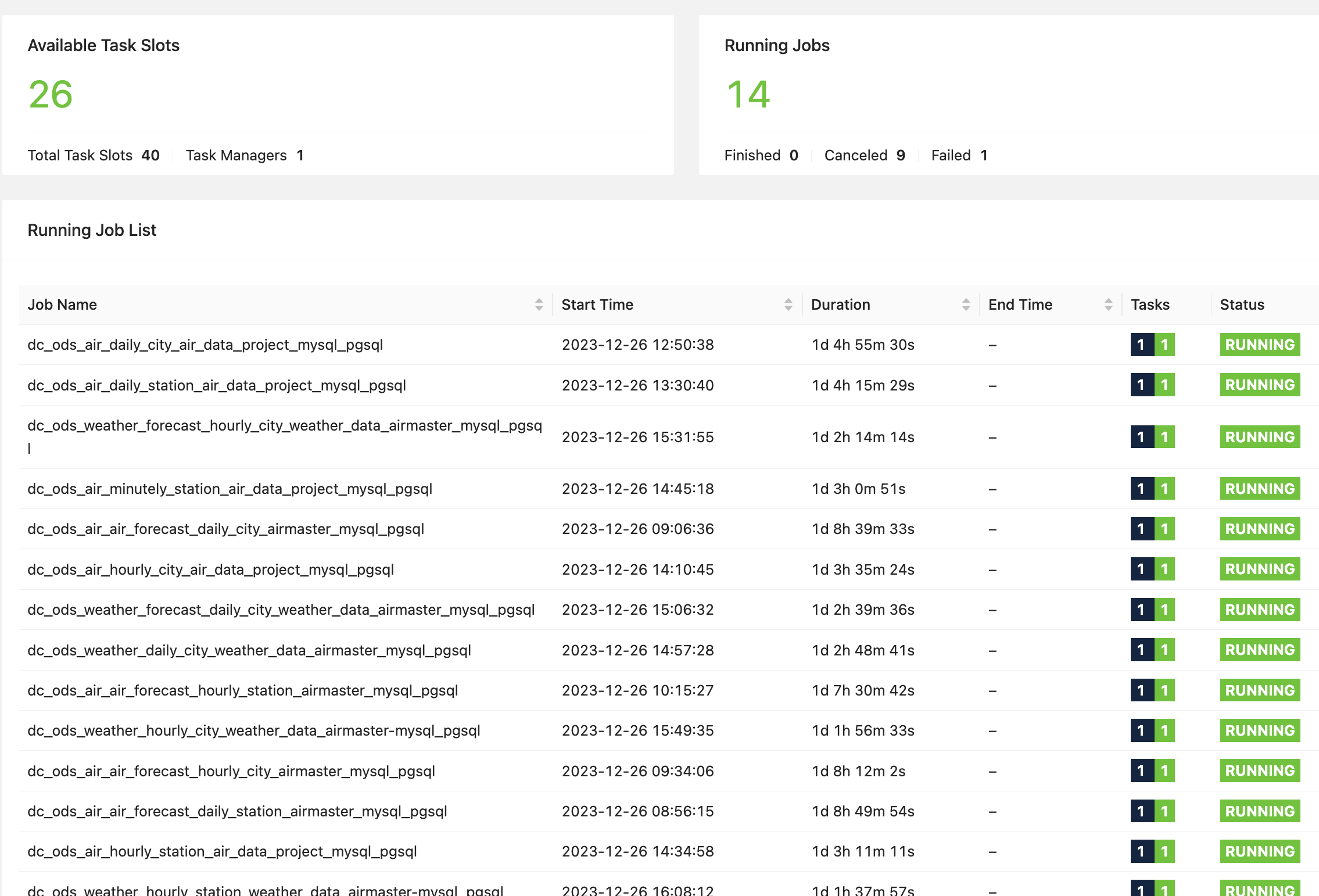

Flink CDC这是不是太多了 但是好像又只能每个表一个作业?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用Flink CDC时,确实可能会遇到每个表需要一个作业的情况,这会导致作业数量过多,增加数据库的压力和管理复杂度。然而,根据知识库中的资料,可以通过以下方法优化和减少作业数量,从而缓解这一问题:

通过使用STATEMENT SET语法,可以将多个CREATE TABLE AS (CTAS)语句合并为一个作业提交。这种方式能够复用同一个Source节点读取多张业务表的数据,从而减少对数据库的连接数和读取压力。

示例代码:

USE CATALOG holo;

BEGIN STATEMENT SET;

-- 同步分库分表数据

CREATE TABLE IF NOT EXISTS user

AS TABLE mysql.`user_db[0-9]+`.`user[0-9]+`

/*+ OPTIONS('server-id'='8001-8004') */;

-- 同步TPCDS库

CREATE DATABASE IF NOT EXISTS holo_tpcds

AS DATABASE mysql.tpcds INCLUDING ALL TABLES

/*+ OPTIONS('server-id'='8001-8004') */;

-- 同步TPCH库

CREATE DATABASE IF NOT EXISTS holo_tpch

AS DATABASE mysql.tpch INCLUDING ALL TABLES

/*+ OPTIONS('server-id'='8001-8004') */;

END;

重要提示: - 需要确保这些Source表的OPTIONS配置完全一致,才能成功合并并复用Source节点。 - 这种方式特别适用于MySQL CDC场景,可以显著减少server-id的使用和数据库连接数。

如果源表数量较多,直接通过Flink CDC读取MySQL Binlog会导致数据库压力过大。可以通过将表同步到Kafka消息队列中,再由Flink消费Kafka中的数据来实现解耦。

操作步骤: 1. 使用工具(如Debezium)将MySQL整库的数据同步到Kafka。 2. 在Flink中消费Kafka中的数据,避免直接连接MySQL读取Binlog。

优点: - 减少对MySQL的直接压力。 - 提高系统的扩展性和容错能力。

Flink支持通过CREATE DATABASE AS (CDAS)语句实现整库同步。这种方式可以将整个数据库的所有表同步到目标系统,而无需为每张表单独创建作业。

示例代码:

CREATE DATABASE IF NOT EXISTS holo_tpcds

AS DATABASE mysql.tpcds INCLUDING ALL TABLES

/*+ OPTIONS('server-id'='8001-8004') */;

新增表支持: - 如果源库新增表,可以通过开启table.cdas.scan.newly-added-table.enabled参数,并从作业快照重启,捕获新增表并进行同步。

对于分库分表的场景,可以通过table-name选项指定正则表达式来匹配多张表,从而减少作业数量。

示例配置:

'table-name' = 'user_\d+'

注意事项: - 如果正则表达式包含逗号,需要用竖线(|)运算符改写。例如:

'table-name' = '(mytable_\d{1}|mytable_\d{2})'

Flink MySQL CDC连接器支持多并发读取全量数据,能够提高数据加载效率。同时,在增量阶段可以通过Autopilot自动调优功能实现资源缩容。

操作建议: - 在实时计算开发控制台的基础模式或专家模式中设置作业的并发数。 - 基础模式设置的是全局并发数,专家模式支持按需为某个VERTEX设置并发数。

如果不需要读取全量数据,可以通过scan.startup.mode参数跳过Snapshot阶段,直接从变更数据开始读取。

配置示例:

'scan.startup.mode' = 'latest-offset'

可选值: - earliest-offset:从最早可用的Binlog位点消费。 - latest-offset:从最新的Binlog位点消费。 - timestamp:从指定时间戳消费。 - specific-offset:从指定的Binlog位点消费。

server-id,可以实现数据源的复用,进一步减小数据库压力。通过上述方法,您可以有效减少Flink CDC作业的数量,降低数据库压力,并提升系统的整体性能。具体选择哪种方案,取决于您的业务需求和场景特点。例如: - 如果需要整库同步,推荐使用CDAS语句。 - 如果需要处理分库分表,推荐使用正则表达式匹配或多CTAS语句合并。 - 如果数据库压力较大,推荐将数据同步到Kafka进行解耦。

希望以上内容能帮助您更好地优化Flink CDC作业!

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。