Flink使用dinky提交代码,任务是从kafka流入hive。

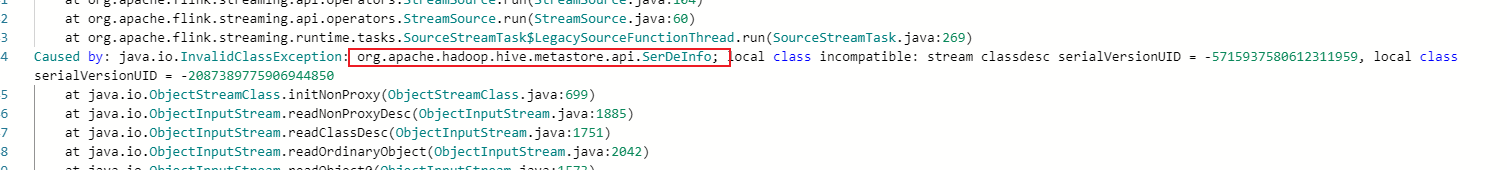

现在遇到的问题是序列化问题。他仔细检查了我所有关于flink-sql-connector-hive-3.1.2_2.11-1.13.6.jar的包,版本全部是一样的,dinky和flink,包版本都一样,所有目前我对于这个报错没太多思路?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据用户描述,任务是从Kafka流入Hive,使用Dinky提交Flink SQL代码时遇到了序列化问题。尽管用户已经确认了flink-sql-connector-hive-3.1.2_2.11-1.13.6.jar的版本一致性(Dinky、Flink和相关依赖包的版本一致),但问题仍然存在。以下是可能的原因及解决方案。

value.json.infer-schema.flatten-nested-columns.enable参数以展开嵌套列。CREATE TEMPORARY TABLE ... LIKE语法显式声明临时表,指定期望的Schema。例如:

CREATE TEMPORARY TABLE tempTable (

value_name STRING,

value_ts STRING

) LIKE `kafkaJsonCatalog`.`kafka`.`testTopic`;

pipeline.operator-chaining设置为false时,可能会增加序列化和反序列化的开销,尤其是在合并多个Source时。pipeline.operator-chaining未被设置为false。如果必须关闭算子链,请评估性能影响。value.format和key.format参数。例如:

WITH (

'connector' = 'kafka',

'topic' = 'your_topic',

'properties.bootstrap.servers' = 'localhost:9092',

'value.format' = 'json',

'key.format' = 'json'

)

flink-sql-connector-hive的版本一致性,但Dinky本身可能存在与Flink版本的兼容性问题。例如,Dinky的某些功能可能依赖于特定版本的Flink API。advertised.listeners配置错误可能导致Flink无法正确读取Kafka数据。advertised.listeners配置正确。INSERT Statements语法。如果用户的SQL语句不符合这些限制,可能会导致序列化问题。INSERT Statements之前声明USE Catalog <yourHiveCatalog>。value.format和key.format参数。如果问题仍未解决,建议提供更详细的报错日志,以便进一步分析。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。