Flink CDC啥情况,按官方文档cdc3.0,flink1.18跑不起来?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

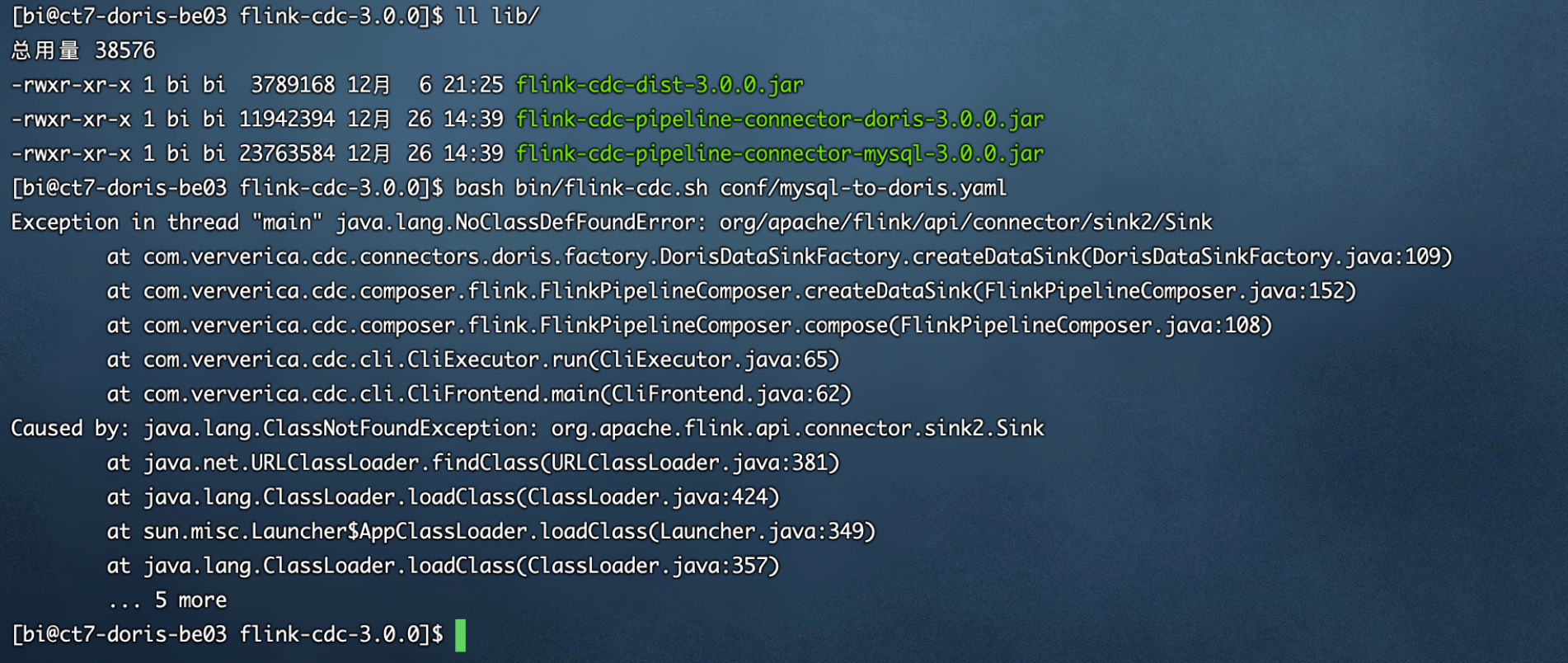

根据您提供的问题和知识库中的相关资料,以下是关于Flink CDC在Flink 1.18版本中无法正常运行的可能原因及解决方案:

Flink CDC 3.0 是一个基于 Flink 的流式 ETL 数据摄取框架,其功能依赖于底层 Flink 引擎的支持。然而,Flink CDC 的某些特性可能对 Flink 版本有特定要求。

解决方法: - 升级到更高版本的 Flink(如 Flink 1.19 或更高),以获得更好的兼容性和功能支持。 - 如果必须使用 Flink 1.18,请尝试降级 Flink CDC 至 2.x 版本,确保两者兼容。

Flink CDC 3.0 的 YAML 数据摄取作业开发需要额外的配置和依赖支持。如果配置不完整或依赖未正确加载,可能导致作业无法启动。

flink-connector-mysql-cdc 和其他相关库)。解决方法: 1. 检查项目的 pom.xml 或 build.gradle 文件,确保引入了正确的 Flink CDC 依赖。例如:

<dependency>

<groupId>com.ververica</groupId>

<artifactId>flink-connector-mysql-cdc</artifactId>

<version>3.0.0</version>

</dependency>

如果上游 MySQL 数据库在全量阶段发生了表结构变更,可能会导致 Flink CDC 作业报错或无法同步。

解决方法: 1. 停止当前作业。 2. 删除下游表,并清理状态后重新启动作业。 3. 避免在全量阶段进行不兼容的表结构变更。

Flink CDC 作业对 CPU 和内存资源的需求较高,尤其是在全量同步阶段。如果资源配置不足,可能导致作业运行失败。

finish split response timeout 异常通常由 Task Manager 的 CPU 使用率过高引起。解决方法: - 在资源配置页面增加 Task Manager 的 CPU 和内存资源。 - 如果作业规模较大,考虑启用水平扩展以动态调整资源。

从 Flink 1.13 开始,默认的 SQL Planner 切换为 BlinkPlanner,这可能导致部分语法和 API 不兼容。

解决方法: - 检查 SQL 作业中的语法和依赖是否符合 Flink 1.18 的要求。 - 如果存在不兼容问题,参考官方迁移指南进行调整。

ClassNotFoundException 或 NoSuchMethodError 等异常。如果问题仍未解决,建议提交工单并提供详细的错误日志,以便进一步排查。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。