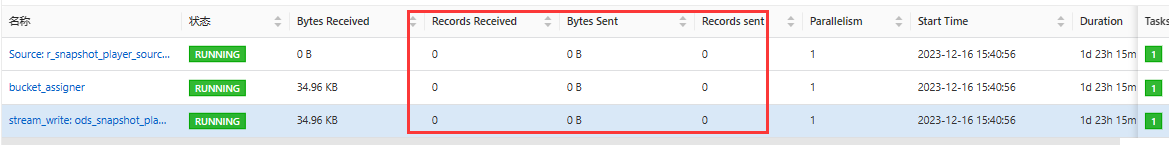

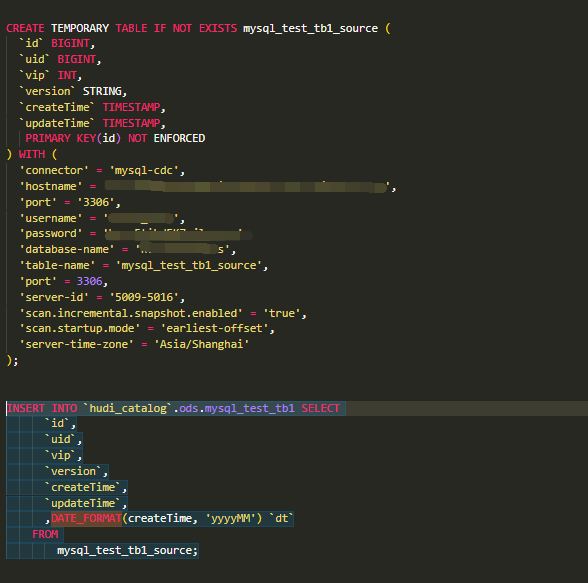

Flink这个mysql-cdc到hudi的,为啥一直没有数据同步,source正常情况下每秒都有上千条数据?sql作业

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

楼主你好,根据你的报错提示,个人感觉是数据源配置问题,需要确保正确配置了MySQL CDC的数据源信息,包括主机名、端口号、用户名、密码等,以及检查MySQL CDC的数据源是否正常,是否有数据产生。

还有可能是Flink作业配置问题,需要检查你的Flink作业的配置,包括CDC Source的相关配置和Hudi Sink的配置,确保CDC Source正确读取到了MySQL CDC的数据,并将数据正确传递给Hudi Sink。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。