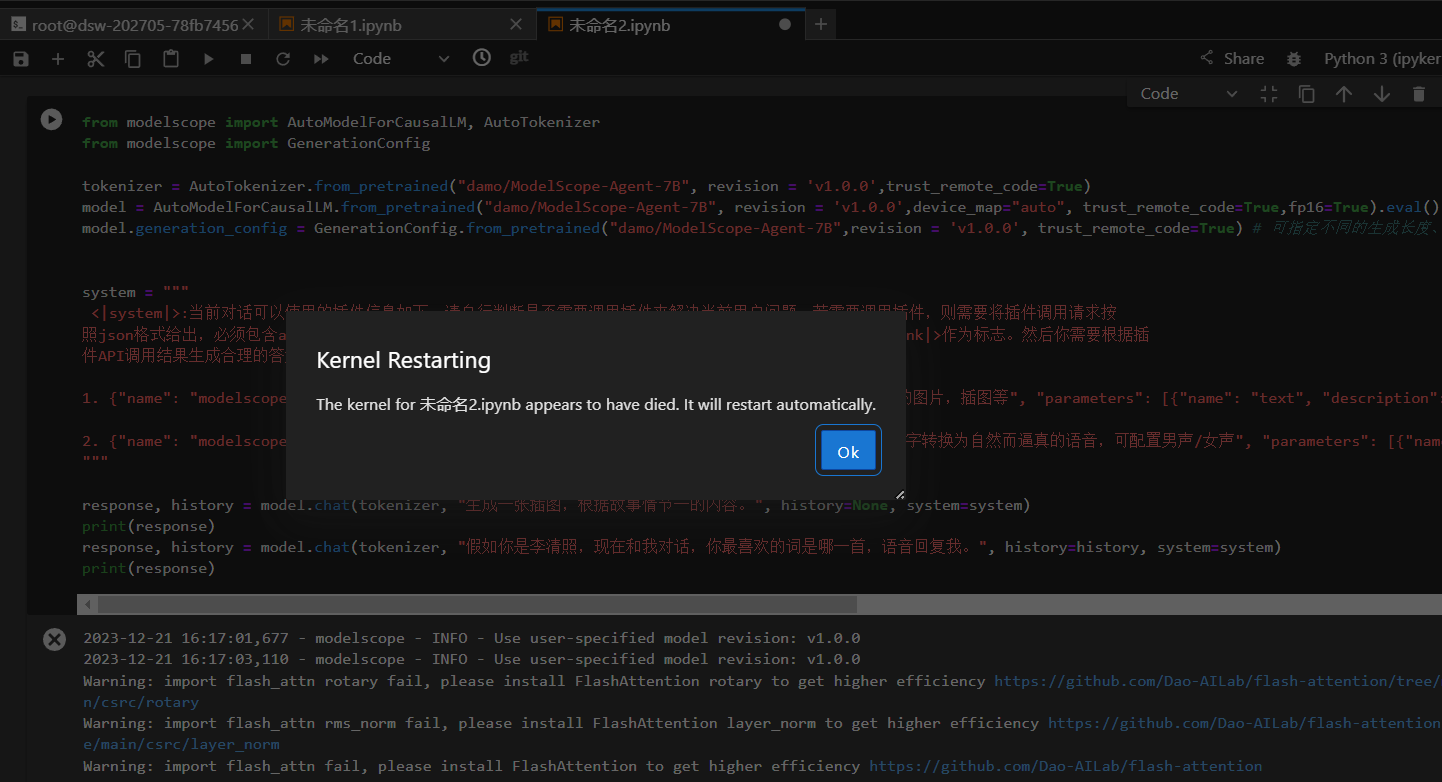

ModelScope有时候就出现这样。没有几个模型可以跑通的呀?

https://modelscope.cn/models/ZhipuAI/cogagent-chat/summary

在使用ModelScope时,如果遇到“没有几个模型可以跑通”的问题,可能是由于以下几个原因导致的。以下是一些可能的原因及解决方法:

某些模型可能需要特定的环境配置或依赖库才能正常运行。例如,部分模型可能需要安装额外的Python库(如torch、opencv-python等)或特定版本的深度学习框架。

pip3 install -r requirements.txt

pip3 install torch torchvision opencv-python timm librosa transformers

在部署模型时,资源配置(如GPU型号、显存大小等)可能会影响模型的运行效果。例如,某些大模型(如DeepSeek-R1-Distill-Qwen-14B-GGUF)需要Ada系列显卡,并且至少预留48G显存。

Q4_K_M.gguf),以降低显存占用。在调用模型服务时,可能会因为API接口配置错误或Token权限问题导致无法正常运行。

service_url)和服务Token(token)。使用以下代码测试模型服务调用是否正常:

import requests

import json

service_url = 'YOUR_SERVICE_URL'

token = 'YOUR_SERVICE_TOKEN'

resp = requests.post(service_url,

headers={"Authorization": token},

data=json.dumps({"input": {"text": "测试输入"}}))

print(resp.text) # 输出为模型的输出结果

YOUR_SERVICE_URL和YOUR_SERVICE_TOKEN为您实际的服务地址和Token。某些模型可能存在未修复的Bug或不完善的功能,导致无法正常运行。例如,您提到的ZhipuAI/cogagent-chat模型,可能在某些场景下存在限制或兼容性问题。

ChatGLM系列模型。有时,ModelScope平台本身可能存在临时性的网络问题或服务中断,导致模型无法正常加载或运行。

在部署模型时,如果模型ID或GGUF文件配置错误,也可能导致模型无法正常运行。

ModelScope ID: lmstudio-community/DeepSeek-R1-Distill-Qwen-14B-GGUF

GGUF 文件: DeepSeek-R1-Distill-Qwen-14B-Q4_K_M.gguf

如果您在ModelScope上遇到模型无法跑通的问题,建议按照以下步骤排查: 1. 检查环境依赖是否完整。 2. 确认资源配置是否符合模型要求。 3. 验证API接口调用是否正确。 4. 查看模型是否存在已知问题。 5. 确保模型ID和文件配置无误。

如果以上方法仍无法解决问题,建议联系ModelScope的技术支持团队,提供详细的错误日志以便进一步排查。

重要提醒: 在选择模型时,请优先选择经过验证的稳定版本,并确保您的硬件和软件环境满足模型的最低要求。