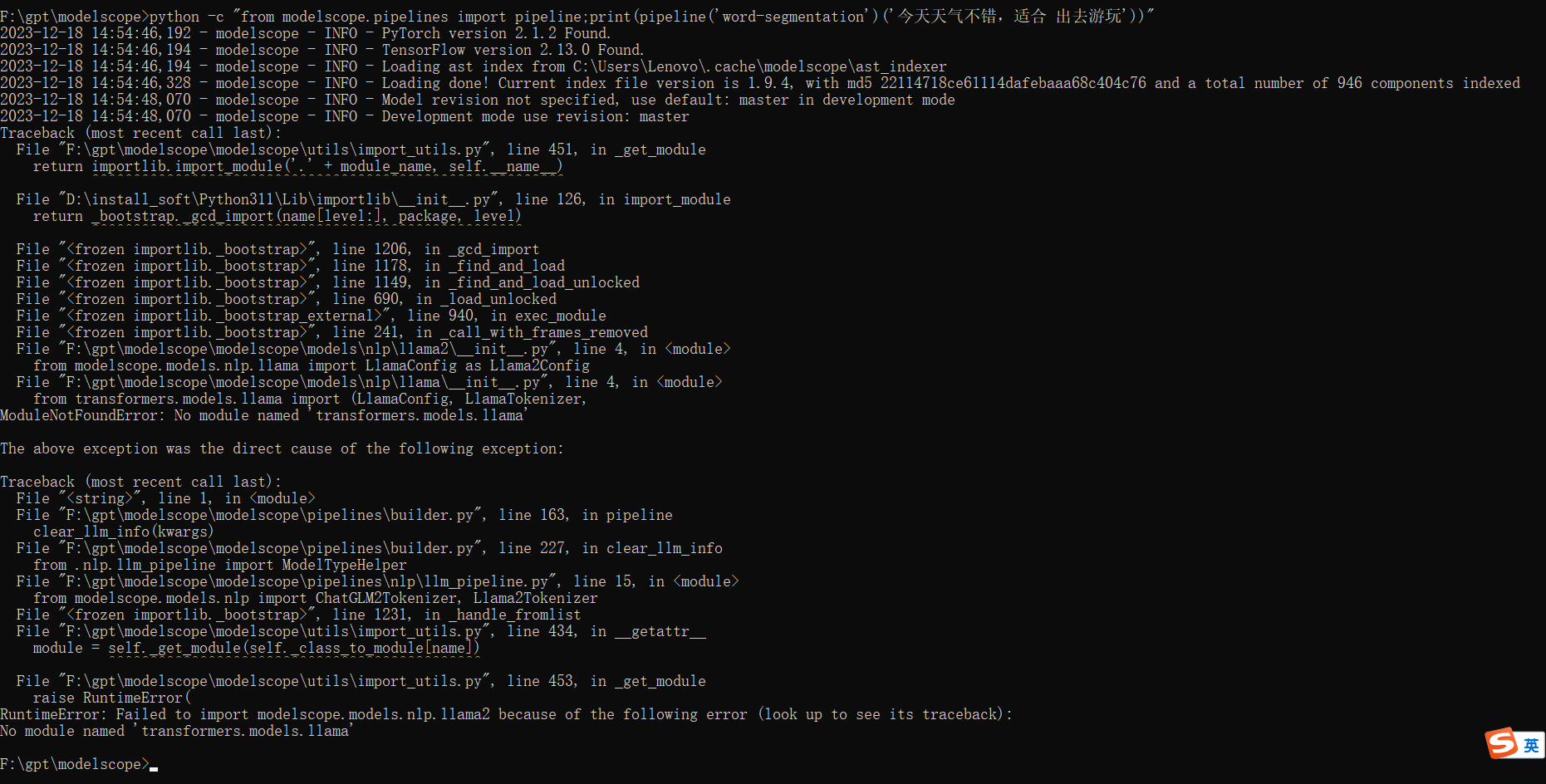

ModelScope模型要怎么放呢?我是直接下载https://github.com/modelscope/modelscope.git这个,然后跟着运行pip install ".[nlp]" -f https://modelscope.oss-cn-beijing.aliyuncs.com/releases/repo.html 后面运行python -c "from modelscope.pipelines import pipeline;print(pipeline('word-segmentation')('今天天气不错,适合 出去游玩'))" 就出现了

要正确使用ModelScope模型并解决您遇到的问题,以下是详细的步骤和说明:

根据知识库中的信息,您无需直接从GitHub克隆https://github.com/modelscope/modelscope.git,而是通过官方推荐的方式安装ModelScope。以下是正确的安装步骤:

运行以下命令以安装ModelScope及其依赖项:

pip install modelscope -f https://modelscope.oss-cn-beijing.aliyuncs.com/releases/repo.html

此命令会从ModelScope的官方镜像源安装最新版本的ModelScope。

安装完成后,可以通过以下命令验证是否成功安装:

python -c "import modelscope; print(modelscope.__version__)"

如果输出了版本号(例如1.12.0),则说明安装成功。

ModelScope支持通过snapshot_download函数下载模型。以下是具体操作步骤:

在Python环境中运行以下代码,下载所需的模型文件:

from modelscope.hub.snapshot_download import snapshot_download

# 替换为您需要的模型ID

model_dir = snapshot_download('LLM-Research/Meta-Llama-3-8B-Instruct', cache_dir='.', revision='master')

print(f"模型已下载至: {model_dir}")

注意:

- cache_dir参数指定了模型的下载路径,默认为当前目录。 - 如果您需要其他模型,请替换LLM-Research/Meta-Llama-3-8B-Instruct为对应的模型ID。

运行上述代码后,model_dir变量会返回模型的具体下载路径。您可以打印该路径以确认模型文件的位置。

完成模型下载后,您可以加载模型并进行推理。以下是示例代码:

运行以下代码加载分词任务的Pipeline:

from modelscope.pipelines import pipeline

# 加载分词任务Pipeline

word_segmentation_pipeline = pipeline('word-segmentation')

# 测试分词功能

result = word_segmentation_pipeline('今天天气不错,适合 出去游玩')

print(result)

如果一切正常,您应该能够看到类似以下的输出:

{'text': '今天天气不错,适合 出去游玩', 'output': ['今天', '天气', '不错', ',', '适合', '出去', '游玩']}

如果您在运行过程中遇到问题,请参考以下解决方案:

如果出现网络连接问题,可能是因为您所在的环境无法直接访问ModelScope的资源。请尝试设置代理后再重新运行相关命令。

某些模型可能需要额外的依赖项。例如,部分NLP模型需要安装transformers或torch。您可以通过以下命令安装这些依赖项:

pip install transformers torch

确保您下载的模型路径正确,并且模型文件完整。如果模型文件损坏或不完整,可以删除缓存目录(默认为~/.cache/modelscope)后重新下载。

如果您希望将模型部署为在线服务,可以参考以下步骤:

在ModelScope官网找到目标模型页面,记录以下信息: - MODEL_ID:模型ID。 - TASK:模型的任务类型。 - REVISION:模型版本。

登录PAI控制台,进入EAS模型在线服务页面,按照以下步骤配置: 1. 单击部署服务,选择自定义模型部署。 2. 在镜像配置中选择modelscope-inference镜像。 3. 配置环境变量:

MODEL_ID=<您的MODEL_ID>

TASK=<您的TASK>

REVISION=<您的REVISION>

通过上述步骤,您可以正确安装、下载和使用ModelScope模型。如果仍有问题,请检查网络连接、依赖项安装以及模型路径是否正确。如有进一步疑问,请提供更多错误信息以便我们协助解决。