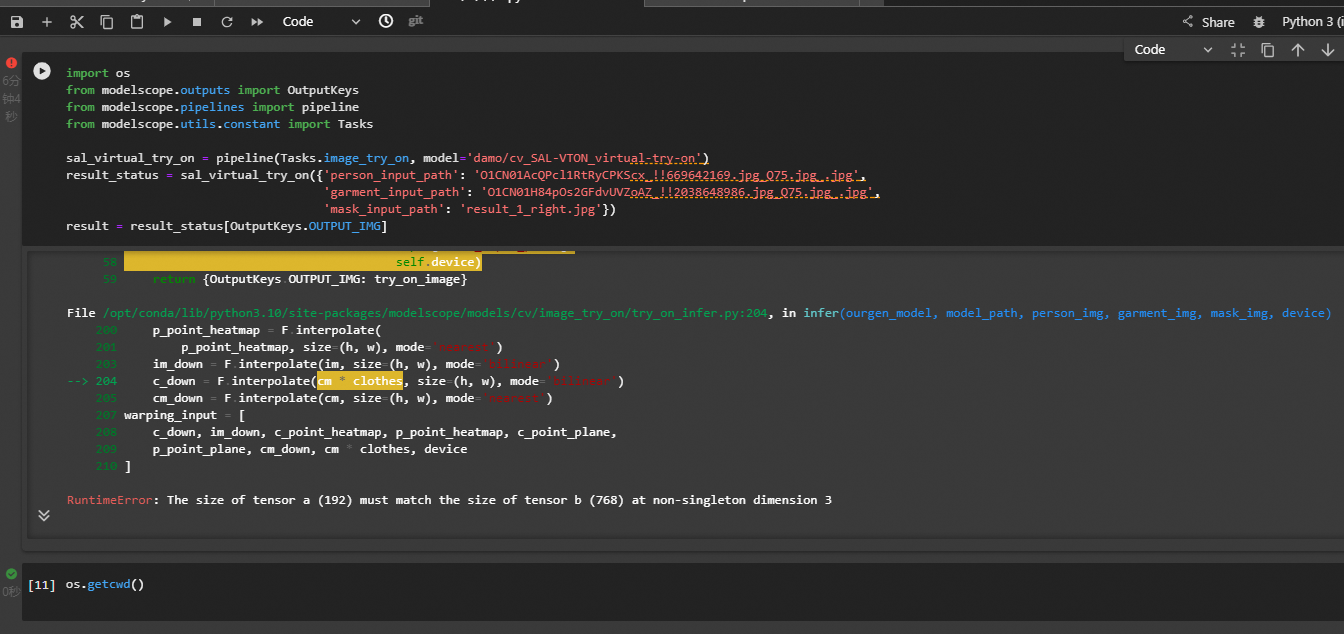

ModelScope把图片都处理成同样大小后还是会报错?The size of tensor a (192) must match the size of tensor b (768) at non-singleton dimension 3

根据您提供的错误信息 The size of tensor a (192) must match the size of tensor b (768) at non-singleton dimension 3,这表明在处理图片时,尽管图片已经被调整为相同的大小,但在模型的输入或处理过程中仍然存在张量维度不匹配的问题。以下是可能的原因及解决方案:

即使图片被调整为相同大小,某些模型对输入数据的要求可能更加严格,例如: - 通道数(Channel)不一致:某些模型要求输入图片必须是 RGB 格式(3 通道),而您的图片可能是灰度图(1 通道)或其他格式。 - 分辨率与模型预期不符:虽然图片大小一致,但模型可能对分辨率有特定要求,例如需要满足某种比例或固定尺寸。

from PIL import Image

img = Image.open("input_image_path").convert("RGB")

img.save("output_image_path")

错误信息中的 non-singleton dimension 3 表明张量在第 3 维(通常是通道维度)上不匹配。这可能是由于: - Batch 处理问题:如果您将多张图片打包成一个批次(batch)进行处理,可能某些图片的通道数或分辨率与其他图片不一致。 - 模型内部操作限制:某些模型在处理输入时会对张量进行特定的操作(如拼接、合并等),如果输入张量的形状不一致,会导致报错。

在将图片输入模型之前,检查每张图片的形状是否一致。可以使用以下代码验证:

import numpy as np

from PIL import Image

def check_image_shapes(image_paths):

shapes = []

for path in image_paths:

img = Image.open(path)

shapes.append(np.array(img).shape)

return shapes

image_paths = ["image1.jpg", "image2.jpg", "image3.jpg"]

print(check_image_shapes(image_paths))

如果发现形状不一致,请统一调整图片的大小和通道数。

如果使用批量处理,请确保所有图片的张量形状完全一致。例如,使用 PyTorch 时,可以通过以下代码对图片进行填充或裁剪:

from torchvision import transforms

transform = transforms.Compose([

transforms.Resize((256, 256)), # 调整大小

transforms.ToTensor(), # 转换为张量

])

images = [transform(Image.open(path)) for path in image_paths]

batch = torch.stack(images) # 将图片打包成批次

ModelScope 中的某些模型可能对输入数据有额外的限制。例如: - 输入图片的分辨率范围:某些模型可能要求图片的宽高比小于 2.0,且最大边长不超过 4096 像素。 - 图片格式限制:支持的图片格式通常包括 JPEG、JPG、PNG、BMP 和 WEBP。如果图片格式不符合要求,可能会导致处理失败。

如果图片分辨率过大,可以通过缩放参数调整图片大小。例如:

from PIL import Image

img = Image.open("input_image_path")

img = img.resize((512, 512)) # 调整为模型支持的分辨率

img.save("output_image_path")

通过以上步骤,您可以有效解决 The size of tensor a (192) must match the size of tensor b (768) 的问题。如果问题仍然存在,建议进一步检查模型的具体实现或联系 ModelScope 技术支持团队获取帮助。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。