烦问一下,ModelScope我在使用damo/nlp_structbert_siamese-uninlu_chinese-base模型的时候,正常情况下调用,100长度的文本推理耗时0.01秒左右,等调用量激增后,同样的文本长度,推理耗时增长100倍,差不多耗时1秒左右,麻烦问一下,该模型在使用的时候是否有些需要注意的地方,比如释放资源之类的?damo/nlp_structbert_siamese-uninlu_chinese-base这个模型是否支持批量推理,如果支持,该如何使用?

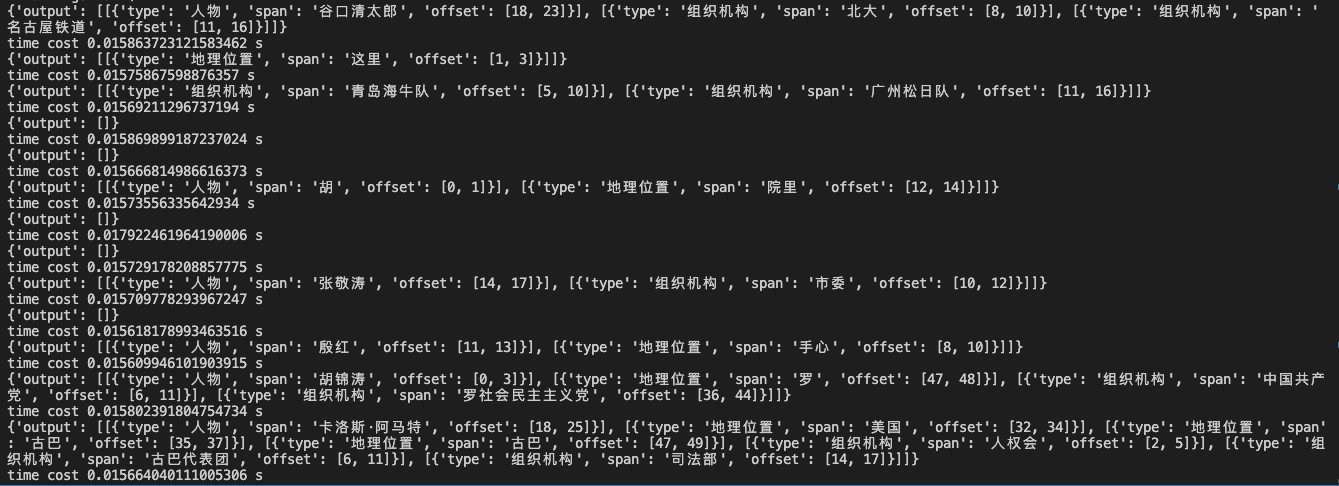

这边pipeline推理第一次慢,后面for循环推理的时候时间短;这是for循环中不同的input 另外看您的问题应该是想多线程/多进程处理,这个没有代码示例,可以参考一般的python代码操作。此回答整理自钉群“魔搭ModelScope开发者联盟群 ①”

另外看您的问题应该是想多线程/多进程处理,这个没有代码示例,可以参考一般的python代码操作。此回答整理自钉群“魔搭ModelScope开发者联盟群 ①”