拷贝ofa_ocr-recognition_general_base_zh模型到内网服务中,通过指定模型位置为本地目录,如下

ocr_recognize = pipeline(task=Tasks.ocr_recognition, model="/home/projects/modelscope/models/ofa_ocr-recognition_general_base_zh")

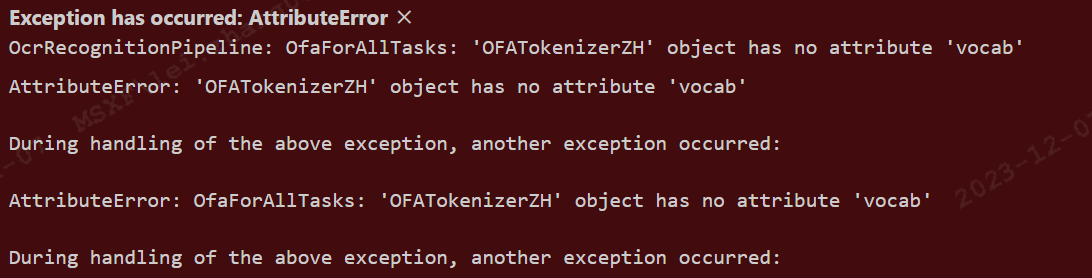

报错信息如下

请问是什么原因,改如何解决,谢谢

一楼说的是对的但是对于我们小白来说,需要配置transformers环境和OFA环境

git clone --single-branch --branch feature/add_transformers https://github.com/OFA-Sys/OFA.git

pip install OFA/transformers/

git clone https://huggingface.co/OFA-Sys/OFA-tiny

这个错误信息意味着在尝试访问OFATokenizerZH对象的vocab属性时失败了,因为该属性不存在。在使用transformers库的模型时,通常会在加载模型之后初始化一个tokenizer,并且tokenizer会有一个名为vocab的属性。

你遇到这个问题可能是因为:

tokenizer未正确加载或初始化:检查你的代码是否正确地初始化了一个tokenizer并将其与模型相关联。对于OFA模型,你可以通过以下方式创建一个tokenizer:

from transformers import OFATokenizer

tokenizer = OFATokenizer.from_pretrained("/home/projects/modelscope/models/ofa_ocr-recognition_general_base_zh")

如果您希望将 "ofa_ocr-recognition_general_base_zh" 模型从云端拷贝到内网服务中并指定模型位置为本地目录,可以按照以下步骤进行操作:

首先,在云端上将模型文件 "ofa_ocr-recognition_general_base_zh" 下载到本地。您可以使用阿里云的对象存储服务 OSS 或其他文件传输方式来下载模型文件。

将下载的模型文件 "ofa_ocr-recognition_general_base_zh" 复制到您的内网服务中的指定目录(例如 "/home/projects/modelscope/models/")。

在您的内网服务代码中,通过指定模型的本地路径来加载该模型。根据您提供的示例代码,可以将 model 参数设置为 "/home/projects/modelscope/models/ofa_ocr-recognition_general_base_zh",如下所示:

ocr_recognize = pipeline(task=Tasks.ocr_recognition, model="/home/projects/modelscope/models/ofa_ocr-recognition_general_base_zh")

确保在指定模型路径时使用正确的本地路径,并确保模型文件位于指定路径中。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352