Flink CDC读取不到mongo的数据,有大大碰到过这种问题没,怪的一批?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

对于Flink CDC无法读取MongoDB数据的问题,可能的原因和解决方案如下:

检查Flink CDC配置中的相关参数,例如cdc.source.poll-interval(轮询间隔)和cdc.source.max-pending-splits(最大待处理分片数)。如果这些参数设置不合适,可能会影响数据的读取。您可以尝试适当调整这些参数进行优化。

考虑增加Flink CDC作业的并行度,以便更好地利用计算资源。

确保服务器上的环境和依赖项与本地环境相同,包括Flink版本、MongoDB Connector for Flink版本等。检查日志文件,查看是否有任何错误或异常信息。

检查MongoDB的性能和资源利用情况,确保MongoDB能够提供足够的读取速度。

如果问题依旧存在,您可以考虑使用MongoDB CDC连接器。这是一个Flink Source连接器,支持从MongoDB读取快照数据和增量数据。它支持多种启动模式,并且即使在作业任何阶段失败都能保证Exactly-once语义。

好像这个问题跟我当时用 mysql cdc差不多,我那个时候是还有mysql-connector-java的驱动,版本没对应上,也查不到数据,换了文档里面的8.0.27,就好了,你看看是不是依赖冲突 ,此回答整理自钉群“Flink CDC 社区”

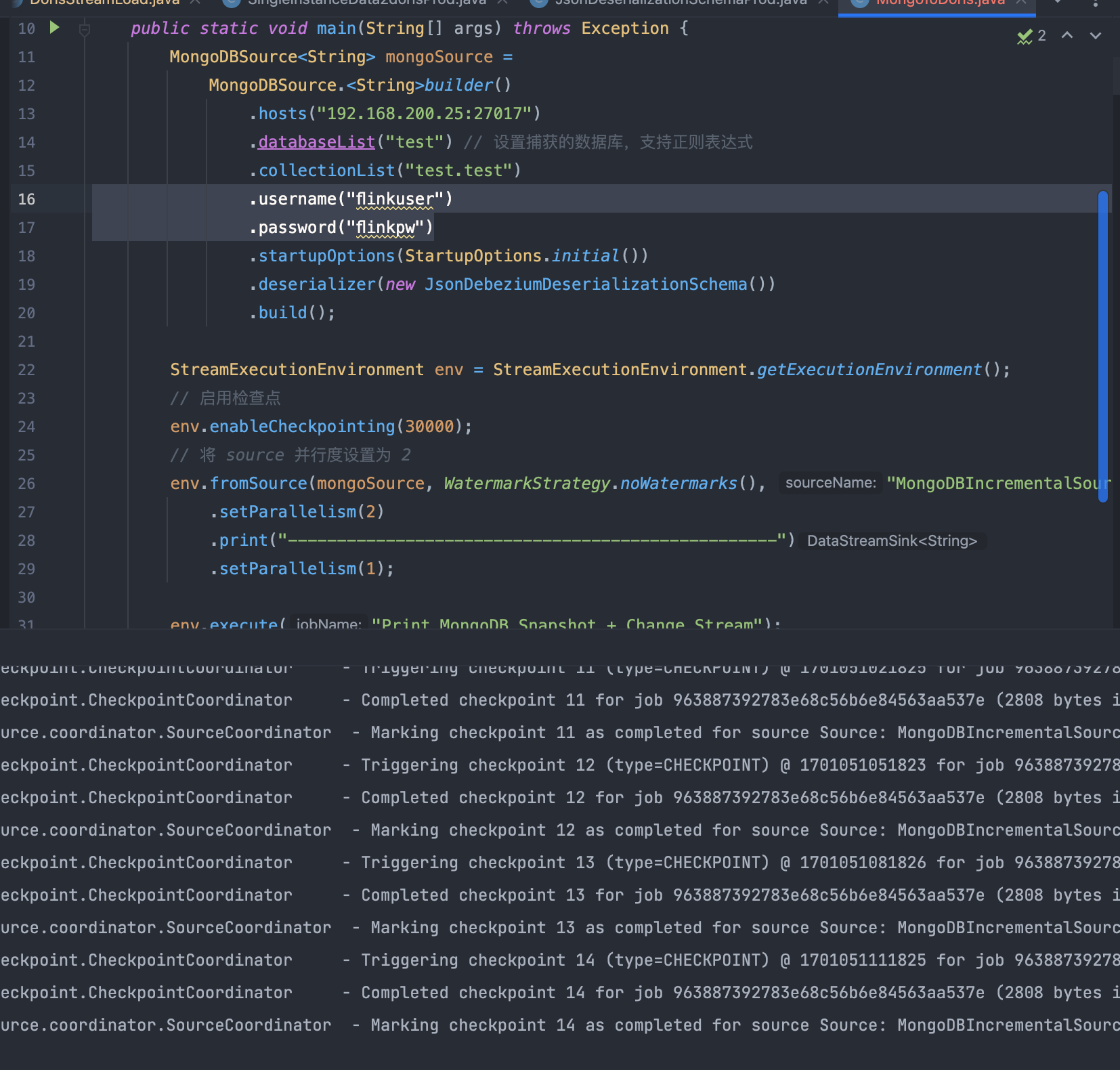

根据您提供的代码,您正在使用Flink CDC从MongoDB中读取增量数据。Flink CDC是一个用于从数据库中读取增量数据的工具,它可以处理数据库中的数据变更,并将这些变更作为事件流发送到Flink。

在您的代码中,您首先创建了一个MongoDBSource对象,该对象用于从MongoDB中读取数据。然后,您创建了一个StreamExecutionEnvironment对象,并使用getExecutionEnvironment()方法获取了执行环境。在执行环境中,您启用了检查点,并将数据源设置为从MongoDB源读取的数据。

接下来,您使用fromSource()方法将数据源转换为Flink数据流,并设置了并行度为2。然后,您使用print()方法将数据流打印到控制台,并使用setParallelism()方法将数据流的并行度设置为1。

最后,您使用execute()方法执行了Flink作业,并指定了作业的名称为"Print MongoDB Snapshot + Change Stream"。

根据您提供的日志,Flink正在触发检查点,并将检查点写入到检查点协调器。检查点是Flink用于容错和恢复数据流状态的重要机制。检查点协调器负责管理检查点的生成和恢复。

如果Flink无法从MongoDB源读取数据,可能有以下几种原因:

MongoDB源配置错误:请确保MongoDB源的配置正确,包括连接字符串、数据库名、集合名等。如果配置错误,Flink可能无法连接到MongoDB源。

MongoDB源不可用:请确保MongoDB源正在运行,并且可以被Flink访问。如果MongoDB源不可用,Flink将无法从它读取数据。

MongoDB源数据不完整:如果MongoDB源中的数据不完整或存在错误,Flink可能无法从它读取数据。请检查MongoDB源中的数据,确保它们是完整且正确的。

Flink作业配置错误:请检查Flink作业的配置,确保它正确地指定了数据源和数据流的并行度。如果配置错误,Flink可能无法正确地从数据源读取数据。

网络问题:如果Flink和MongoDB源之间的网络连接存在问题,Flink可能无法从MongoDB源读取数据。请检查网络连接,确保它们是可用的。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。