Flink为什么找不到这个包呢?

Flink为什么找不到这个包呢?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

十分耕耘,一定会有一分收获!

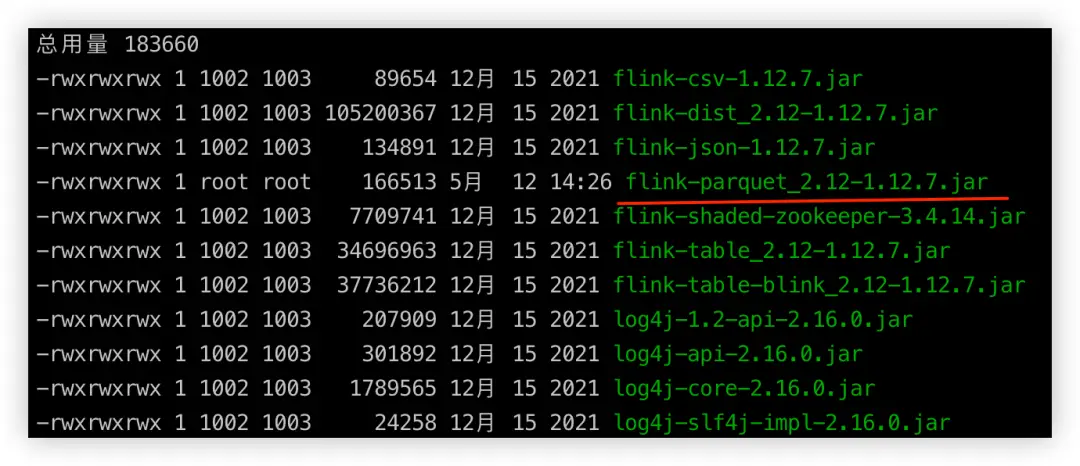

楼主你好,看了你的描述,个人觉得是你的依赖不兼容造成的,你可以检查一下这个包的名字是否正确,还有就是检查下flink-sql-connector-hive-3.1.3_2.12.jar 是否已经正确地添加到了项目的类路径中了。

2024-01-27 15:25:37赞同 展开评论 -

-

某政企事业单位安全运维工程师,主要从事系统运维及网络安全工作,多次获得阿里云、华为云、腾讯云征文比赛一二等奖;CTF选手,白帽,全国交通行业网络安全大赛二等奖,全国数信杯数据安全大赛银奖,手握多张EDU、CNVD、CNNVD证书,欧盟网络安全名人堂提名,联合国网络安全名人堂提名

看起来像是依赖项定义的问题。 首先检查下flink-sql-connector-hive-3.1.3_2.12.jar 是否已经正确地添加到了项目的类路径中了。确保它位于Maven本地仓库中,并且可以在构建过程中被编译器识别到。

其次,确认下你在pom.xml 文件中引用 flink-sql-connector-hive 的 groupId 和 artifactId 是否是正确的:

<dependency> <groupId>org.apache.flink</groupId> <artifactId>flink-sql-connector-hive-3.1.3_2.12</artifactId> <!-- 这里需要填写的是正确的Hadoop版本 --> <version>1.17.1</version> </dependency>最后,你需要确保你的项目所基于的Flink版本与此jar 包兼容。比如这里提到的 flink-sql-connector-hive-3.1.3_2.12 应当与Apache Flink 1.17.x系列相匹配。如果不是这样,可能会导致找不到所需的类或者方法。

希望以上的解答能帮到你解决问题。

2024-01-13 14:38:26赞同 1 展开评论 -

北京阿里云ACE会长

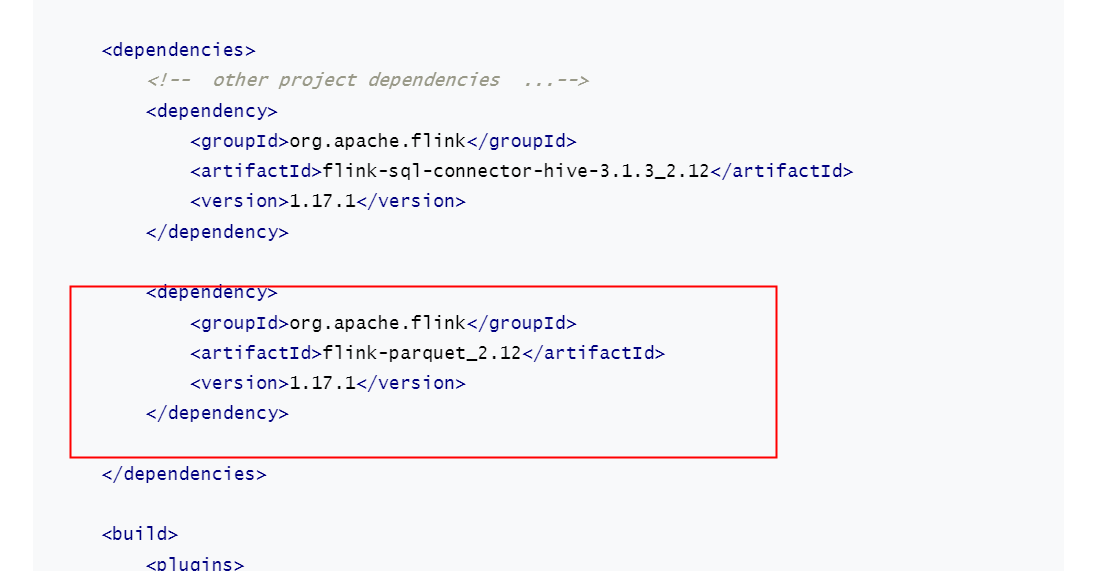

在您的Maven依赖中,您尝试添加的flink-sgl-connector-hive-3.1.3 2.12和flink-parquet 2.12依赖项似乎是不存在的。在Maven仓库中,您可能需要查找flink-sgl-connector-hive和flink-parquet依赖项,而不是您提供的这些版本和名称。

请尝试将您的依赖项更改为以下内容:

org.apache.flink

flink-sgl-connector-hive

1.17.1

org.apache.flink

flink-parquet

1.17.1

这样,您将使用Flink的Hive连接器和Parquet支持,而不是特定的版本。请确保您的Maven仓库具有1.17.1版本的Flink依赖项。如果您使用的是Maven中央仓库,可以访问以下URL:

https://search.maven.org/artifact/org.apache.flink/flink-sgl-connector-hive

https://search.maven.org/artifact/org.apache.flink/flink-parquet2024-01-12 21:45:01赞同 展开评论 -

看起来像是Maven项目中的pom.xml文件的一部分。如果依赖没有找到,可能是由于以下几个原因之一:

Maven仓库的问题:这通常意味着你的系统缺少可用的Maven中央仓库或其他任何存储库。你应该检查你的Maven配置以确保所有必要的仓库都被正确地指定了。

版本不匹配:有时候,可能会出现某个项目的依赖关系与其他项目不匹配的情况。在这种情况下,请确保所有相关的依赖都有合适的版本号。

错误的依赖声明:有时,错误的依赖声明会导致依赖关系丢失。仔细检查你的pom.xml文件,特别是那些红色框起来的部分,确保它们都是正确的。

脚手架模板问题:如果你是从脚手架模板复制粘贴过来的话,有些部分可能已经被注释掉了。去掉注释就可以正常使用了。

为了帮助解决这个问题,我建议按照以下顺序操作:

- 清理缓存:执行 "mvn clean" 命令清理Maven缓存。

- 更新Maven仓库:确保你的Maven配置正确无误,包括所有必需的仓库都在那里。

- 删除不必要的依赖:删除不需要的依赖,尤其是那些带有红色方块标记的依赖。

- 使用最新的依赖版本:尝试更换依赖版本,比如将

<version>1.17.1</version>更改为更高版本,然后再试一试。 - 查找缺失的依赖:如果有缺失的依赖,尝试手动引入它们。

2024-01-12 17:22:05赞同 展开评论 -

建议您在作业开发时先进行依赖配置,以避免Flink依赖冲突问题,配置详情请参见如何解决Flink依赖冲突问题?https://help.aliyun.com/zh/flink/support/reference?spm=a2c4g.11186623.0.i70#section-bqc-stj-zha

2024-01-12 13:59:23赞同 展开评论

2024-01-12 13:59:23赞同 展开评论

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。