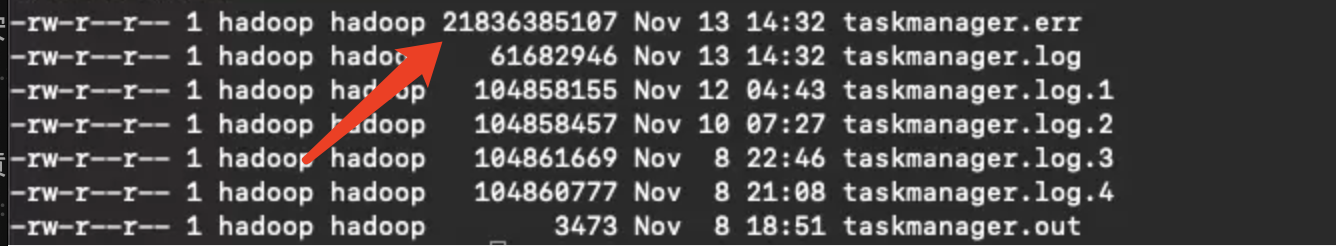

Flink可以配置滚动tm.err和tm.out文件吗?业务经常写满机器磁盘

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在Apache Flink中,你可以配置滚动tm.err和tm.out文件来避免它们占满整个磁盘。Flink的taskmanager.log.path配置可以用来指定这些文件的存储位置。

然而,Flink本身并没有提供直接配置滚动这些文件的选项。你可以通过操作系统的脚本或cron任务来实现这个需求。例如,在Linux上,你可以使用logrotate工具或者编写一个自定义的脚本定期清理这些文件。

以下是一个简单的bash脚本示例,它会定期清理tm.err和tm.out文件:

#!/bin/bash

# 定义需要清理的文件路径

LOG_PATH="/path/to/flink/logs/"

# 定义保留文件的天数

DAYS_TO_KEEP=7

# 删除多余的文件

find $LOG_PATH -name "tm.err" -mtime +$DAYS_TO_KEEP -exec rm {} \;

find $LOG_PATH -name "tm.out" -mtime +$DAYS_TO_KEEP -exec rm {} \;

你可以将这个脚本保存为一个.sh文件,然后使用cron任务定期运行它。例如,如果你想每天凌晨3点清理这些文件,你可以添加以下行到你的crontab文件:

0 3 * * * /path/to/your/script.sh

是的,Flink可以配置滚动生成tm.err和tm.out文件。当业务运行时间长时,日志文件会非常大,这可能导致机器磁盘被写满。为了避免这种情况并提高日志查看的效率,可以对Flink的日志进行滚动配置。

滚动日志的配置方式主要有三种:在代码中指定、提交任务时指定以及通过log4j.properties配置文件进行配置。例如,对于log4j.properties文件,可以进行如下配置来实现日志滚动:

log4j.appender.file.File=/path/to/your/log/file.log

log4j.appender.file.MaxFileSize=10MB

log4j.appender.file.MaxBackupIndex=10

log4j.appender.file.layout=org.apache.log4j.PatternLayout

log4j.appender.file.layout.ConversionPattern=%d{yyyy-MM-dd HH:mm:ss} %-5p %c{1}:%L - %m%n

上述配置中,MaxFileSize定义了每个滚动文件的最大大小,超过这个大小的文件将生成新的滚动文件;MaxBackupIndex定义了保留的滚动文件个数。这样,长期运行的项目如flink和sparkstreaming,即使产生大量日志,也只会保留最近的10个日志,大大减少了对网络宽带和系统的影响。

Flink 的说明,Flink 本身并没有直接提供滚动日志文件(如 tm.err 和 tm.out)的配置选项,但您可以使用第三方日志收集框架(如 Logstash、Fluentd 等)将日志收集起来,并将它们导出到其他地方(如 Elasticsearch 等)。这样可以避免日志文件越来越大并且方便日志管理和分析。

以下是一般步骤:

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。