Flink CDC先前的版本,有这样的问题导致数据丢失场景?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

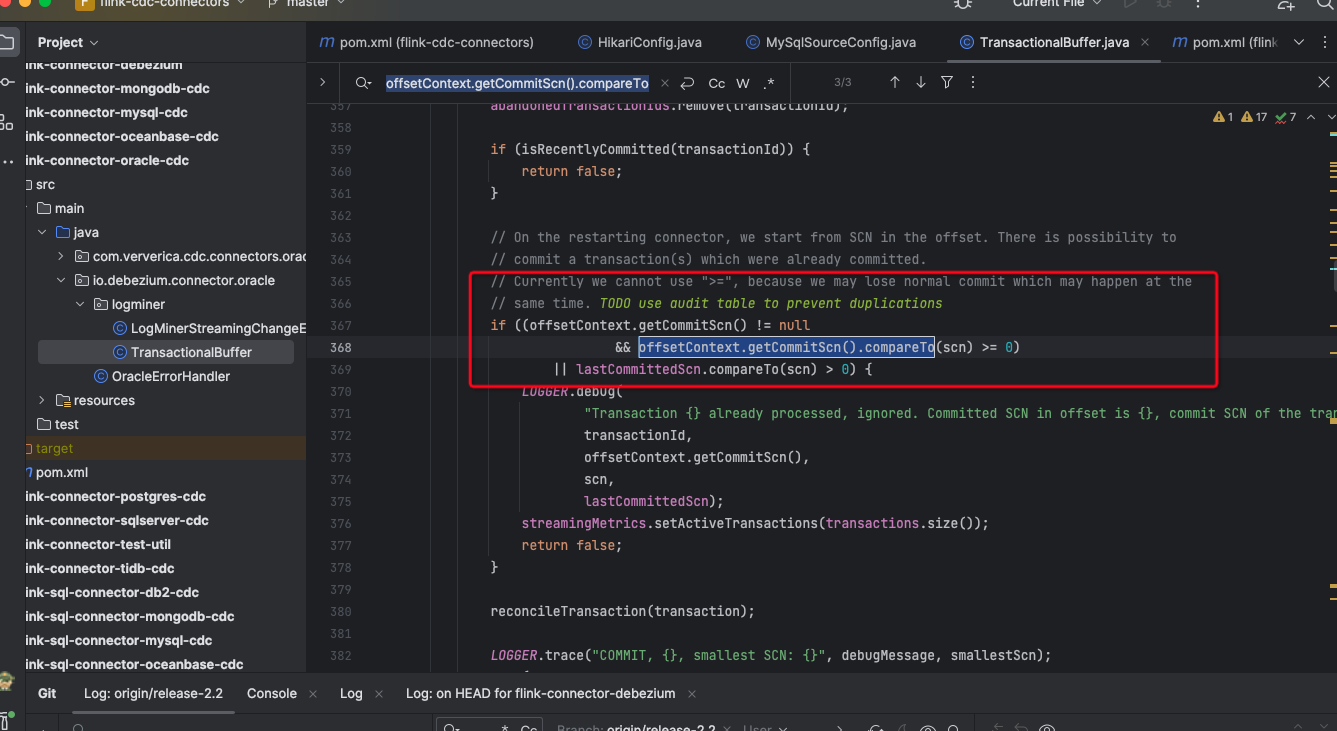

在早期版本的 Flink CDC 中,确实存在可能导致数据丢失的现象。以下是常见的可能导致数据丢失的情况:

为了避免这种情况,您可以采取以下方法:

Flink CDC是一个基于Change Data Capture(CDC)技术的数据同步工具,可以将关系Flink CDC是一个基于Change Data Capture(CDC)技术的数据同步工具,可以将关系型数据库中的数据实时同步到Flink流处理中进行实时计算和分析。在实现CDC,即捕获数据库的变更数据时,Flink CDC是Flink社区开发的flink-cdc-connectors组件,这是一个可以直接从MySQL、PostgreSQL等数据库直接读取全量数据和增量变更数据的source组件。

然而,在使用Flink CDC时,确实存在数据丢失的场景。这可能是由于配置错误、数据源问题、数据目标问题或网络连接问题导致的。例如,如果是基于查询的CDC,有可能导致两次查询的中间一部分数据丢失,因为每次DML操作均有记录,无需像查询CDC这样发起全表扫描进行过滤。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。