补充下我使用的代码:

from modelscope.utils.constant import Tasks

from modelscope.pipelines import pipeline

pipe = pipeline(task=Tasks.chat, model='/home/model/hub/ZhipuAI/ChatGLM-6B-Int4',devices='cpu')

inputs = {'text':'你好', 'history': []}

result = pipe(inputs)

inputs = {'text':'介绍下清华大学', 'history': result['history']}

result = pipe(inputs)

print(result)

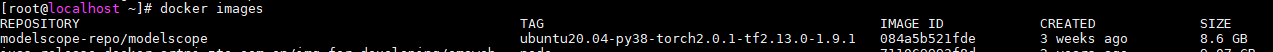

使用的modelscope镜像