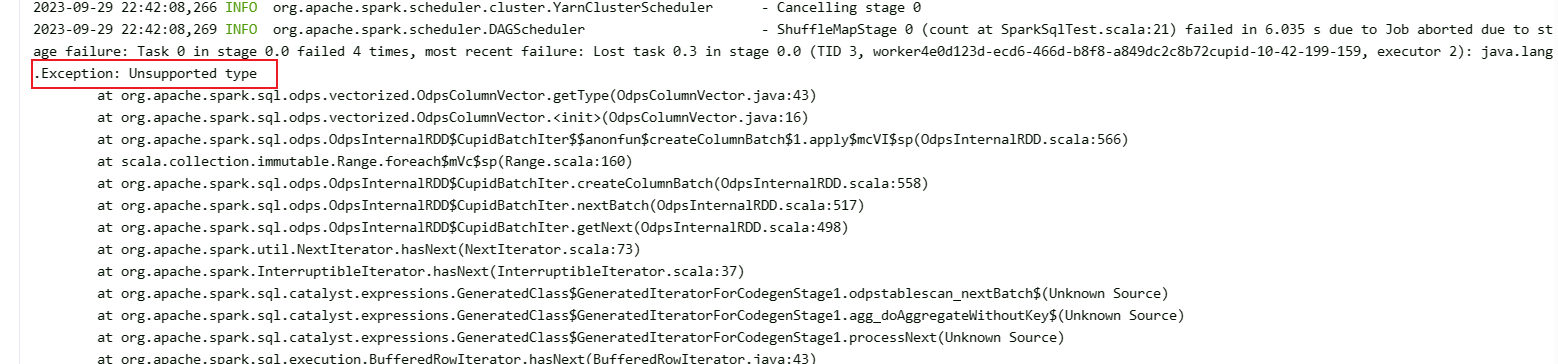

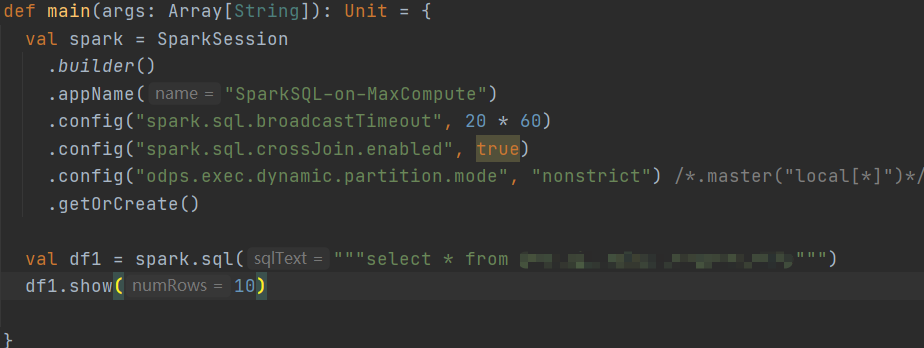

在dataworks中使用spark读取maxcompute表报java.lang.Exception: Unsupported type错误,spark版本用的是2.3.0,使用的是官方提供的样例配置的pom,可以确定的是这个测试代码在其他项目中是可以正常执行的,请问这是什么原因导致的?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

出现java.lang.Exception: Unsupported type错误可能是由于数据类型不受支持或Spark与MaxCompute之间的兼容性问题导致的。这种情况可能因版本差异、配置问题或数据类型不匹配而有所不同。

以下是一些可能导致此错误的原因和解决方法:

1. 版本兼容性问题: 确保您使用的Spark版本与MaxCompute版本兼容。不同版本的Spark和MaxCompute之间可能存在兼容性问题,例如API变化或底层库的不匹配。请检查DataWorks和MaxCompute文档,以确保您选择的Spark版本与MaxCompute兼容。

2. 依赖项配置问题: 检查您项目的pom.xml文件中的依赖项配置。确保您使用了正确的MaxCompute和Spark相关依赖,并且版本与您正在使用的Spark版本相匹配。您可以参考DataWorks官方文档或样例配置来设置正确的依赖项。

3. 数据类型不匹配: 确保您在Spark代码中正确处理MaxCompute表中的数据类型。数据类型在MaxCompute和Spark之间可能存在差异,例如日期格式或数值类型。请确保您的代码正确地映射和转换MaxCompute表中的数据类型。

4. 配置问题: 检查您的Spark配置是否正确。确保您已经提供了正确的MaxCompute连接信息和凭据,以便Spark可以正确连接到MaxCompute服务。

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。