Flink CDC包都是有的,但在widow正常,上Linux就报错?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用Flink CDC时,如果在Windows环境下运行正常,但在Linux环境下报错,可能是由于以下原因导致的。以下是可能的原因及对应的解决方案:

flink-sql-connector-xxx.jar 是一个 FAT JAR,包含了所有依赖,但如果某些依赖未正确加载或与其他库冲突,可能会导致运行失败。flink-sql-connector-mysql-cdc-2.x.jar),并将其放置在 Flink 的 lib 目录下。mvn dependency:tree 命令分析依赖树,并排除冲突的依赖。flink-connector-xxx.jar,需要手动管理依赖,确保所有必要的第三方库均已正确引入。lib 目录下的 JAR 文件可被读取。\),改为使用 Linux 风格的路径(如 /)。conf/flink-conf.yaml 配置文件,确保关键参数(如 taskmanager.memory.process.size 和 jobmanager.memory.process.size)在 Linux 环境下已正确设置。-Xms 和 -Xmx)在 Linux 环境下与 Windows 环境保持一致。-Dfile.encoding=UTF-8

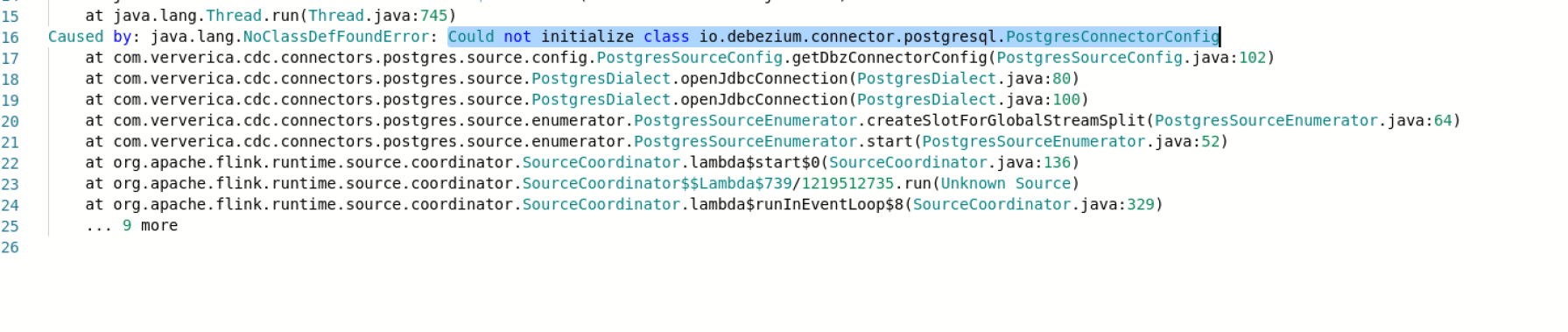

ClassNotFoundException 或 NoClassDefFoundError 的错误,说明某些依赖未正确加载。ROW,可通过以下命令检查和修改:

SHOW VARIABLES LIKE 'binlog_format';

SET GLOBAL binlog_format=ROW;

REPLICA IDENTITY 设置为 FULL,否则可能导致 UPDATE/DELETE 消息的 before 字段为空:

ALTER TABLE yourTableName REPLICA IDENTITY FULL;

com.alibaba.ververica 改为 com.ververica,确保 Maven 配置正确。通过以上步骤逐一排查,应该可以解决在 Linux 环境下运行 Flink CDC 时的报错问题。如果问题仍未解决,请提供具体的报错日志以便进一步分析。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。