Flink CDC2.2.1的mysql-cdc有bug么 有用过的么 ?

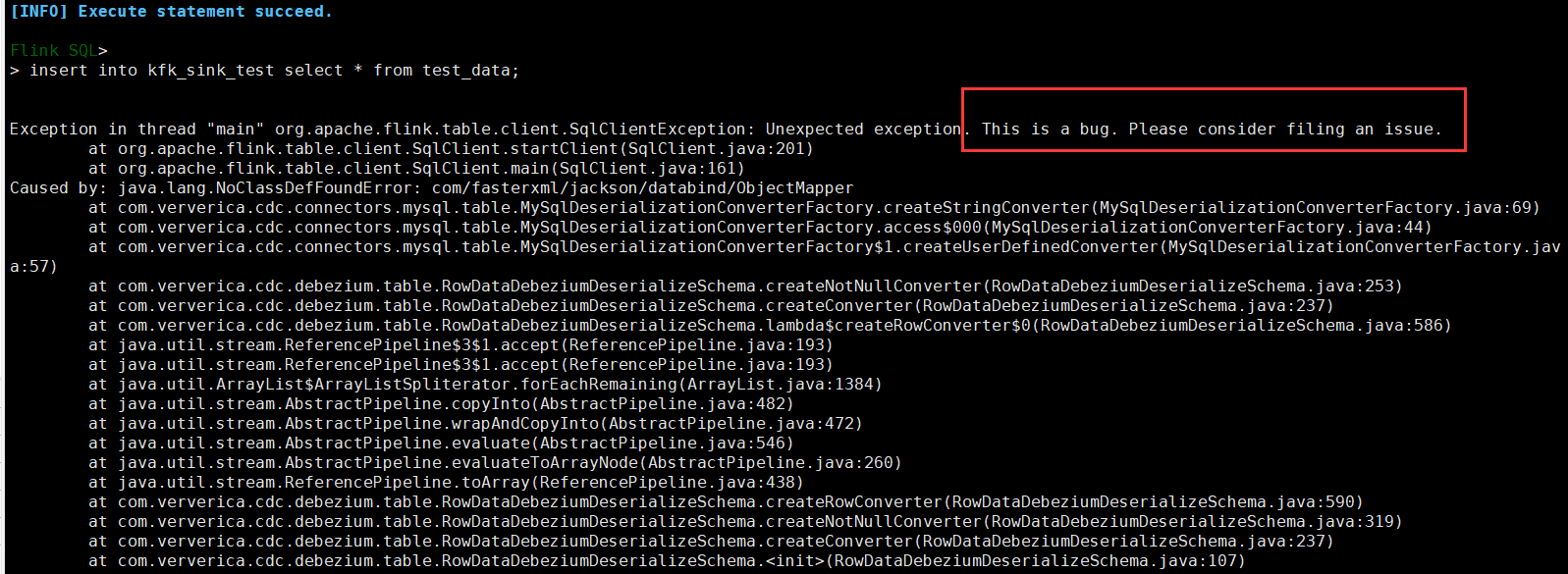

这图片是在sql-client里执行的

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

关于Flink CDC 2.2.1版本的mysql-cdc连接器是否存在Bug以及使用情况,以下是基于知识库资料的详细解答:

根据知识库中的信息,Flink CDC 2.2版本已经同步了社区的功能和修复了相关Bug。具体来说: - 功能支持:Flink CDC 2.2版本支持社区2.2版本提供的全部功能和Bug修复。 - 已知问题修复:在后续版本中(如VVR 8.0.7及以上),针对MySQL CDC连接器进行了多项优化和缺陷修复,包括但不限于: - 全量转增量读取时可能出现的数据丢失问题。 - 解析大量Binlog时可能发生的OOM(内存溢出)问题,现在会抛出异常并触发作业Failover,而不是静默重试。 - 主从切换后无法从Checkpoint恢复的问题。

因此,如果您使用的是Flink CDC 2.2.1版本,建议检查是否已经应用了上述修复补丁。如果未升级到更高版本,可能会遇到以下潜在问题: - 全量转增量数据丢失:在开启OSS读取Binlog时,可能会出现数据丢失的情况。 - Binlog解析OOM:在处理大量Binlog时,可能会因内存不足导致作业失败。

根据知识库中的描述,mysql-cdc连接器已经被广泛应用于多种场景,例如: - 实时数据同步:通过Flink CDC实现从MySQL到Hologres、Kafka等目标系统的实时数据同步。 - 多库多表同步:支持正则表达式匹配多个数据库和表,适用于分库分表场景。 - 无主键表支持:从VVR 6.0.7版本开始,支持无主键表的CDC同步,但需要指定scan.incremental.snapshot.chunk.key-column参数。

在SQL Client中执行mysql-cdc相关的SQL语句时,通常需要配置以下关键参数: - connector:设置为mysql-cdc。 - hostname、port、username、password:用于连接MySQL实例。 - database-name和table-name:支持正则表达式匹配多个库和表。 - server-id:必须唯一,且范围需大于等于作业并发数。

timestamp字段时,需确保server-time-zone配置与MySQL服务器时区一致,否则可能导致时区不一致问题。mysql-cdc相关SQL时,请确保正确配置server-id、database-name、table-name等参数,并注意时区和网络连通性问题。希望以上信息对您有所帮助!如有进一步问题,请随时提问。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。