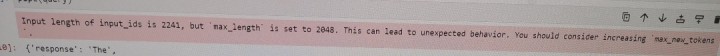

ModelScope chatGLM2-6b-32k最长不该是2048吧?

【 ModelScope chatGLM2-6b-32k最长不该是2048吧?

】

这个模型是基于 GLM-130B 模型开发的,其中 6b 表示隐藏层维度为 6 亿,32k 表示词汇表大小为 32 千。在这个模型中,序列长度最长为 2048,这意味着在处理输入时,序列长度不能超过 2048。如果输入序列长度超过 2048,模型可能无法正确处理。

为了确保输入序列长度不超过 2048,您可以在处理输入时对序列进行截断。例如,如果您使用的是 PyTorch,可以使用 torch.nn.utils.rnn.pack_padded_sequence 和 torch.nn.utils.rnn.pad_packed_sequence 函数来截断和填充输入序列,使其长度不超过 2048。