ModelScope可以通过摩搭提供的Notebook部署LLM模型,然后通过API方式本地访问吗?

是的,您可以使用ModelScope通过摩搭提供的Notebook来部署LLM(Large Language Model)模型,并通过API方式在本地进行访问。

ModelScope提供了用于模型部署和推理的工具和库,您可以使用这些工具在摩搭提供的Notebook环境中部署LLM模型。一旦模型成功部署,您可以将其作为一个API服务在本地进行访问。

一般来说,您需要按照以下步骤进行操作:

在摩搭提供的Notebook环境中安装ModelScope:您可以按照ModelScope的文档或指南,在摩搭提供的Notebook环境中安装ModelScope所需的依赖项和库。

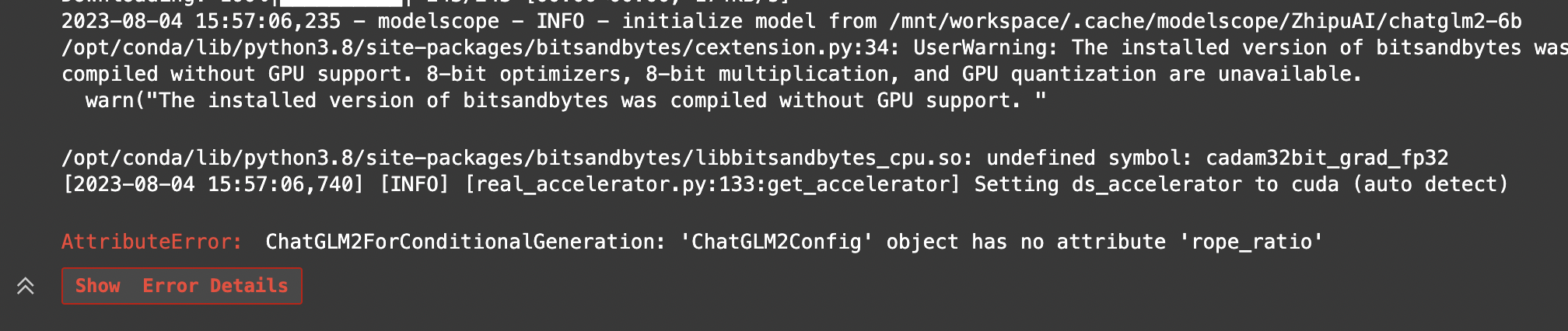

加载和部署LLM模型:使用ModelScope提供的工具和库,您可以加载和部署LLM模型。这通常涉及加载预训练权重、配置模型参数和设置推理环境等步骤。

创建API服务:一旦LLM模型成功部署,您可以使用ModelScope提供的API工具,将模型包装为一个API服务。这意味着您可以通过调用API来与模型进行交互。

本地访问API:在API服务创建后,您可以使用本地的HTTP请求库或工具,如Python中的requests库,通过API方式从本地访问模型。您可以发送请求并接收模型的推理结果。

具体的实施步骤和代码可能因您使用的具体工具和模型而有所不同。建议您参阅ModelScope的文档、示例代码和资源,以获取详细的部署和访问说明。此外,也可以在ModelScope的社区寻求支持和指导。