flink cdc 整库同步MySQL 如何写入hudi,sink hudi的代码该如何写?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

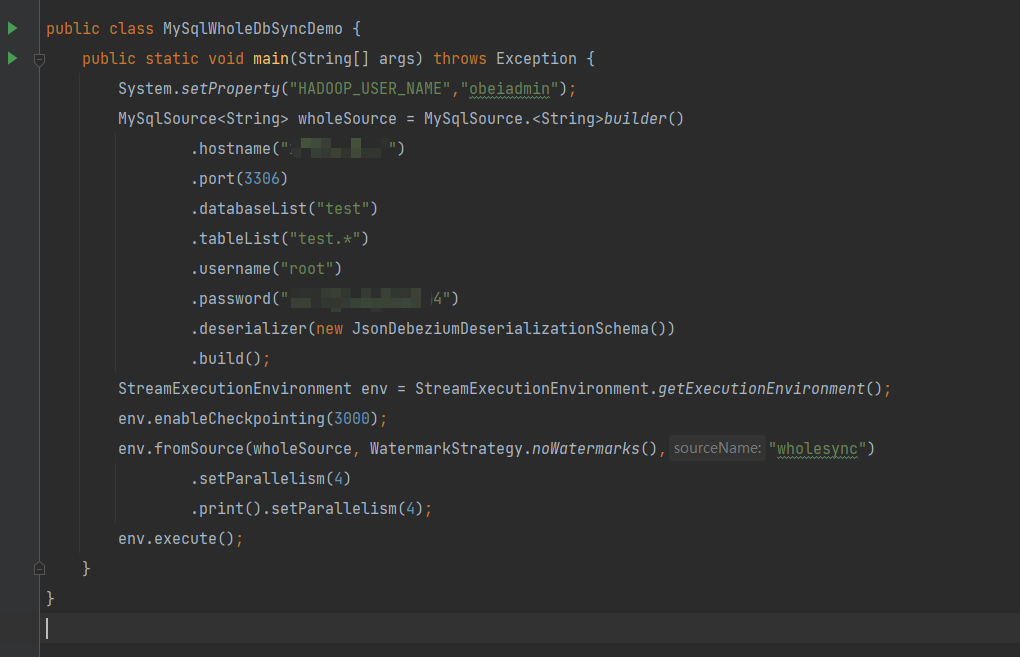

在 Flink CDC 中,可以使用 Hudi 作为 Sink,来将 MySQL 数据库的变更数据写入到 Hudi 中。下面是一个简单的示例,展示如何编写 Flink CDC 应用程序,将 MySQL 数据库的整库数据同步到 Hudi 中。

编写 Flink CDC 应用程序

java

Copy

public class MySQLToHudiSync {

public static void main(String[] args) throws Exception {

// 创建 Flink 环境和表执行环境

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

StreamTableEnvironment tableEnv = StreamTableEnvironment.create(env);

// 创建 MySQL CDC 数据源

TableSchema schema = new TableSchema(new String[]{"id", "name", "age"}, new TypeInformation[]{Types.INT(), Types.STRING(), Types.INT()});

CDCSource<MyRecord> cdcSource = MySQLSource.<MyRecord>builder()

.hostname("localhost")

.port(3306)

.databaseList("my_db")

.tableList("my_table")

.username("root")

.password("123456")

.deserializer(new MyRecordDeserializationSchema(schema))

.build();

DataStreamSource<MyRecord> mysqlStream = env.addSource(cdcSource);

// 将 MySQL 数据源转换为 Flink Table

Table mysqlTable = tableEnv.fromDataStream(mysqlStream, "id, name, age");

// 将 Flink Table 写入 Hudi

Configuration hudiConf = new Configuration();

hudiConf.set("hoodie.datasource.write.recordkey.field", "id");

hudiConf.set("hoodie.datasource.write.partitionpath.field", "age");

hudiConf.set("hoodie.datasource.write.table.name", "my_table");

hudiConf.set("hoodie.datasource.hive_sync.enable", "true");

hudiConf.set("hoodie.datasource.hive_sync.database", "my_db");

hudiConf.set("hoodie.datasource.hive_sync.table", "my_table");

hudiConf.set("hoodie.datasource.hive_sync.partition_fields", "age");

hudiConf.set("hoodie.datasource.write.keygenerator.class", "org.apache.hudi.keygen.SimpleKeyGenerator");

hudiConf.set("hoodie.datasource.write.payload.class", "org.apache.hudi.common.model.DefaultHoodieRecordPayload");

hudiConf.set("hoodie.datasource.write.recordkey.prefix", "my_table");

hudiConf.set("hoodie.datasource.hive_sync.jdbcurl", "jdbc:mysql://localhost:3306/my_db?useSSL=false");

TableSink<Row> hudiSink = new HoodieTableSink(hudiConf);

tableEnv.registerTableSink("hudi_table", new String[]{"id", "name", "age"}, new TypeInformation[]{Types.INT(), Types.STRING(), Types.INT()}, hudiSink);

mysqlTable.insertInto("hudi_table");

// 执行 Flink 应用程序

env.execute("MySQLToHudiSync");

}

}

在这个例子中,首先创建 MySQL CDC 数据源,然后将其转换为 Flink Table。接下来

看看自己mysql服务器所在的时间和时区。

我们在东八区,用utc时间。此回答整理至钉群“Flink CDC 社区”。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。