https://modelscope.cn/models/damo/nlp_csanmt_translation_en2zh/summary 请问ModelScope中,这个翻译模型,我指定了device为GPU了,但是实际运行中还是cpu,是什么原因?

在ModelScope中,指定设备为GPU来运行模型时,实际运行中仍然使用CPU的原因可能有几种:

GPU资源不可用:首先,确保您的系统上具有可用的GPU并已正确配置。如果GPU资源被其他进程或用户占用,或者驱动程序、CUDA等相关软件没有正确安装或配置,那么模型将无法在GPU上执行,而会自动切换到CPU。

模型不支持GPU加速:某些模型可能不支持GPU加速,只能在CPU上运行。这通常与模型本身的设计和实现有关。在这种情况下,无论您如何设置设备为GPU,模型都会在CPU上运行。

设备设置可能未正确应用:确认您在指定设备为GPU时是否遵循了正确的代码和设置流程。有时,可能由于代码中的错误、参数传递问题或设置未正确应用,导致设备设置无效,从而使模型在CPU上运行。

为了解决这个问题,您可以尝试以下步骤:

这种情况可能是由以下原因之一造成的:

没有正确安装 GPU 驱动程序和 CUDA:如果您的计算机没有正确安装 GPU 驱动程序和 CUDA,那么模型将无法在 GPU 上运行,而会在 CPU 上运行。请确保您已正确安装了 GPU 驱动程序和 CUDA,并且版本与 GPU 和 PyTorch 版本兼容。

没有正确配置 PyTorch:如果 PyTorch 没有正确配置,那么它可能无法自动检测和使用 GPU。请确保您已正确配置 PyTorch,以便它能够自动检测和使用 GPU。

模型不支持 GPU:某些模型可能不支持在 GPU 上运行,或者只支持特定的 GPU 设备。请确保您的模型支持在 GPU 上运行,并且已经正确配置了 GPU 设备。

为了解决这个问题,您可以尝试以下步骤:

确保您已正确安装了 GPU 驱动程序和 CUDA,并且版本与您的 GPU 和 PyTorch 版本兼容。

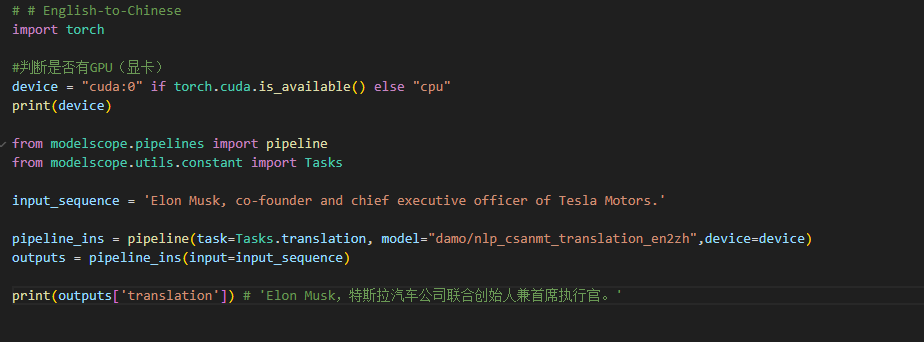

确保你已正确配置 PyTorch,以便它能够自动检测和使用 GPU。可以使用以下代码检查 PyTorch 是否已经正确配置:

import torch

print(torch.cuda.is_available())

如果输出为 True,则表示 PyTorch 已经正确配置,并且您的 GPU 可以用于模型训练和推理。

确保您的模型支持在 GPU 上运行,并且已经正确配置了 GPU 设备。您可以使用以下代码检查您的模型是否支持在 GPU 上运行,并且已经正确配置了 GPU 设备:

routeros

Copy

import torch

from modelscope.pipelines import pipeline

from modelscope.utils.constant import Tasks

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

print("Device:", device)

input_sequence = 'Elon Musk, co-founder and chief executive officer of Tesla Mot'

pipeline_ins = pipeline(task=Tasks.translation, model="damo/nlp_csanmt_translation_en2zh", device=device)

outputs = pipeline_ins(input=input_sequence)

print(outputs['translation'])

我在A10,A100和V100上都没有复现这个问题,CUDA版本是11.3,tf是1.15.可以确认下是不是cuda和tf版本不匹配导致的。此回答整理自钉群“魔搭ModelScope开发者联盟群 ①”

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352