在使用Flink CDC时,如果提示成功但Sink端查不到数据,可能是由以下几个原因导致的。以下是详细的原因分析及解决方案:

1. 数据未正确写入Sink端

- 可能原因:

- 数据在写入Sink端时被过滤或丢弃。

- Sink端的表结构与上游数据不匹配,导致写入失败。

- Sink端的连接器配置错误,例如未正确设置主键、分区表路由等。

- 解决方案:

- 检查Sink端的表结构是否与上游数据一致,确保字段类型和数量匹配。

- 如果Sink端是分区表,确认是否启用了

partitionRouter=true,并检查是否需要设置createparttable=true以支持自动创建分区表。

- 使用

print结果表或日志输出(Log4j)确认数据是否正常到达Sink端。

2. 数据乱序或延迟触发窗口计算

- 可能原因:

- 数据流中存在乱序数据,导致部分数据被丢弃。

- Watermark设置不合理,导致数据未能及时触发窗口计算。

- 解决方案:

- 确认是否存在乱序数据,可以通过

print结果表或日志输出查看数据源中的乱序情况。

- 根据乱序程度合理设置Watermark生成策略,例如:

Watermark = Event time - 5s,以允许一定程度的乱序数据被处理。

- 如果使用窗口计算,建议以整点、整分的时间段开窗,避免因乱序严重而导致数据丢失。

3. Checkpoint未完成或数据未刷新

- 可能原因:

- Flink Hologres Sink连接器的Checkpoint间隔较长,数据尚未刷新到数据库。

- 缓冲区未达到

jdbcWriteBatchSize或jdbcWriteFlushInterval的阈值,数据仍在缓存中。

- 解决方案:

- 检查Checkpoint间隔设置是否合理,适当缩短Checkpoint间隔时间。

- 调整

sink.buffer-flush.max-rows和sink.buffer-flush.interval参数,确保数据能够及时刷新到Sink端。

- 在运维中心查看作业日志,确认是否有异常或延迟刷新的情况。

4. 网络连通性问题

- 可能原因:

- Flink与Sink端之间的网络连接存在问题,导致数据无法正常传输。

- 解决方案:

- 检查Flink与Sink端的网络连通性,确保两者能够正常通信。

- 如果通过公网连接,需配置NAT访问公网;如果是同VPC,需通过内网地址连接并添加白名单。

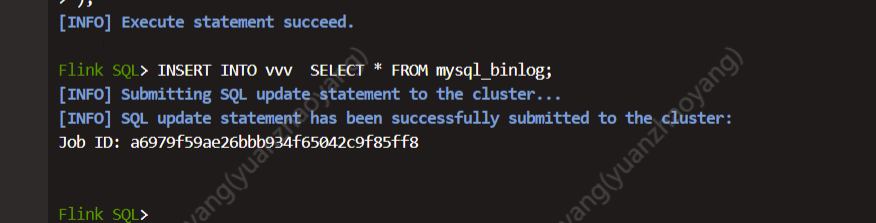

5. MySQL Binlog相关问题

- 可能原因:

- MySQL Binlog文件已过期或被清理,导致增量数据无法读取。

- RDS MySQL只读实例的Binlog文件不包含数据,无法读取增量阶段的数据。

- 解决方案:

- 检查MySQL Binlog文件是否过期,执行命令

SHOW FULL BINARY LOGS;确认当前存在的Binlog文件及其修改时间。

- 如果使用RDS MySQL 5.6只读实例,建议切换为可写实例或升级至更高版本。

- 调整RDS MySQL的Binlog保留策略,确保Binlog文件能够被正常读取。

6. 权限问题

- 可能原因:

- Sink端的操作用户缺少必要的权限,例如INSERT、UPDATE或DELETE权限。

- 解决方案:

- 检查Sink端操作用户的权限,确保其具有对目标表的完整操作权限。

- 如果使用CDC流结合WHERE条件过滤,需确保用户具有DELETE权限,因为

update_before数据会被识别为DELETE操作。

7. 作业逻辑或拓扑图问题

- 可能原因:

- 作业中只有一个节点,Source没有input只有output,Sink只有input没有output,导致拓扑图中无法看到数据流量。

- 解决方案:

- 将Source算子和Sink算子拆分为独立的算子,并在运维中心的运行参数配置中添加

pipeline.operator-chaining: 'false',以便在拓扑图中查看具体的数据流向和流量。

8. 其他常见问题

- 可能原因:

- 数据经过JOIN、WHERE或窗口等节点时被过滤。

- 维表Cache缓存策略有问题,导致数据未正确关联。

- 解决方案:

- 检查维表Cache缓存策略,确保其配置正确。

- 确认数据是否在JOIN或过滤过程中被丢弃,调整SQL逻辑以避免不必要的过滤。

总结

请根据上述分析逐一排查问题,重点关注数据写入、乱序处理、Checkpoint配置、网络连通性和权限设置等方面。如果问题仍未解决,建议在运维中心查看详细的作业日志,定位具体的错误信息并进一步处理。