ModelScope不联网的的状态下,按这种方式加载的模型,但是还是报错。是啥原因?

请问 必须联网,才能加载模型吗?

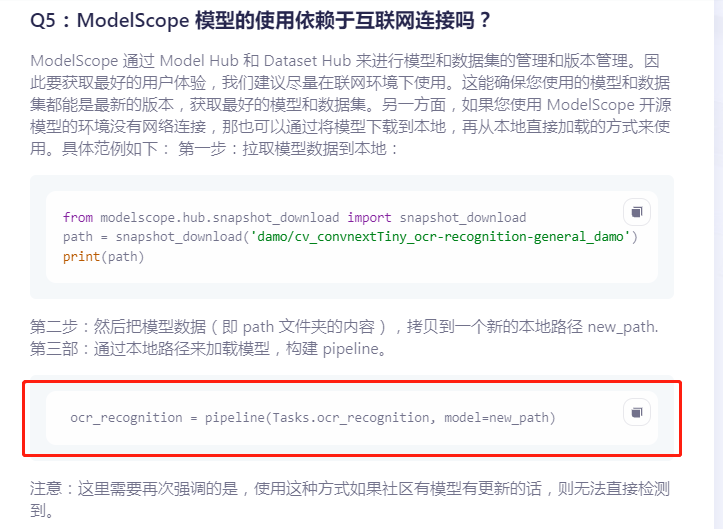

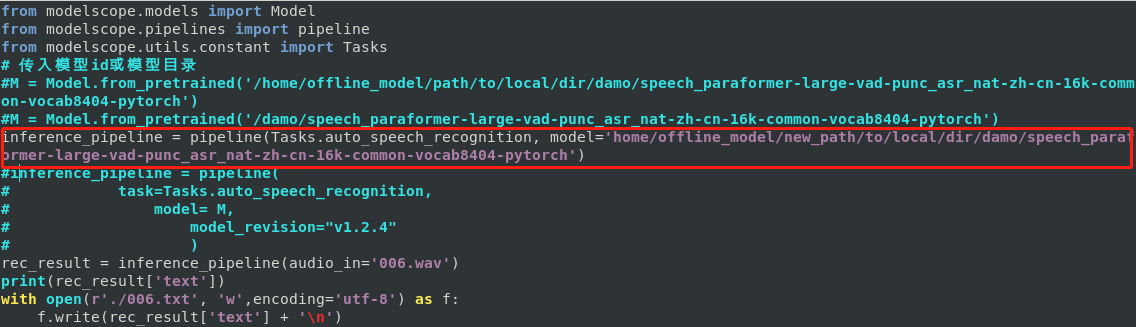

单个独立的模型应该是不需要联网的。如果是复合模型(一个模型pipeline调用了另外一个模型),那有可能本地加载支持的就不是那么完整了。麻烦ls下对应的目录,看下目录的内容,此回答整理自钉群“魔搭ModelScope开发者联盟群 ①”

将本地模型权重文件加载到模型中:

python

Copy

from transformers import AutoTokenizer, AutoModelForQuestionAnswering

tokenizer = AutoTokenizer.from_pretrained("bert-base-chinese")

model = AutoModelForQuestionAnswering.from_pretrained("/path/to/local/model/weights")

请确保将 "/path/to/local/model/weights" 替换为您实际下载的模型权重文件的本地路径。

请注意,如果您使用的是预训练的语言模型,则还需要下载对应的 tokenizer 文件。您可以从 Hugging Face 的模型仓库中下载对应的 tokenizer 文件,然后将其加载到您的代码中。例如,对于中文 BERT 模型,您可以使用以下代码加载 tokenizer:

python

Copy

from transformers import BertTokenizer

tokenizer = BertTokenizer.from_pretrained("/path/to/local/tokenizer")

请确保将 "/path/to/local/tokenizer" 替换为您实际下载的 tokenizer 文件的本地路径。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉群号:44837352