在进行命名实体识别模型训练时,我想修改模型的结构。我观察到当前modelscope模型以bert-crf为主,我想加入编码层,查阅文档后未能正确配置encoder。

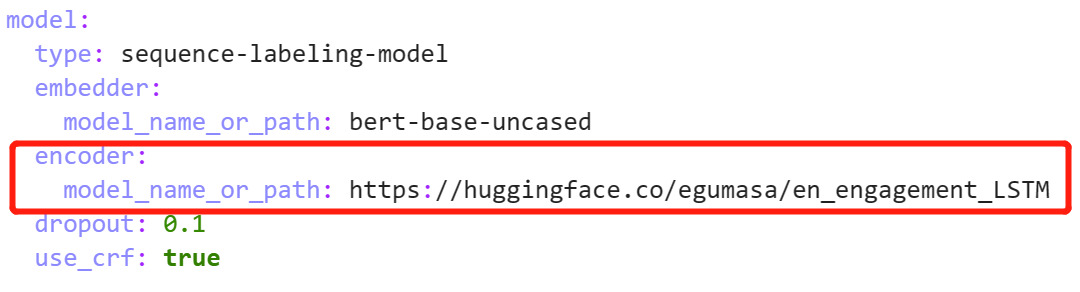

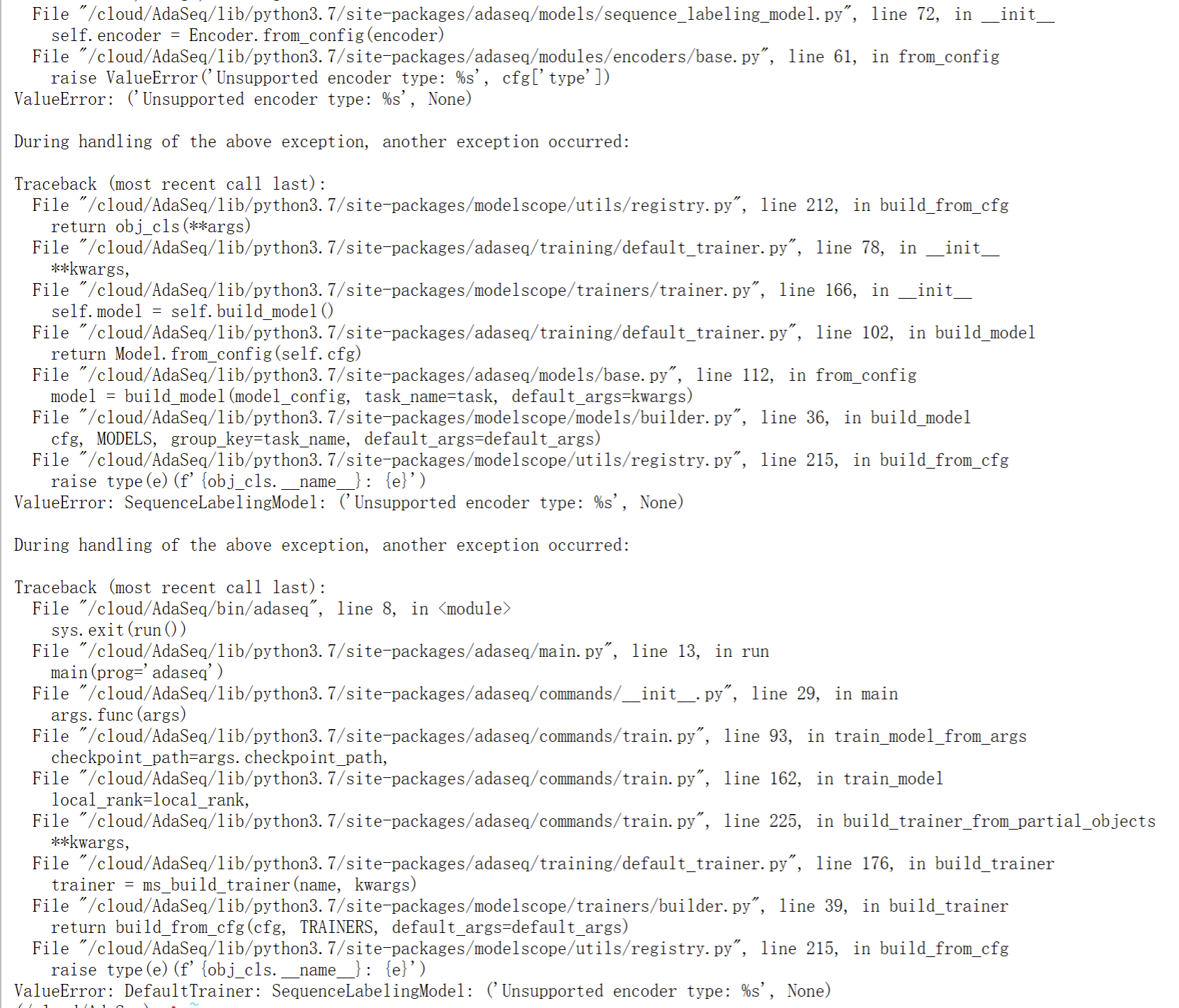

我的问题是: 1. 如何正确配置编码层? 是否像嵌入层一样,设置一个model_name_or_path的路径 2.如何正确引用huggingface的模型? 如上面图3和图4所示,我加入了一个huggingface的模型,但在训练时未能识别出encoder

我的问题是: 1. 如何正确配置编码层? 是否像嵌入层一样,设置一个model_name_or_path的路径 2.如何正确引用huggingface的模型? 如上面图3和图4所示,我加入了一个huggingface的模型,但在训练时未能识别出encoder

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

配置编码层 在使用编码层时,需要确保已经正确安装了 transformers 库,并且已经下载了需要使用的预训练模型。编码层的配置方式与嵌入层稍有不同。您需要在代码中手动创建一个 AutoModel 实例,并将其作为编码层传递给模型。例如,如果您想使用 bert-base-uncased 模型作为编码层,可以按照以下方式进行配置: python Copy from transformers import AutoModel

encoder_layer = AutoModel.from_pretrained('bert-base-uncased') 其中,AutoModel 类是 transformers 库中的一个工厂函数,用于根据模型名称自动加载对应的模型。from_pretrained 方法用于从预训练模型中加载权重。

引用 Hugging Face 的模型 如果您想使用 Hugging Face 的预训练模型,可以使用 transformers 库中的 AutoModel 类或其他相关类。例如,您可以按照以下方式使用 Hugging Face 的 bert-base-uncased 模型: python Copy from transformers import AutoModel

bert_model = AutoModel.from_pretrained('bert-base-uncased') 在训练或推理过程中,您需要将输入数据传递给 bert_model,然后获取模型的输出进行后续处理。需要注意的是,如果您的模型需要进行微调或其他修改,您需要将 bert_model 的参数设置为可训练,并在训练过程中更新其权重。