用flinkcdc-oracle2.2.1全量同步数据到kafka,开始很快,然后掉一大截?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

Oracle数据库性能瓶颈:如果Oracle数据库在处理查询时遇到性能问题,例如大量的并发查询或索引失效,那么Flink CDC的同步速度可能会受到影响。可以尝试优化Oracle数据库的性能,例如增加索引、调整查询语句、减少并发查询等。

网络带宽瓶颈:如果Flink CDC与Oracle数据库之间的网络带宽有限,那么随着数据量的增加,传输速度可能会下降。可以尝试优化网络配置,例如增加带宽、调整网络延迟等。

Flink任务配置问题:Flink任务在处理数据时,如果配置不当,例如并发度过高或任务资源不足,可能会导致任务执行效率下降。可以尝试调整Flink任务的配置,例如适当增加并发度或增加任务资源。

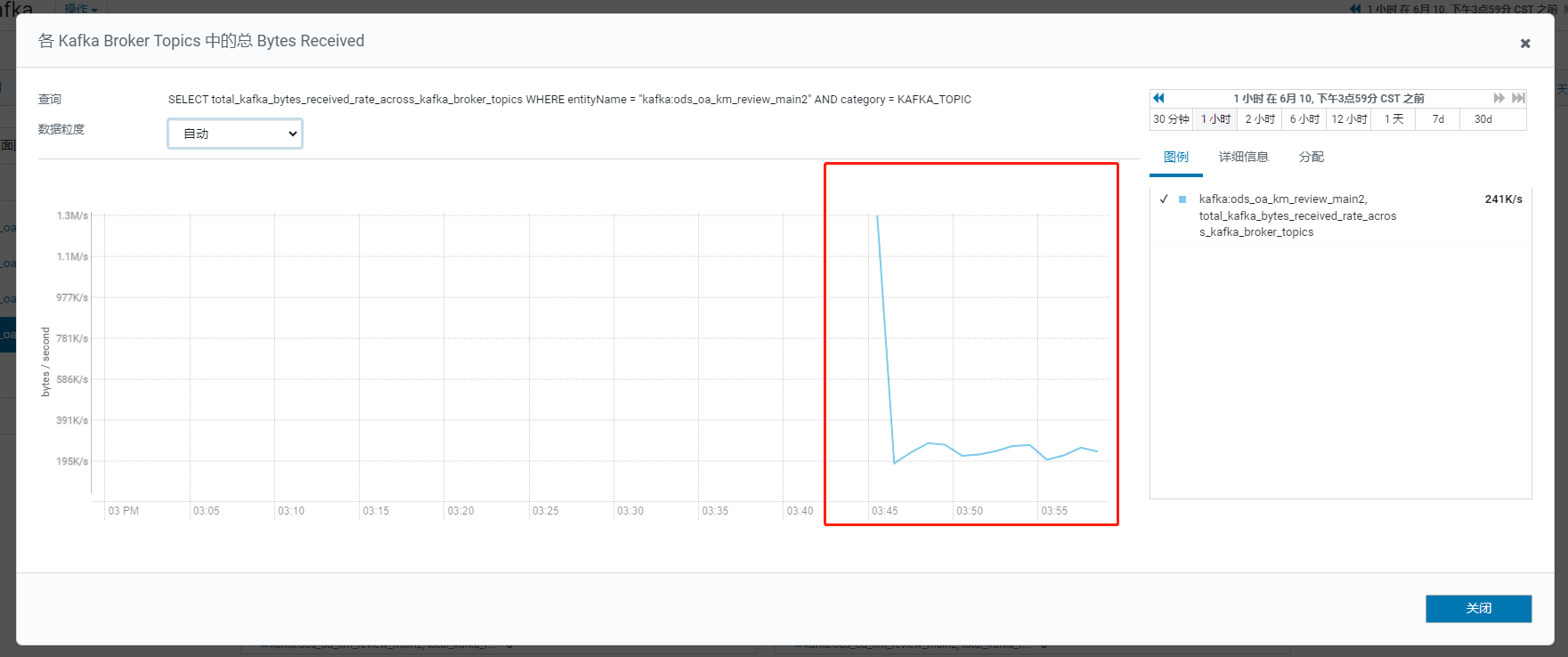

Kafka性能瓶颈:如果Kafka在处理数据时遇到性能问题,例如消息堆积或消费者处理速度慢,那么Flink CDC的同步速度可能会受到影响。可以尝试优化Kafka的配置,例如增加分区数、调整消息大小或增加消费者数量等。

在使用Flink CDC将Oracle数据库全量同步到Kafka时,开始时速度很快,但后来速度骤降可能有以下几个原因:

1、数据量增加:随着同步的数据量增加,可能会导致同步速度变慢。特别是在初始同步时,可能需要处理大量的数据,而后续增量同步速度会相对较快。

2、数据库性能问题:如果Oracle数据库的性能出现问题,如CPU占用率高、磁盘IO繁忙等,都会影响CDC同步的速度。

3、网络问题:如果Kafka集群与Flink CDC应用之间的网络连接出现问题,如带宽限制、延迟增加等,都会导致同步速度下降。

4、Flink CDC配置问题:可能存在Flink CDC的配置不合理或者参数设置不当,导致同步速度下降。可以检查相关配置项,如并行度、内存分配等。

5、数据处理逻辑复杂:如果同步过程中有复杂的数据处理逻辑,如数据转换、过滤、聚合等,都会增加处理时间,导致同步速度下降。

针对这些原因,可以采取以下措施来解决问题:

1、优化数据库性能,确保Oracle数据库的正常运行,例如检查索引、优化查询语句等。

2、检查网络连接,确保Kafka集群与Flink CDC应用之间的网络畅通。

3、检查Flink CDC的配置项,根据实际情况进行调整,以提高同步速度。

4、简化数据处理逻辑,尽量减少数据转换、过滤、聚合等操作,提高同步效率。

分析日志和监控数据,定位具体的瓶颈,并根据问题的具体情况采取相应的优化措施。

楼主你好,在使用阿里云 Flink CDC 同步数据到 Kafka 的过程中,出现掉一大截数据的情况可能是由于以下原因之一:

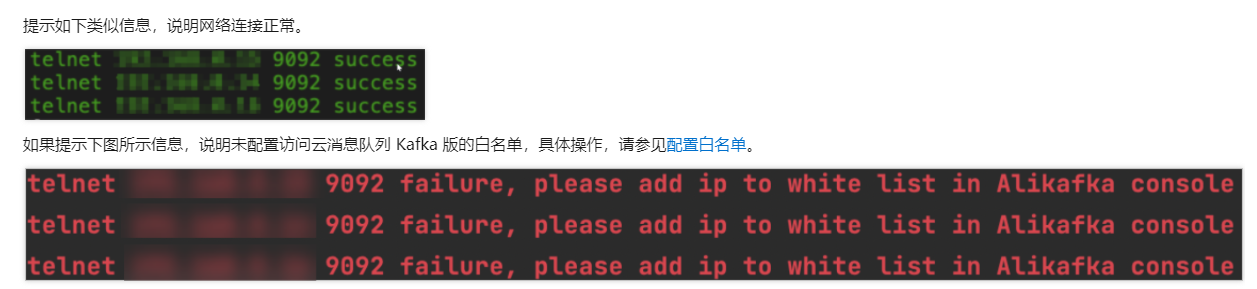

配置问题:请检查你的 Flink CDC 和 Kafka 的配置是否正确。确保连接字符串、认证信息等配置项都正确无误。

数据量过大:如果你要同步的数据量非常大,可能会导致初始阶段速度很快,但随着时间推移逐渐减慢。这是因为初始阶段可能会利用内存进行缓存和处理,当数据量超出内存限制时,性能会下降。你可以尝试增加 Flink TaskManager 的资源配置或者调整 Flink CDC 的并行度来提高性能。

网络问题:网络延迟或不稳定可能会导致数据同步的速度下降。请确保 Flink CDC 和 Kafka 在网络连接方面没有问题。

Kafka 配置问题:检查 Kafka 的配置,包括分区数量、副本数量等是否合理。如果 Kafka 分区数量太少,可能会造成写入速度受限。

数据库资源问题:如果数据库资源(CPU、内存等)不足,可能会导致数据同步的速度变慢。请确保数据库有足够的资源供应。

针对以上可能的原因,可以尝试以下解决方案:

在使用 Flink CDC 将 Oracle 数据库的数据同步到 Kafka 时,如果一开始速度很快,但是后来掉了一大截,有可能是有以下的情况导致:

Oracle 数据库负载过高:如果 Oracle 数据库的负载过高,可能会导致 Flink CDC 无法及时获取到数据,从而导致同步速度变慢。您可以通过监控工具查看 Oracle 数据库的负载情况,以确定是否存在这种情况。检查 Oracle 数据库的负载情况,并优化数据库性能。

Flink 程序配置不当:如果 Flink 程序的配置不当,也可能会导致同步速度变慢。您可以检查 Flink 程序的配置参数,例如并行度、内存大小等,以确保其能够充分利用系统资源。检查 Flink 程序的配置参数,并适当调整参数以提高程序性能。

Kafka 集群负载过高:如果 Kafka 集群的负载过高,也可能会导致同步速度变慢。您可以通过监控工具查看 Kafka 集群的负载情况,以确定是否存在这种情况。检查 Kafka 集群的负载情况,并优化集群性能。

网络带宽不足:如果网络带宽不足,也可能会导致同步速度变慢。您可以通过监控工具查看网络带宽的使用情况,以确定是否存在这种情况。检查网络带宽的使用情况,并升级网络带宽以提高同步速度。

Flink CDC从Oracle同步数据到Kafka,开始速度快然后掉速很可能的原因有:

Oracle事务处理速度不够快,临时表渐渐积聚,阻塞CDC消费。

Oracle内存不足,频繁Full GC,导致CDC获取Binlog数据的速度下降。

Flink并行度设置太高,后期资源争夺严重,例如网络带宽不足。

Kafka端点接受能力不足,积累到一定程度后处理变慢。

Flink状态切换性能不佳,周期性触发Chackpoint下游速度。

Oracle数据表过大,一次性拉全量数据带来性能开销。

Flink作业本身内存泄露、线程安全问题。

网络问题,长时间数据传输延迟造成速度下降。

建议:

调整Oracle或Flink资源

减小每批全量数据量

优化状态设计减少切换开销

监控挖掘瓶颈资源

增大Kafka副本备份吞吐

如果您在使用Flink CDC同步Oracle数据到Kafka时,开始很快,然后掉一大截,那么可能是由于以下原因:

数据源表的数据量过大:如果您的数据源表的数据量过大,那么可能会导致Flink CDC无法正确读取和写入数据。在这种情况下,您可以尝试增加Flink CDC的并行度,以提高数据处理和同步的效率和稳定性。

数据源表的索引发生了变化:如果您的数据源表的索引发生了变化,那么可能会导致Flink CDC无法正确读取和写入数据。在这种情况下,您需要在Flink CDC的配置文件中,指定数据源表的索引,以确保Flink CDC能够正确读取和写入数据。

数据源表的字典发生了变化:如果您的数据源表的字典发生了变化,那么可能会导致Flink CDC无法正确读取和写入数据。在这种情况下,您需要在Flink CDC的配置文件中,指定数据源表的字典,以确保Flink CDC能够正确读取和写入数据。

需要注意的是,如果您在生产环境中使用Flink CDC同步Oracle数据到Kafka,那么您需要考虑Flink CDC的资源使用情况。例如,您需要确保Flink CDC有足够的内存和CPU资源,以保证数据处理和同步的效率和稳定性。同时,您还需要确保Flink CDC的数据备份和恢复机制,以保证数据的安全性和可靠性。

根据您的描述,开始很快,然后掉一大截,可能是由于以下几种原因导致的:

网络问题:在数据传输的过程中,网络可能会出现波动,导致数据传输速度减慢甚至中断。这种情况下,您可以检查网络连接是否正常,或者尝试更换更稳定的网络环境。

Kafka消费速度跟不上生产速度:如果Kafka的消费者速度跟不上生产者的速度,那么就会出现数据积压的问题,导致数据传输速度下降。您可以尝试增加Kafka消费者的数量或者提高消费者的速度,以解决这个问题。

Flink任务状态:Flink任务的状态可能会影响数据同步的速度。例如,如果任务处于错误状态或者正在进行重启,那么数据同步的速度可能会受到影响。您可以检查Flink任务的状态,看看是否有异常情况。

数据量过大:如果数据量非常大,那么数据同步的时间可能会相对较长。在这种情况下,您可以考虑使用增量同步的方式,而不是全量同步,以提高数据同步的速度。

硬件资源不足:如果系统的硬件资源(如CPU、内存、磁盘空间等)不足,那么可能会导致数据同步的速度变慢。您可以检查系统的硬件资源使用情况,看看是否有资源不足的问题。