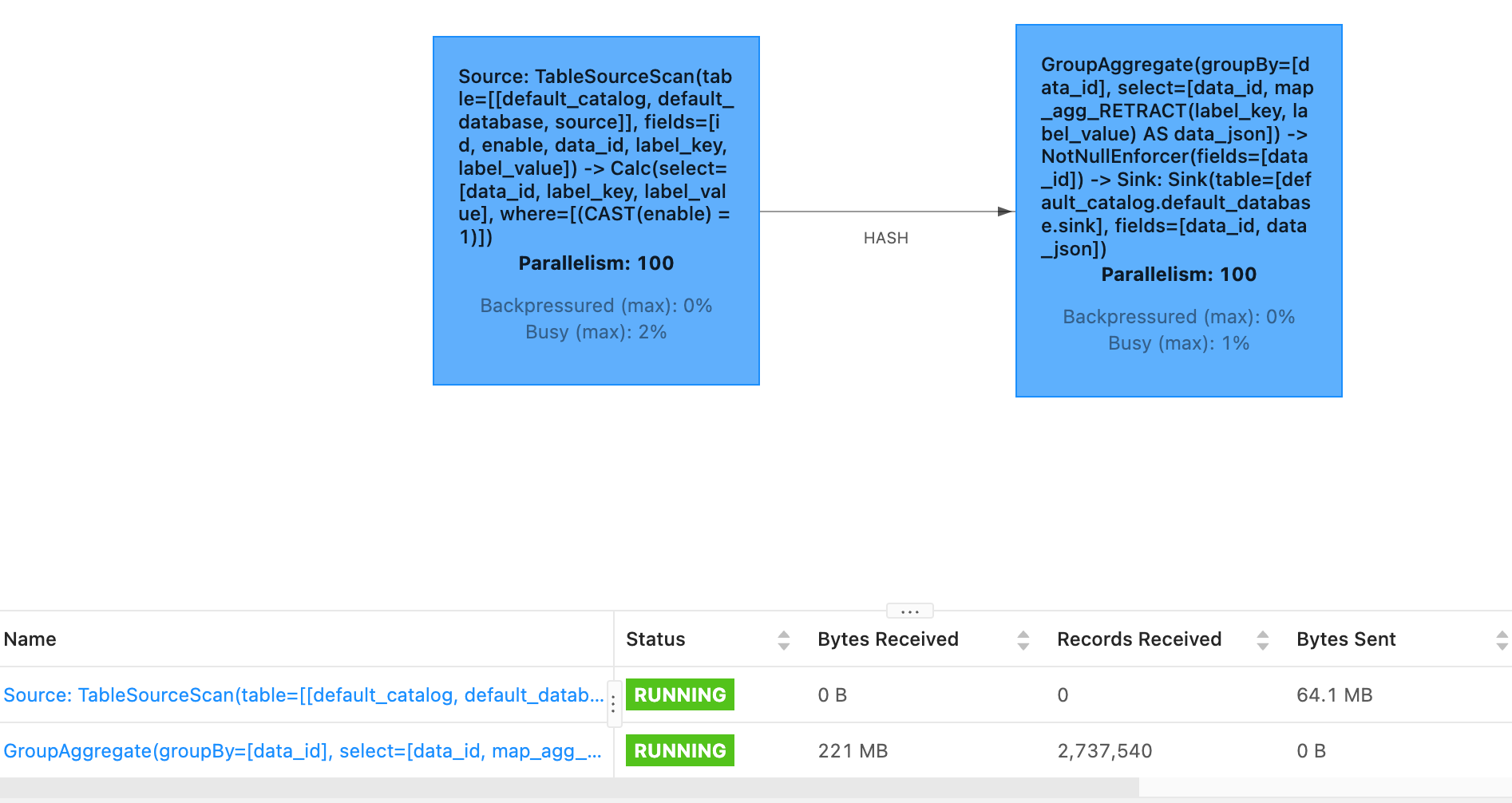

filnk table api没有任何方法让sink和source并行度不同吗? 这个sink一直来不及写

这个sink一直来不及写

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在Flink Table API中,Sink和Source的并行度是可以不同的,但需要根据具体的场景进行合理配置。如果Sink端写入速度跟不上,可能是因为并行度设置不合理、下游系统性能瓶颈或数据分布不均等原因导致的。以下是详细的分析与解决方案:

Flink允许Sink和Source的并行度不同,但需要通过以下方式进行调整: - 全局并行度设置:可以通过table.exec.sink.parallelism参数单独为Sink设置并行度。 - 动态表选项:在SQL语句中使用WITH子句为特定的Sink表指定并行度。例如:

CREATE TEMPORARY TABLE sink_table (

a INT,

b INT,

PRIMARY KEY (a) NOT ENFORCED

) WITH (

'connector' = 'print',

'sink.parallelism' = '4' -- 单独为Sink设置并行度

);

如果Sink端一直来不及写入,可能是以下原因导致的:

table.exec.sink.keyed-shuffle参数对主键字段进行Hash Shuffle操作,确保相同主键的数据被发送到同一个并发实例。sink.buffer-flush.max-size、sink.buffer-flush.max-rows和sink.buffer-flush.interval,以减少写入频率并提升吞吐量。根据上述分析,以下是针对Sink写入慢的具体优化步骤:

CREATE TEMPORARY TABLE sink_table (

a INT,

b INT,

PRIMARY KEY (a) NOT ENFORCED

) WITH (

'connector' = 'print',

'sink.parallelism' = '8' -- 增加Sink并行度

);

table.exec.sink.keyed-shuffle参数启用Hash Shuffle操作,确保相同主键的数据被发送到同一个并发实例。例如:

SET table.exec.sink.keyed-shuffle = 'FORCE';

CREATE TEMPORARY TABLE sink_table (

a INT,

b INT,

PRIMARY KEY (a) NOT ENFORCED

) WITH (

'connector' = 'jdbc',

'sink.buffer-flush.max-size' = '10mb', -- 增大缓冲区大小

'sink.buffer-flush.max-rows' = '1000', -- 增大缓冲区行数

'sink.buffer-flush.interval' = '5000' -- 增大刷新间隔

);

table.optimizer.state-compatibility.ignore-sink=false),修改表名或连接器类型可能导致不兼容变更。通过以上方法,您可以有效解决Sink写入慢的问题,并确保Sink和Source的并行度能够灵活配置以满足业务需求。