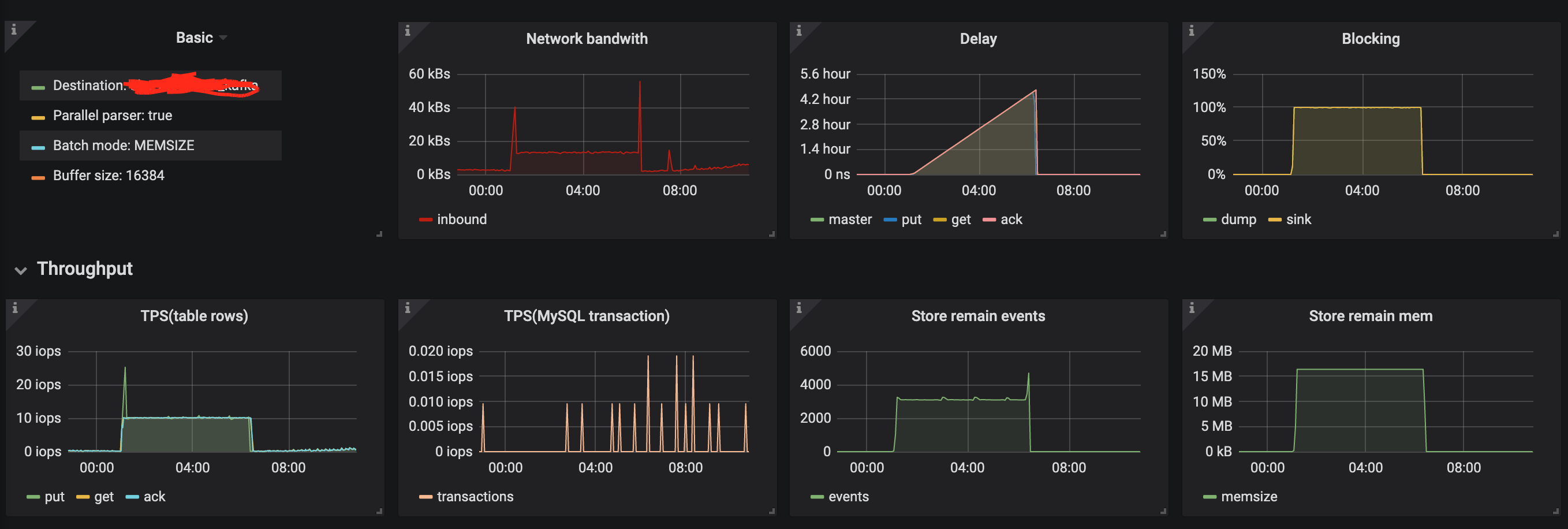

最近使用canal同步一张表的数据到kafka,每天晚上1点多会有一个定时任务批量更新这个表,会出现波峰情况,但是从监控上看,延迟最大竟然有4个多小时,有点理解不了。请大佬帮忙分析下, 监控图如下

kafka的配置如下: canal.mq.retries = 1 canal.mq.batchSize = 49152 canal.mq.maxRequestSize = 1048576 canal.mq.lingerMs = 200 canal.mq.bufferMemory = 33554432 canal.mq.canalBatchSize = 50 canal.mq.canalGetTimeout = 100 canal.mq.flatMessage = true canal.mq.compressionType = none canal.mq.acks = 1 canal.mq.producerGroup = test canal.mq.accessChannel = local

instance配置 canal.mq.topic=t_order canal.mq.partitionsNum=20 canal.mq.partitionHash=d_business.t_order:id

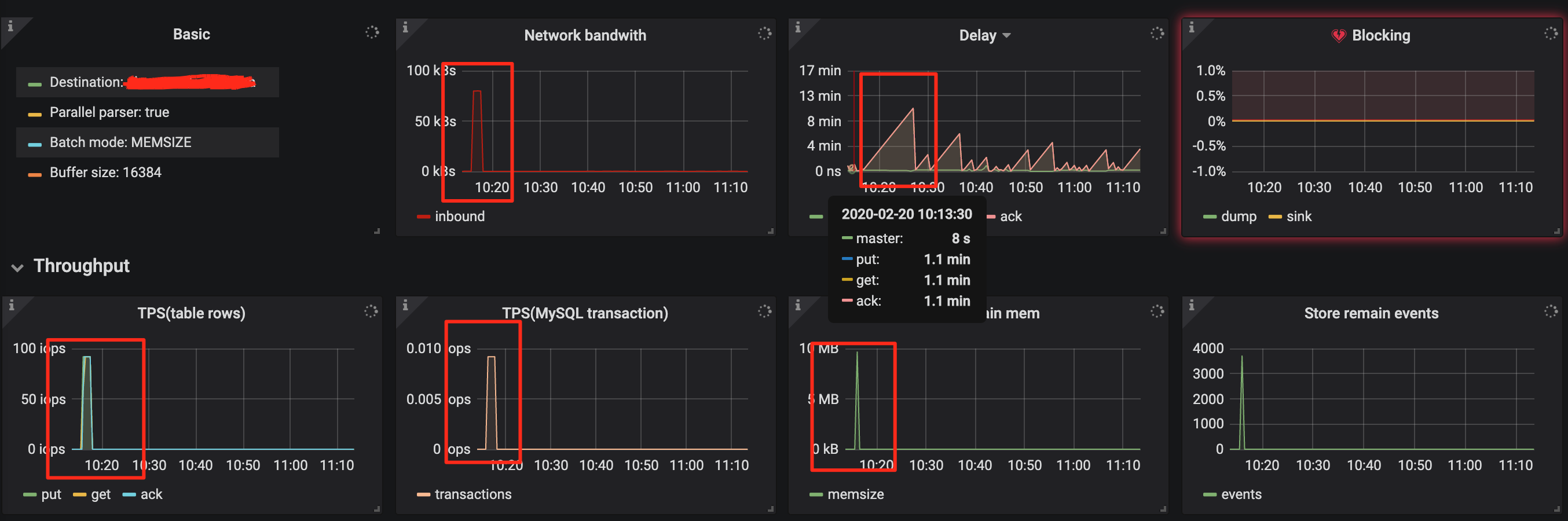

还有我在开发环境进行了测试,同样的kafka配置,表结构。使用存储过程批量插入10000条数据,kafka消费端能很快消费完所有数据,但是监控的delay指标依然很高,blocking指标没有显示存在柱塞情况,不太清楚put get ack delay指标的计算方式,请大佬指点

原提问者GitHub用户luojun0513

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。