Flink CDC这都是默认配置吧,sink表总数一直没变过了,估计卡住了

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

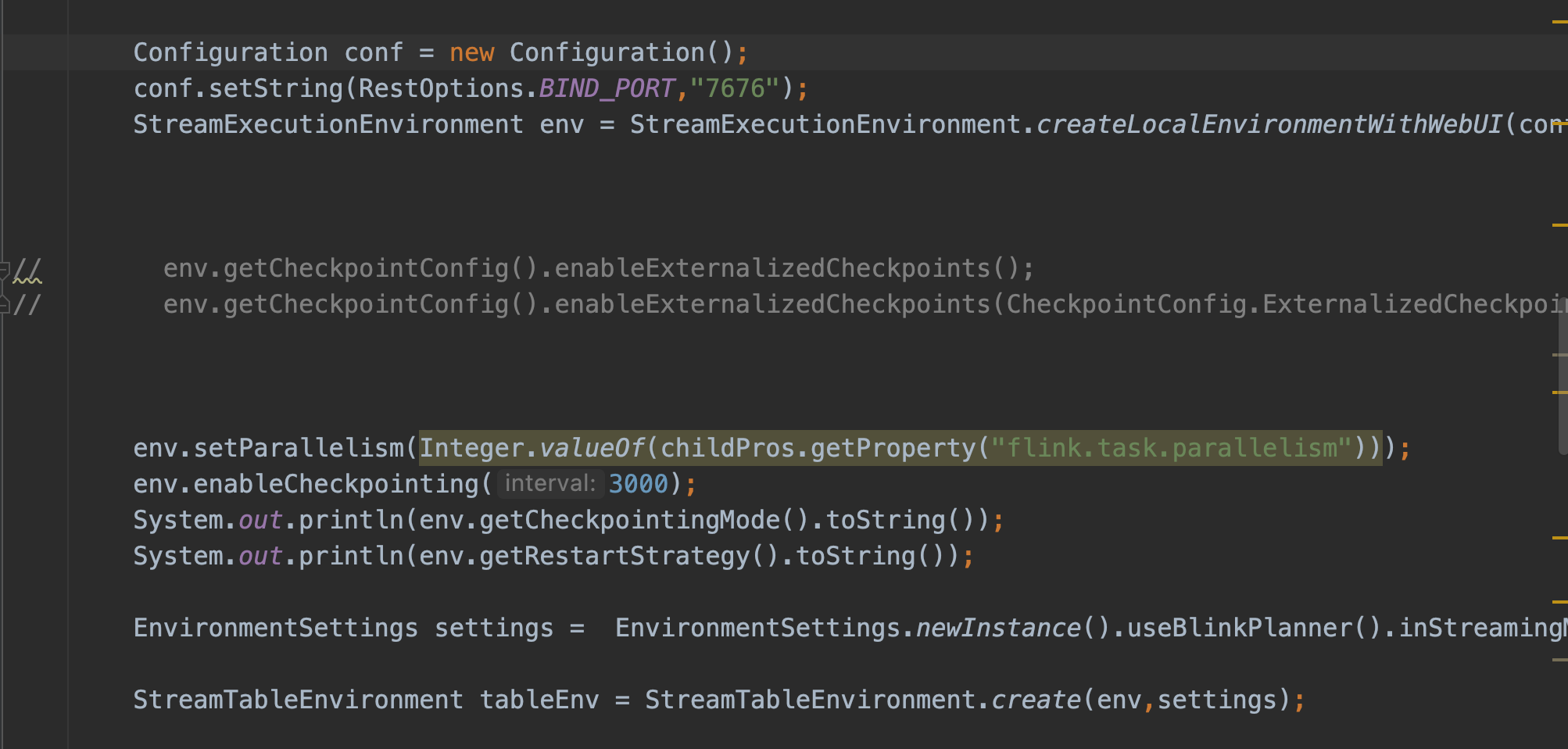

根据您描述的问题“Flink CDC的sink表总数一直没变,估计卡住了”,这可能是由于作业在某些阶段出现了阻塞或性能瓶颈。以下是可能的原因及解决方案,结合知识库中的信息进行分析和建议:

SELECT语句读取数据,并记录Binlog位点。如果全量数据量较大且并发度不足,可能导致读取时间过长,甚至出现内存溢出(OOM)问题。server-id范围来提高MySQL CDC源表的并发度。例如,设置更大的server-id范围以支持更多并发任务。SHOW VARIABLES LIKE '%max_connections%';

如果连接数不足,可以适当增加max_connections值。

sink.buffer-flush.max-rows和sink.buffer-flush.interval。如果缓存过大或刷写间隔过长,可能导致数据积压。建议根据实际场景调整这些参数。

'sink.buffer-flush.max-rows' = '5000',

'sink.buffer-flush.interval' = '5s'

sink.parallelism参数来调整Sink端的并发度。

'sink.parallelism' = '4'

SinkUpsertMaterializer),可能会因为数据无序或分组键合并导致反压。table.exec.sink.upsert-materialize参数设置为none,从而避免生成不必要的状态算子。

SET 'table.exec.sink.upsert-materialize' = 'none';

SinkUpsertMaterializer算子链。如果存在,进一步分析其是否必要。Binlog_Do_DB或Binlog_Ignore_DB,可能导致某些库的增量数据无法同步。建议通过以下命令检查Binlog过滤器配置:

SHOW MASTER STATUS;

如果发现过滤器配置不当,需调整MySQL的Binlog策略。

根据上述分析,您可以按照以下步骤排查和解决问题: 1. 检查MySQL CDC源表的并发度和Checkpoint配置,确保全量阶段高效完成。 2. 确认MySQL的最大连接数是否足够,避免增量阶段因连接数过多导致性能问题。 3. 调整Sink端的缓存和并行度参数,优化写入性能。 4. 检查作业是否存在不必要的状态算子,并根据实际情况禁用。 5. 确认MySQL的Binlog过滤器配置是否正确,避免增量数据丢失。

如果问题仍未解决,建议提供更详细的作业日志和配置信息,以便进一步分析。