Flink2.3.0默认的maven依赖,通过checkpoint启动时新增表会报错。类似下面这样。

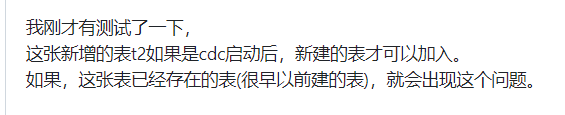

Flink2.3.0默认的maven依赖,通过checkpoint启动时新增表会报错。类似下面这样。 我找了git上relase-2.3的源码编译后替换jar包,不报错了,但是新增的表不会做全量同步,2.2.1版本好像就没这个问题,flink-cdc-connectors这个项目,有遇到过的大佬指点一下吗

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您的描述,您在使用Flink 2.3.0时遇到通过Checkpoint启动作业,在数据流中新增表时会出现错误。尽管您通过编译Flink CDC相关源码并替换JAR包解决了报错问题,但发现新增表没有进行全量同步。您提到Flink 2.2.1版本似乎没有这个问题。

针对您的情况,这里有几个可能的原因和建议:

-

版本兼容性与变更:不同版本的Flink及其连接器可能存在行为差异,特别是涉及到CDC(Change Data Capture)功能时。Flink CDC Connectors项目在不同版本间可能对表结构变更的处理逻辑有所调整或优化。从您提到的现象来看,这可能是由于Flink 2.3.0中的某些更改导致了对新增表全量同步的支持不如2.2.1稳定或直接。

-

配置检查:确保您的Flink作业配置正确地指定了对表结构变更的处理方式。例如,对于Debezium这样的CDC引擎,可以通过设置

debezium.inconsistent.schema.handling.mode来调整对未知表或不一致Schema的处理策略。请检查是否遗漏了特定于新版本的配置项,或者是否有新的配置选项需要调整以启用对新增表的全量同步。 -

资源与日志分析:查看作业运行时的日志,寻找与表结构检测、同步相关的警告或错误信息。这有助于定位为何新增表未触发全量同步的具体原因。如有可能,监控作业的CPU、内存使用情况,确认资源充足且无异常压力影响同步过程。

-

代码与依赖审查:如果您有自定义的代码或依赖管理,请确保所有依赖与Flink 2.3.0及相应连接器版本兼容,避免因依赖冲突导致的功能缺失或异常。

-

社区与开源反馈:考虑到您已经尝试了查看源码并自行编译,如果问题依然存在,建议在Flink或Flink CDC Connectors的官方GitHub仓库提交Issue,详细描述您的环境、配置以及遇到的问题。开源社区的维护者和用户可能会提供针对性的帮助或确认是否存在已知问题。

-

回退或升级策略:如果2.2.1版本能满足您的需求且没有其他兼容性问题,考虑暂时回退到该版本以保证业务连续性。同时,关注后续Flink 2.3.x的小版本更新,可能包含对您所遇问题的修复。

综上所述,解决此问题可能需要综合考虑配置调整、依赖管理、日志分析以及与社区互动等多方面因素。希望上述建议能帮助您找到合适的解决方案。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。