Input length of input_ids is 2616, but max_length is set to 2048. This can lead to unexpected behavior. You should consider increasing max_new_tokens. 需要修改

使用 pipline 如何将max_length=XXX 透传进去啊 self.pipe = pipeline(task=Tasks.chat, model='ZhipuAI/ChatGLM-6B', model_revision='v1.0.7')

result = self.pipe(inputs, max_length=8096) 这样无法生效

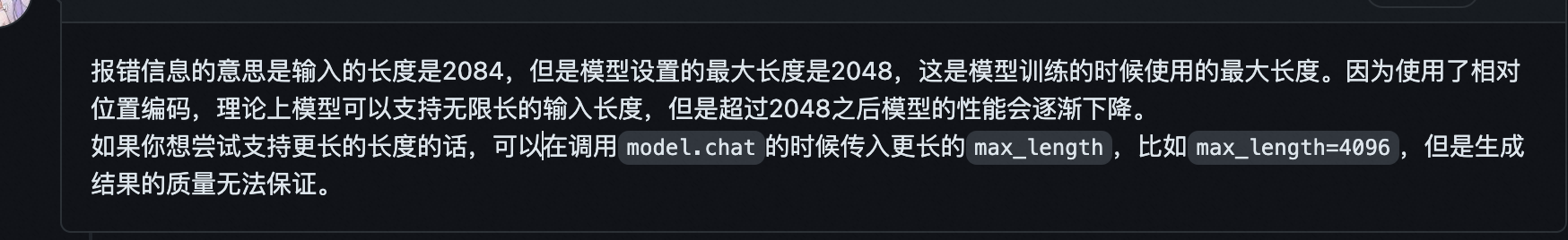

根据您的描述,您在使用pipeline处理输入时遇到了Input length of input_ids is 2616, but max_length is set to 2048的错误信息,这表明您的输入序列长度超出了模型配置的最大长度限制。您尝试通过设置max_length=8096来解决该问题,但在实际操作中并未生效。为了解决这一问题,请参考以下步骤进行调整:

确认参数传递方式: 确保所使用的pipeline接口支持直接通过函数调用时传入max_length参数。不同库或模型实现可能对参数名称或传递方式有特定要求。

查阅模型Pipeline文档: 查看pipeline函数的具体文档说明,特别是关于Tasks.chat任务和ZhipuAI/ChatGLM-6B模型的部分,确认是否支持直接修改max_length,以及正确的参数名是否为max_new_tokens或其他等效项。

尝试配置更新: 如果直接在pipe(inputs, max_length=8096)调用中设置max_length不生效,考虑是否需要在初始化pipeline时就设定好相关参数。部分模型pipeline可能需要在创建实例时就指定最大长度限制。

自定义Pipeline组件: 若上述方法均无法直接调整长度限制,可能需要更深入地自定义pipeline中的组件,确保在预处理阶段能够正确应用您的max_length设置。

检查模型限制: 注意,即使能成功修改pipeline中的max_length,最终的有效性还受限于模型自身的硬编码限制。如某些模型由于内存或计算资源的考量,其内部可能不允许超过特定长度的输入。

鉴于知识库参考资料与当前问题直接关联度不高,以上建议基于通用的调试逻辑和模型使用经验给出。如果问题依然存在,建议直接查看所使用库的官方文档或联系模型提供方的技术支持获取更具体的指导。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。