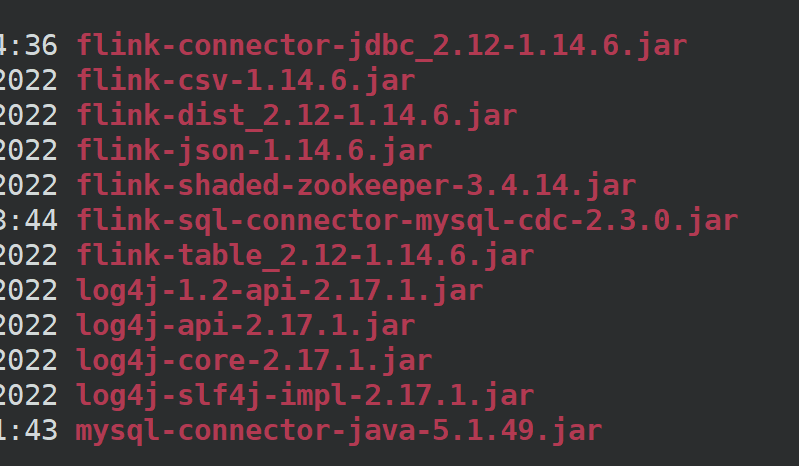

ClassNotFoundException: org.apache.flink.connector.jdbc.internal.GenericJdbcSinkFunction 请教一下这个是少了个什么包,新手在做flinkSQLCDC的多表join试验, 我是直接启动cluster-start,启动sql-client,然后放了几个SQL,这个是flink lib文件夹下的依赖包

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

您好!遇到ClassNotFoundException: org.apache.flink.connector.jdbc.internal.GenericJdbcSinkFunction这个错误,表明Flink在运行时未能找到所需的 JDBC Sink 功能类。这通常是因为缺少了相应的JDBC连接器依赖包。对于新手在进行Flink SQL CDC多表join实验时,确保所有必要的库文件都已正确添加到Flink的lib目录是非常关键的。

确认依赖包: 确保您的Flink环境中包含了正确的Flink JDBC connector JAR包。对于Flink SQL作业,您应该使用flink-connector-jdbc_2.11(或对应Scala版本)的稳定版依赖。例如,如果您使用的是Maven管理项目,可以在pom.xml中添加如下依赖:

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-jdbc_2.11</artifactId>

<version>YOUR_FLINK_VERSION</version>

</dependency>

其中YOUR_FLINK_VERSION应替换为您的Flink版本号,确保与您的Flink集群版本匹配。

手动添加依赖: 如果您直接操作Flink lib目录来添加依赖,需要下载相应版本的flink-connector-jdbc_2.11-X.Y.Z.jar文件,并将其放入Flink安装目录下的lib文件夹内。您可以从Maven中央仓库搜索并下载对应版本的jar包。

检查Classpath: 确认启动Flink SQL客户端或集群时,这些依赖已经被正确地加入到了类路径(classpath)中。如果通过命令行启动,可以检查启动脚本是否包含了这些JAR包的路径。

DataStream API vs SQL Connector: 注意区分Flink SQL作业和DataStream API作业使用的连接器包名差异。对于SQL作业,使用flink-sql-connector-jdbc这样的FAT JAR更合适,因为它已经包含了所有必需的依赖。

版本兼容性: 确保所使用的Flink JDBC connector版本与您的Flink核心版本兼容。不兼容的版本可能导致类找不到或其他运行时异常。

exclude标签或者shade重新打包以解决冲突。请按照上述步骤操作,如果问题依旧存在,建议检查日志中的详细错误信息,以及确认是否有其他相关依赖也需一并添加。希望这能帮助您解决问题!

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。