请问ModelScope每次推理请求可以加上topk 或者topp 吗?

请问ModelScope每次推理请求可以加上topk 或者topp 吗?

-

是的,ModelScope每次推理请求可以加上topk或topp。您可以在调用ModelScope.predict()方法时,通过设置参数来指定topk或topp。例如:

import torch from transformers import AutoTokenizer, AutoModelForSequenceClassification tokenizer = AutoTokenizer.from_pretrained("bert-base-uncased") model = AutoModelForSequenceClassification.from_pretrained("bert-base-uncased") text = "This is an example sentence." inputs = tokenizer(text, return_tensors="pt") outputs = model(**inputs) # 获取预测结果中概率最高的前5个单词 top5_predictions = outputs.logits[0].topk(5)[1] print(top5_predictions)2023-06-27 14:29:48赞同 展开评论 -

对于ModelScope而言,具体是否支持"topk"和"topp"参数取决于所使用的模型。如果你的模型支持这些参数,那么你可以在推理请求中添加相应的参数来进行多样性控制。这通常需要在模型服务的代码中进行相应的修改和调整,以处理这些参数并将它们传递给模型进行推理。

需要注意的是,不是所有的模型都支持"topk"和"topp"参数,因此在使用ModelScope或其他框架时,你需要查看模型的文档或代码以确定是否支持这些参数,并了解如何正确地配置和使用它们。

2023-06-25 14:18:00赞同 展开评论 -

公众号:网络技术联盟站,InfoQ签约作者,阿里云社区签约作者,华为云 云享专家,BOSS直聘 创作王者,腾讯课堂创作领航员,博客+论坛:https://www.wljslmz.cn,工程师导航:https://www.wljslmz.com

是的,ModelScope 支持在推理请求中指定 top-k 或 top-p。您可以在推理请求的 JSON 数据中,通过添加

topk或topp字段来指定。例如,以下是一个包含

topk字段的推理请求示例:{ "model": "your_model_name", "inputs": [ { "name": "input_1", "data": [1, 2, 3, 4] } ], "outputs": [ { "name": "output_1", "parameters": { "topk": 5 } } ] }在这个示例中,我们通过

parameters字段指定了topk参数的值为 5。类似地,您也可以使用topp字段来指定 top-p 参数的值。2023-06-20 09:41:26赞同 展开评论 -

从事java行业9年至今,热爱技术,热爱以博文记录日常工作,csdn博主,座右铭是:让技术不再枯燥,让每一位技术人爱上技术

您好,NLP中的文本生成任务又可以分为许多具体任务,如文本摘要,机器翻译、故事续写等,GPT3ForTextGeneration类可以将故事续写等任务模型加载起来用于训练和推理,可以配置模型generate参数,包括: top_k(int,可选,如果配置没有设置任何值,则默认为model.config.top_k或10)-为top-k筛选保留的最高概率词汇表令牌的数量。 top_p(float,可选,如果配置未设置任何值,则默认为model.config.top_p或1.0)-如果设置为float<1,则仅保留概率加起来等于top_p或者更高的最可能令牌的最小集合以供生成。

2023-06-19 16:15:55赞同 展开评论 -

是的,您可以使用参数控制在模型推理时生成的文本数量。目前,ModelScope 支持以下几种参数控制:

-

num_samples:生成的文本数量。默认为1。 -

max_length:生成文本的最大长度。默认为32。 -

top_k:从词汇表(vocab)中选择概率排名在前 k 个单词作为生成文本的候选单词。默认为0,即不使用 top-k 采样。 -

top_p:选择概率总和累计超过 p 的单词作为生成文本的候选单词。默认为1.0,即不使用 top-p 采样。

您可以在向 ModelScope 发送推理请求时,将这些参数一并提交。例如,使用HTTP POST请求时,您可以为请求体添加一个 JSON 对象,包含上述参数:

{ "text": "你好", "num_samples": 3, "max_length": 64, "top_k": 50, "top_p": 0.9 }这个请求将生成 3 个最多包含 64 个字符的建议回复文本,同时使用 top-k 采样和 top-p 采样进行文本生成过程。

请注意,不是所有的模型都支持 top-k 和 top-p 采样。在使用这些参数时,请先检查您使用的模型是否支持它们。此外,不同的参数值可能会对文本生成效果产生不同的影响,请根据实际生成效果进行调整。

2023-06-15 11:52:42赞同 展开评论 -

-

-

ModelScope支持在每次的推理请求中设置topk和topp参数。

在使用ModelScope进行推理时,可以在请求中包含当前文本的前缀(prefix),并指定生成文本的长度(length)、生成文本数量(num_samples)、生成文本的采样方式(sample_method)以及对每个预测结果进行筛选的topk或topp等参数。

2023-06-14 11:18:17赞同 展开评论 -

云端行者觅知音, 技术前沿我独行。 前言探索无边界, 阿里风光引我情。

可以的,您可以在使用ModelScope进行推理请求时,通过指定top_k或top_p参数来控制生成的文本的多样性。

`top_k参数指定生成文本时,只考虑概率值最高的前k个单词,而忽略其他单词。这样可以确保生成的文本更加准确,但可能会导致生成的文本过于单调。

top_p参数(也称为nucleus sampling)则是基于概率分布的一个截断方法,它会动态地选择概率值累加超过给定阈值的最小集合,然后在这个集合中进行随机采样。这样可以确保生成的文本更加多样化,但可能会导致生成的文本不够准确。

您可以根据具体的应用场景和需求来选择合适的参数。

2023-06-13 18:47:00赞同 展开评论 -

不断追求着最新的技术和趋势,在云技术的世界里,我不断寻找着新的机会和挑战,不断挑战自己的认知和能力。

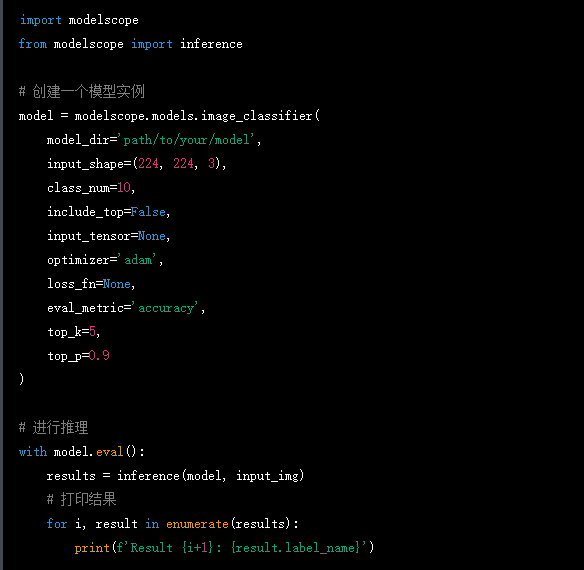

ModelScope 是一个基于 TensorFlow 的深度学习框架,用于对图像、文本等数据进行特征提取和分类等任务。ModelScope 支持在每次推理请求中添加 topK 或 topP,以实现更高效的推理。

具体来说,如果您在使用 ModelScope 进行图像分类任务时,可以将 topK 或 topP 作为参数传递给 ModelScope 的 inference() 函数,以指定需要返回的前 K 或前 P 个结果。

网上找了一个例子,仅供参考

2023-06-13 18:46:58赞同 展开评论

2023-06-13 18:46:58赞同 展开评论 -

是的,ModelScope 支持在每次推理请求中使用 top-k 和 top-p 参数来控制生成的输出结果。这些参数可以用于对生成文本的质量和多样性进行调整,从而得到更加丰富和多样的输出结果。 下面是一些关于 top-k 和 top-p 参数的介绍: top-k 参数:该参数表示只在最可能的 k 个单词中进行采样。例如,如果设置 top-k 为 10,则仅从概率最高的前 10 个单词中进行采样。这有助于提高输出文本的准确性和一致性。 top-p 参数:该参数又称作“nucleus sampling”,表示只在累积概率高于给定阈值(0~1之间)的单词集合中进行采样。例如,如果设置 top-p 为 0.9,则只从累积概率高于 0.9 的单词集合中进行采样。这有助于提高输出文本的多样性和创造性。 在 ModelScope 中,您可以通过在推理请求中传递 top-k 和 top-p 参数来控制模型生成的输出文本。具体来说,您可以将这些参数作为额外的参数传递给您的推理函数,并在函数中使用这些参数来调整生成的文本。例如,在 Python 中,您可以使用以下代码从推理请求中获取 top-k 和 top-p 参数:

def generate_text(prompt, max_length=50, top_k=10, top_p=0.9): # 从推理请求中获取 top-k 和 top-p 参数 if 'top_k' in request: top_k = request['top_k'] if 'top_p' in request: top_p = request['top_p'] # 生成文本 output = my_model.generate_text(prompt, max_length, top_k, top_p) # 返回结果 return { 'output': output }在这里,我们首先将 top-k 和 top-p 参数初始化为默认值,然后从推理请求中获取这些参数并覆盖默认值。最后,我们使用更新后的参数来调用 my_model.generate_text() 函数生成文本,并将结果返回给客户端。

通过使用 top-k 和 top-p 参数,您可以对模型生成的文本进行更加灵活和精细的控制,从而得到更加满意的输出结果。

2023-06-13 10:06:14赞同 展开评论 -

是的,ModelScope 支持在每次推理请求中加上

top-k或者top-p的参数来控制返回的预测结果数量。 对于top-k,它表示返回预测结果中概率值最大的前 k 个。如果你想要返回前 5 个预测结果,可以在请求中添加top_k=5参数。 对于top-p,它表示返回预测结果中概率值累加大于等于某个阈值的最少数量。如果你想要返回概率值累加大于等于 0.8 的最少数量的预测结果,可以在请求中添加top_p=0.8参数。 你可以在使用 ModelScope 的 API 时添加这些参数来控制返回的预测结果数量。例如,如果你使用 Python 的 requests 库来发送请求,可以像下面这样添加参数:import requests url = "http://your_modelscope_host:port/predict" # 构造请求数据 data = { "image": "your_image_data" } # 添加 top-k 参数 params = { "top_k": 5 } # 发送请求 response = requests.post(url, json=data, params=params) # 解析结果 result = response.json()如果你使用其他的编程语言或者工具,可以查看 ModelScope API 文档来了解如何添加这些参数。

2023-06-12 20:47:24赞同 展开评论 -

天下风云出我辈,一入江湖岁月催,皇图霸业谈笑中,不胜人生一场醉。

是的,可以在推理请求中加入topk或者topp参数。这两个参数都可以用于指定需要输出的最大数量,但是topk表示输出的是最大的k个元素,而topp则表示输出的是所有元素中最大的数量。 在调用ModelScope推理接口时,可以通过在请求URL中加入"topk"或"topp"参数来指定需要输出的最大数量。例如,在调用下载模型的API时,可以在请求URL中加入以下参数:

https://modelscope.org/model/path/to/model?topk=10 表示需要下载模型并输出前10个元素。 对于topp,则需要在请求URL中加入以下参数:

https://modelscope.org/model/path/to/model?topp=100 表示需要下载模型并输出前100个元素。 如果你需要进一步调整输出的元素数量,可以在请求中添加参数。例如,在推理API中调用下面的接口可以指定需要输出前5个元素:

https://modelscope.org/model/path/to/model?topk=5&input=input_image 请注意,在请求中添加参数时,参数名称必须与请求URL中的参数名称相同,否则可能会导致请求失败或者请求无效。

2023-06-12 16:04:39赞同 展开评论 -

是否可以为每个推理请求添加topk或topp参数,我先解释一下这两个参数。

在自然语言处理中,当我们使用模型生成文本时,top-k和top-p采样是两种常见的技术。

-

top-k采样:在这种方法中,模型在生成下一个词时只会考虑最有可能的k个选项。例如,如果k=10,那么模型将只从概率最高的10个词中选择下一个词。

-

top-p采样(也被称为nucleus采样):在这种方法中,模型在生成下一个词时会选择一个概率分布,使得这个分布中的词的累积概率至少为p。例如,如果p=0.9,那么模型将会从概率最高的一组词中选择下一个词,直到这组词的概率之和达到0.9。

结论是支持的

2023-06-11 22:57:18赞同 展开评论 -

-

面对过去,不要迷离;面对未来,不必彷徨;活在今天,你只要把自己完全展示给别人看。

是的,ModelScope 支持在每次推理请求中添加 top-k 或者 top-p 参数,以控制模型生成的输出结果。这些参数可以通过设置相应的请求头或者请求参数来实现。

以下是一些常用的控制参数及其作用:

-

top-k:指定从生成概率值最高的 k 个候选项中进行选择。该参数的取值应为一个正整数,通常在 1-1000 之间。例如,设置 top-k=5,则代表选择生成概率值最高的前 5 个候选项进行输出。

-

top-p(别名为 nucleus):指定在生成概率分布中,累计概率达到 p 后停止继续生成。该参数的取值应为一个小数,通常在 0.1-1.0 之间。例如,设置 top-p=0.9,则代表在生成过程中,当累计概率达到 90% 后停止继续生成。

可以根据具体的场景和需求,灵活使用这些控制参数来调整模型的输出结果。需要注意的是,在使用这些参数时,应考虑到模型的生成能力、数据集的质量和特征等因素,并进行适当的测试和验证,以确保输出结果的质量和准确性。

在 ModelScope 中,可以通过编写自定义的 Flask API 来实现对接口的参数控制。建议参考 ModelScope 的文档和示例代码,了解如何编写高效、可靠的 Flask API,并结合具体的模型和场景进行设置和优化。

2023-06-11 19:38:29赞同 展开评论 -

-

值得去的地方都没有捷径

是的,ModelScope支持在模型推理请求中设置top-k或top-p参数。

top-k参数:该参数使生成器仅从最可能的K个预测中选择,而不是在整个预测分布中选择。通过设置适当的K个值,可以控制生成器生成推理结果的多样性,并控制其向用户呈现的准确度。通常情况下,较大的K值会导致更准确的结果,但也会减少结果的多样性。例如,设置top-k值为5,意味着模型仅考虑最有可能的5个结果。

top-p参数:该参数使生成器只考虑预测分布中总概率质量占比前P%的可能性,而不是考虑所有可能性。通过这种方式,生成器可以接受更广泛的可能性分布,而不会被限制在top-k个可能结果上。较小的p值会导致更准确的结果,但也会减少结果的多样性。例如,设置top-p值为0.9,意味着模型将考虑覆盖整个分布的前90%的可能性。

在ModelScope中,设置这些参数的方法取决于模型的实现和API。通常,这些参数可以作为HTTP请求的一部分提交,并在推理端点中进行处理。如果您不确定如何设置top-k或top-p参数,请查看模型的文档或咨询模型开发人员。

2023-06-11 15:27:12赞同 展开评论 -

发表文章、提出问题、分享经验、结交志同道合的朋友

同学你好,ModelScope每次推理请求可以通过加上--max_tokens或--top参数来指定最大token数或最大待推理数。

如果指定了--max_tokens参数,那么在每次推理请求中,系统将仅返回待推理数不超过指定值的结果,如果超出了最大token数,则会被忽略。同样,如果指定了--top参数,那么在每次推理请求中,系统将仅返回最近指定数量的结果,这些结果会按照顺序依次返回,而超出指定数量的结果将被忽略。

2023-06-11 10:27:59赞同 展开评论 -

是的,ModelScope每次推理请求可以加上topk或者topp参数。您可以在推理请求中设置这些参数来控制返回结果的个数或百分比,以便更好地满足您的需求。例如,设置topk=3将返回前三个最可能的结果,而设置topp=10%将返回前10%的结果。请注意,设置这些参数可能会影响推理结果的完整性和准确性,因此您应该根据具体情况进行适当调整。

2023-06-11 09:21:34赞同 展开评论 -

北京阿里云ACE会长

是的,可以在 ModelScope 中进行 top-k 或 top-p 抽样。在使用 ModelScope 进行推理时,可以通过传递额外的参数来指定 top-k 或 top-p 抽样的相关参数。

在 ModelScope 中进行 top-k 抽样时,可以使用 --top_k 参数来指定 k 值,例如:

modelscope predict --input-file input.txt --output-file output.txt --top_k 5 这个命令将对输入文件 input.txt 中的每个文本行进行推理,并将每个文本行的 top-5 预测结果写入输出文件 output.txt 中。

在 ModelScope 中进行 top-p 抽样时,可以使用 --top_p 参数来指定 p 值,例如:

modelscope predict --input-file input.txt --output-file output.txt --top_p 0.9 这个命令将对输入文件 input.txt 中的每个文本行进行推理,并将每个文本行的 top-p 预测结果写入输出文件 output.txt 中,其中 p=0.9。

需要注意的是,不是所有的推理任务都支持 top-k 或 top-p 抽样,这取决于具体的模型和任务。如果模型支持这些抽样方法,通常会在模型文档中进行说明。

2023-06-10 15:48:12赞同 展开评论 -

您好, ModelScope 是一个模型评估和预测平台,它提供了对于模型的通用评估和预测功能,但是您提到的 topk 和 topp 两个概念是特定于文本生成任务的概念,并不属于通用的模型评估和预测方法。 topk 通常用于表示在生成下一个单词时,从模型的输出概率分布中选取概率最高的前 k 个单词,然后再从这 k 个单词中进行下一个单词的选择。topp 则代表一个动态的取最优概率 k 值的方法,用于解决 topk 无法适应不同情境下的单词选择问题。这些方法在文本生成任务中可以用于控制生成的语言的多样性和准确性。 所以,如果您希望在 ModelScope 中进行文本生成任务,并且希望控制语言生成的多样性和准确性,可以尝试使用带 topk 和 topp 参数的预测模式。不过,具体是否支持 topk 和 topp 方法,还需要看您具体使用的模型和依赖库是否支持这些参数。如果支持,您可以根据预测模式的 API 接口,在每次的推理请求中传递相应的参数。

2023-06-10 14:25:50赞同 展开评论 -

是的,ModelScope支持在推理请求中加入topk或topp参数来控制生成的结果数量。具体来说,topk参数可以指定生成前k个可能性最高的结果,而topp参数可以指定生成可能性总和累积至不低于该阈值时停止生成。这两个参数可以一起使用,也可以单独使用。

2023-06-09 23:41:22赞同 展开评论