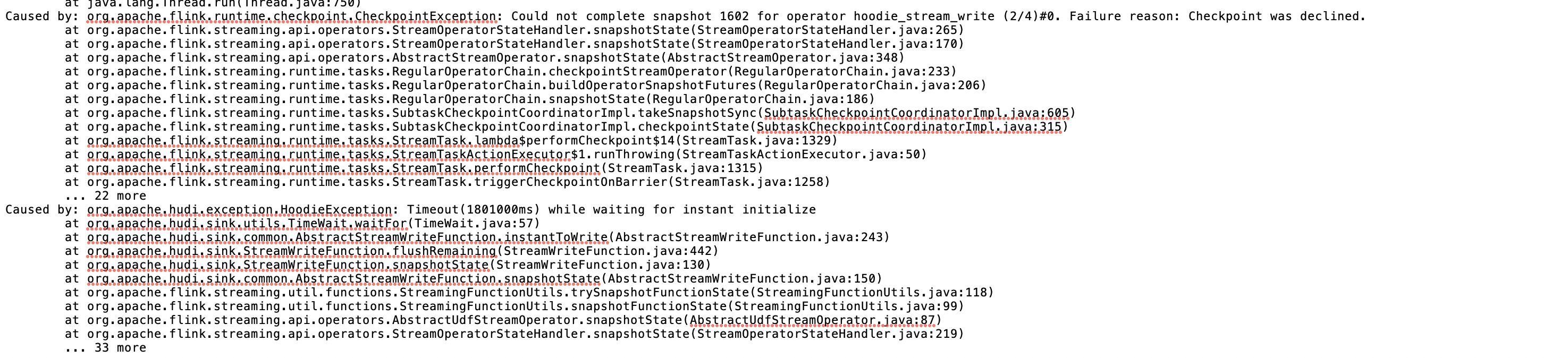

请问大家,从断点开始同步时报这个错误,超时时间已经是30分钟了,checkpoint还是检查失败了,可能是什么原因呢?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

资源不足:

TaskManager 的资源不足,例如内存或 CPU,可能导致状态的快照过程变慢,从而引起超时。

状态大小:

如果状态数据量巨大,快照的生成和传输也会非常耗时,可能造成超时。

Backend 存储问题:

如果使用的状态 Backend(如 RocksDB、文件系统)响应慢或者网络问题,也会导致 Checkpoint 超时。

网络问题:

网络延迟或连接问题可能导致状态数据传输慢,从而影响 Checkpoint 完成时间。

垃圾回收(GC):

JVM 上过度的垃圾回收活动可能会暂停处理,从而影响 Checkpoint 的执行。

并发 Checkpoint 限制:

如果有多个 Checkpoint 同时在进行且未完成,可能会因为受到并发限制而导致超时。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。