pgsql cdc如何限制一下解析速度?有时候库突然更新大量数据,导致复制槽变的很大,然后cdc任务就会失败(内存溢出),并且无限重启(无法确认lsn,导致复制槽不会减少)。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

Checkpoint 配置:

调整 Flink 任务的 checkpoint 间隔和大小,以便更频繁地确认进度并释放复制槽日志。但这可能会牺牲一些性能,因为更频繁的 checkpoint 可能导致更大的开销。

调整并行度:

降低 Flink 任务的并行度,减少同时处理记录的数量。这会减少内存消耗,但同样也会降低整体的处理速度。

使用批量处理:

如果业务场景允许,可以尝试批量处理数据,而不是用流处理方式实时处理每条记录。这可以通过设置更大的时间或处理窗口来实现。

内存管理:

调整 Flink 任务的内存配置,比如增加 TaskManager 的堆大小或修改内存消耗策略。

流控制和背压:

利用 Flink 的内置背压监控和管理功能来防止某个操作因为无法处理过量的数据而失败。

Rate limiter:

实现一个速率限制器,比如使用 Guava 的 RateLimiter,在 CDC Source函数中限制数据的读取速度。这虽然目前官方没有提供直接支持,但可以通过自定义实现来控制。

调整数据库配置:

调整复制槽的 wal_keep_segments 参数,确保有足够的WAL日志文件来支持长时间的数据变化。

在数据库端优化事务和批次提交的策略,避免一次性提交过量的更新。

重启策略:

设置 Flink 的重启策略,允许任务在遇到失败时延迟重启,给复制槽和内存问题提供缓冲时间。

资源分区:

如果可能,将数据分区到多个 CDC Source,使每个 Source 仅消费一部分表或数据范围,从而降低各自的负载。

监控和警报:

监控 Flink 执行环境和 PostgreSQL 数据库的性能指标,并设置警报在复制槽过大或内存消耗过高时通知您。

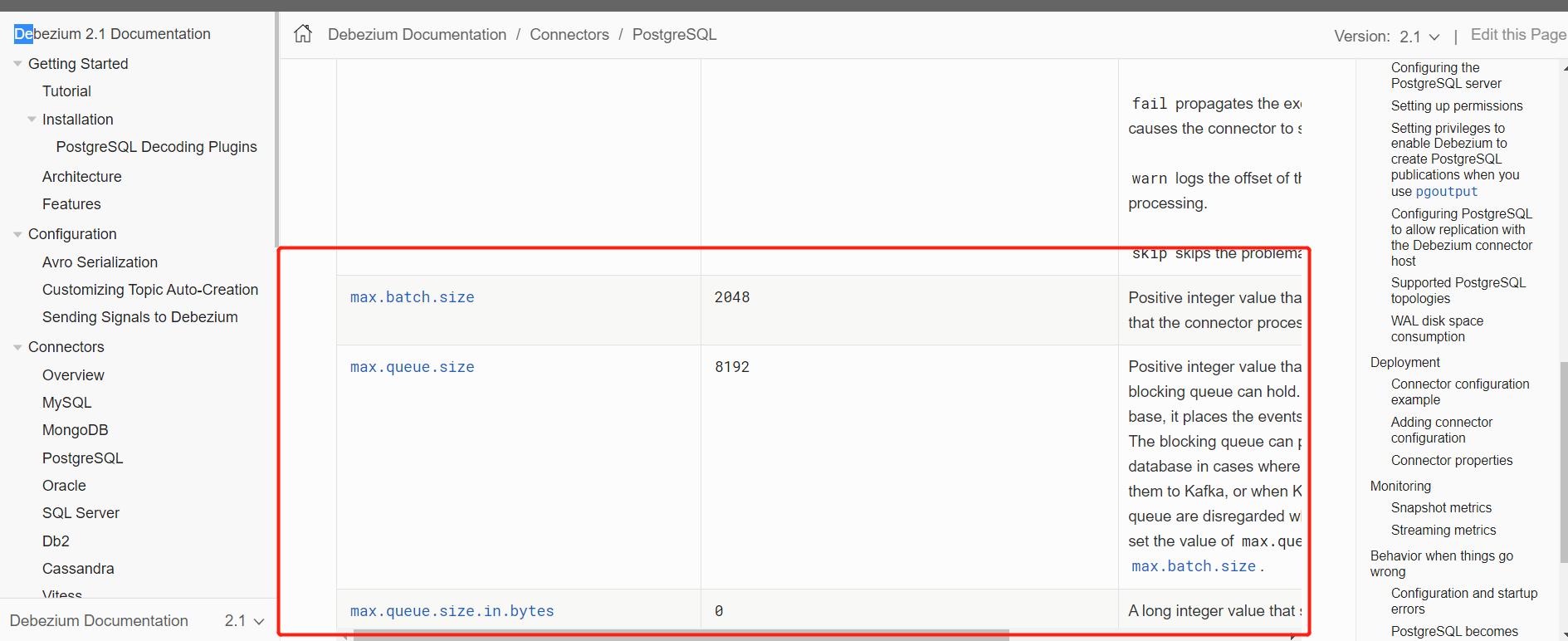

您可以参考一下这个链接,应该有您想要的回答:https://ververica.github.io/flink-cdc-connectors/master/content/connectors/postgres-cdc.html——该回答整理自钉群“Flink CDC 社区”

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。