这个问题怎么解决呀?

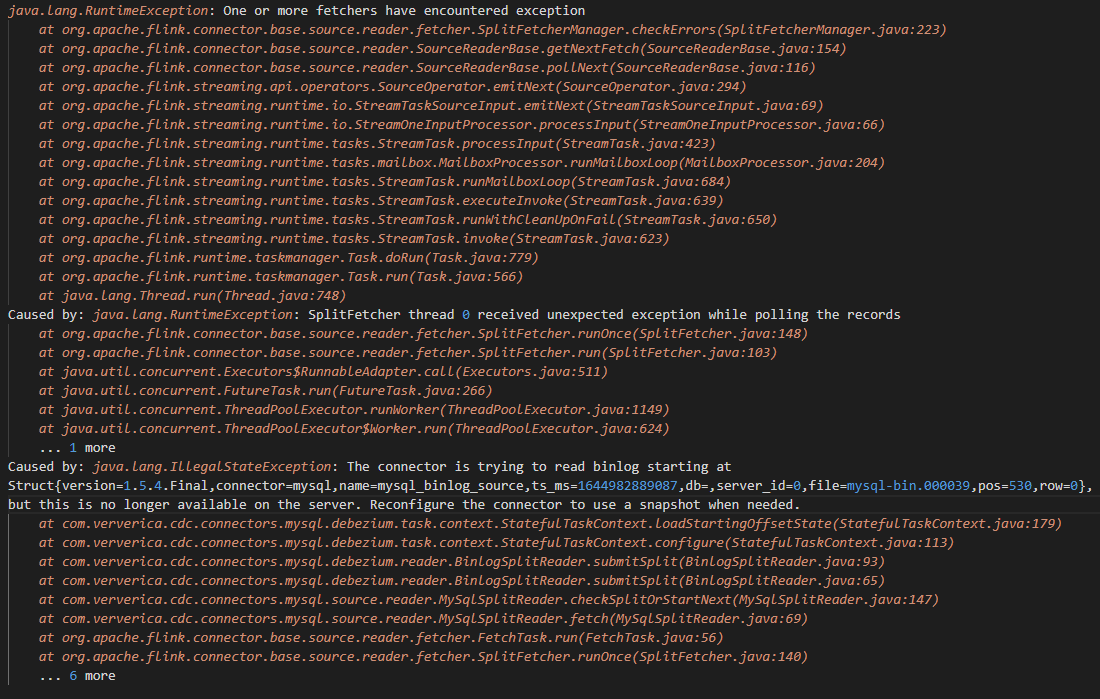

这个问题怎么解决呀,cdc2.1.1,就是简单的全字段同步一张表,正常跑了一个多月突然挂了。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

公众号:网络技术联盟站,InfoQ签约作者,阿里云社区签约作者,华为云 云享专家,BOSS直聘 创作王者,腾讯课堂创作领航员,博客+论坛:https://www.wljslmz.cn,工程师导航:https://www.wljslmz.com

阿里云实时计算 Flink 的 CDC(Change Data Capture)组件可以用于实时同步 MySQL 数据库的变更数据到实时计算任务中,如果您的实时计算任务突然挂了,可能是以下原因导致:

-

MySQL 数据库连接异常:如果 MySQL 数据库连接异常或者网络不稳定,可能会导致 CDC 组件无法从 MySQL 数据库中获取变更数据,从而导致实时计算任务挂掉。

-

实时计算任务配置错误:如果您的实时计算任务配置不正确,例如数据源配置、数据表配置、字段映射配置等错误,可能会导致实时计算任务无法正常运行。

-

实时计算任务代码异常:如果您的实时计算任务代码存在逻辑错误、空指针异常、内存泄漏等问题,可能会导致实时计算任务挂掉。

针对以上可能的原因,您可以尝试以下解决方案:

-

检查 MySQL 数据库连接是否正常,可以通过 ping 命令或者 telnet 命令来测试 MySQL 数据库的网络连接是否正常。

-

检查实时计算任务的配置是否正确,可以通过阿里云控制台或者 API 接口来进行配置查看和修改。

-

检查实时计算任务代码是否存在异常,可以通过日志输出、调试工具等方式来进行排查和解决。

如果以上方法都无法解决问题,建议您联系阿里云技术支持人员进行进一步的排查和解决。

2023-05-06 12:05:14赞同 展开评论 -

-

该错误信息表明 Flink 的 Binlog Connector 正在尝试从某个上下文结构(struct)处开始读取 Binlog,但是在服务器上该上下文结构不再存在,因此无法读取。这通常是由于 Binlog 中断或 Binlog 记录被自动清除所引起的。

针对这个问题,Flink Binlog Connector 提供了两种解决方案:

1、在 Flink Binlog Connector 配置文件中开启快照(snapshot)模式:

# 开启快照模式 snapshot.mode=initial快照模式会在读取 Binlog 之前先执行一次全量快照,以保证读取完整的数据。如果您的 Binlog 中数据量较少,全量快照的处理时间可能非常短,因此快照模式是一个比较推荐的解决方案。

2、重新开启 Binlog 记录,然后在 Flink Binlog Connector 中重新配置 Binlog 开始读取的位置。

在 MySQL 中可以通过以下命令重新开启 Binlog 记录:

SET GLOBAL binlog_format = ROW; SET GLOBAL binlog_row_image = full; FLUSH LOGS;然后在 Flink Binlog Connector 的配置中使用 startupOptions 选项重新指定 Binlog 开始读取的位置,以保证能够从正确的位置开始读取 Binlog。

startupOptions.snapshot > snapshot.serializedValues: ... startupOptions.snapshot > snapshot.directory: ... startupOptions.snapshot > snapshot.format: ... startupOptions.snapshot > snapshot.timestamp: ... startupOptions.snapshot > schema: ... startupMode: ...在以上配置中,设置启动选项 startOptions 的 schema、startupMode 等参数以确定重启后开始读取的位置。

需要注意的是,如果您的数据量较大,全量快照可能会花费较长的时间,而 Binlog Connector 无法处理快照和增量的混合情况,因此您可能需要考虑使用第二种解决方案。同时,为了提高稳定性,建议您在生产环境中使用 GTID 同步,以便在发生中断或主备切换时能够正确恢复 Binlog 处理进度。

2023-05-03 10:08:59赞同 展开评论 -

天下风云出我辈,一入江湖岁月催,皇图霸业谈笑中,不胜人生一场醉。

抛出了 java.Lang.RuntimeException 异常,原因是一个或多个 fetchers(获取器)遇到了异常。 源头是 org.apache.fLink.connector.base.source.reader.fetcher.SplitFetcherManager 类的 checkErrors() 方法,该方法检查所有 SplitFetcher 的状态。此外,还可以看到建议重新配置 connector 以使用 snapshot,因为 splits (划分)不再在服务器上可用。 最后的原因是 java.Lang.ILlegalStateException,它表示 Connector 尝试从 binlog 开始读取,但数据已不再可用。基于以上分析和建议,我建议您尝试以下操作来解决问题:

确认您的 connector 配置是否正确。检查 connector 中使用的 binlog 是否正确,并尝试更新或更改它以反映最新的服务器状态。 确保您的 connector 正确使用 snapshot 功能。如果 splitter 不再在服务器上可用,则需要使用 snapshot 来重新启动应用程序。因此,请确保您的 connector 正确地配置了快照功能。 您还可以考虑运行 Flink 应用程序时提高日志级别,以获得更详细的错误信息。例如,可以将 log4j.rootLogger 设置为 DEBUG、INFO 或 ERROR 等级,以便捕获更多错误信息。2023-04-27 12:43:50赞同 展开评论 -

值得去的地方都没有捷径

这个问题可能是由于 MySQL binlog 文件被删除或者 MySQL binlog 文件中的数据被清空所导致的。您可以按照以下步骤解决这个问题:

确认 MySQL binlog 文件是否存在,以及是否包含您需要同步的数据。如果 binlog 文件已被删除或者数据被清空,您可以尝试找回数据或者重建 MySQL binlog 文件。

检查 CDC Connector 的配置是否正确。您需要确保 CDC Connector 的配置中包含正确的 binlog 文件名和 binlog 位置。

检查 CDC Connector 的日志,查看是否有其他错误信息。如果有其他错误信息,请尝试解决这些错误。

如果以上步骤都无法解决问题,请尝试重新启动 CDC Connector。在重新启动 CDC Connector 之前,建议您先备份数据。

希望这些步骤能够帮助您解决问题。如果问题仍然存在,请提供更多详细信息,以便我们更好地帮助您解决问题。

2023-04-26 18:30:14赞同 展开评论 -

如果CDC在运行一段时间后突然挂掉,那么很可能是由于一些不可预测的原因导致的,例如网络故障、硬件故障、内存泄漏等。为了解决这个问题,您可以采取以下几个步骤:

查看日志文件 首先,您需要查看CDC的日志文件,以了解具体的错误信息和异常情况。通常,CDC的日志文件位于/usr/local/services/cdc/logs目录下。可以使用以下命令来查看最近的日志文件:

tail -f /usr/local/services/cdc/logs/cdc.log 检查数据库状态 如果CDC在同步数据时突然挂掉,可能是由于源数据库出现了某些问题,例如网络故障、磁盘空间不足等。因此,您需要检查源数据库的状态,并确保其正常运行。

重新启动CDC 如果CDC挂掉后无法自动重启,您可以手动重启CDC,以便恢复数据同步服务。可以使用以下命令来启动或停止CDC:

sudo systemctl start cdc sudo systemctl stop cdc 需要注意的是,在重新启动CDC之前,建议先备份CDC的数据和配置文件,以免数据丢失或配置文件被恶意篡改。

进行诊断和优化 如果CDC在运行一段时间后经常挂掉,那么您需要进行进一步的诊断和优化。具体而言,可以考虑以下几个方面:

调整CDC的配置参数,例如内存限制、缓存大小等,以提高CDC的性能和稳定性。 定期清理CDC的数据和日志文件,以避免磁盘空间不足或文件系统损坏等问题。 检查CDC所连接的源数据库和目标数据库的状态和健康情况,并进行相应的维护和优化。 监控CDC的运行状态和性能指标,及时发现和处理潜在问题。 需要注意的是,在进行诊断和优化时,建议先了解CDC的架构和运行原理,并根据实际情况进行选择和调整,以确保系统的稳定性和可靠性。

2023-04-26 11:02:09赞同 展开评论 -

这个问题的原因是 CDC Connector 从 MySQL binlog 中读取数据时,读取到了一个不存在的 binlog 文件或者 binlog 位置,导致任务失败。要解决这个问题,需要重新配置 CDC Connector,使用一个可用的位置或者快照重新启动任务。

具体来说,你可以按照以下步骤进行操作:

-

确定当前任务失败的位置,例如在错误信息中提到的 "mysql-bin.000039" 和 "pos=530"。

-

检查 MySQL 数据库中是否存在该 binlog 文件,以及该位置是否可用。你可以使用 MySQL 命令行工具或者其他 MySQL 客户端工具进行检查。

-

如果该位置不可用,那么可以使用 CDC Connector 的快照功能重新启动任务。具体来说,你需要在 CDC Connector 的配置文件中添加以下两行配置:

snapshot.mode = initial snapshot.locking.mode = none这些配置将启用 CDC Connector 的快照功能,并在启动任务时从 MySQL 数据库中获取快照数据。

- 如果该位置可用,那么可以在 CDC Connector 的配置文件中修改任务的起始位置,使其从可用位置开始读取数据。具体来说,你需要在配置文件中添加以下两行配置:

debezium.snapshot.locking.mode = none debezium.snapshot.mode = never debezium.offset.storage.file.filename = /path/to/offset/file debezium.offset.flush.interval.ms = 60000 debezium.offset.flush.timeout.ms = 5000 debezium.offset.storage = org.apache.flink.contrib.streaming.state.RocksDBStateBackend debezium.offset.storage.rocksdb.column-family-options = {"write-buffer-size": "33554432", "max-write-buffer-number": "3"} debezium.offset.storage.rocksdb.options = {"db.create.if-missing": "true"} debezium.offset.topic = mysql-offsets debezium.database.history.file.filename = /path/to/history/file debezium.database.history.kafka.bootstrap.servers = kafka:9092 debezium.database.history.kafka.topic = mysql-history debezium.mysql.binlog.offsetFilename = /path/to/offset/file debezium.mysql.binlog.offsetStore = org.apache.flink.contrib.streaming.state.RocksDBStateBackend debezium.mysql.binlog.ssl.mode = DISABLED debezium.mysql.hostname = localhost debezium.mysql.port = 3306 debezium.mysql.username = root debezium.mysql.password = password debezium.mysql.server.id = 1 debezium.mysql.server.name = mysql_binlog_source debezium.mysql.include.schema.changes = false debezium.mysql.ssl.mode = DISABLED debezium.mysql.serverTimezone = UTC debezium.mysql.history.kafka.bootstrap.servers = kafka:9092 debezium.mysql.history.kafka.topic = mysql-history debezium.mysql.history.kafka.recovery.attempts = 100 debezium.mysql.history.kafka.recovery.delay.ms = 10000 debezium.mysql.binary.handling.mode = bytes debezium.mysql.binary.handling.encoding = base64 debezium.mysql.skip.handling.mode = none debezium.mysql.include.query = false debezium.mysql.include.table.list = mydatabase.mytable其中,

debezium.mysql.binlog.offsetFilename指定了 offset 存储的位置,debezium.mysql.server.id和debezium.mysql.server.name指定了任务名称和 ID,debezium.mysql.include.table.list指定了要同步的表名。你需要根据具体情况修改这些配置,然后重新启动任务。希望以上信息能够帮助你解决问题。

2023-04-25 12:59:52赞同 展开评论 -

-

十分耕耘,一定会有一分收获!

楼主你好,根据你的报错提示,是你使用的数据库断连了,你可以着重排查一下对应的数据库连接问题,尤其是binlog文件,问题就出在这里,请仔细排查。

2023-04-24 21:58:13赞同 展开评论 -

从事java行业9年至今,热爱技术,热爱以博文记录日常工作,csdn博主,座右铭是:让技术不再枯燥,让每一位技术人爱上技术

根据错误提示来看是Flink CDC在read 指定的binlog时数据库服务没有返回指定的有效的binlog,这种情况有可能是你任务执行时间过长,mysql指定binlog已经不可用了,因此读取时才会报错,建议调整任务长度,缩短单次执行时间。

2023-04-24 20:32:56赞同 展开评论 -

全栈JAVA领域创作者

根据报错信息看,可能是MySQL数据库连接断开导致的。建议先检查MySQL连接是否正常,并查看具体的错误日志。可以尝试重启MySQL服务、增加连接超时等措施来解决问题。此外,也可以考虑升级或者切换至其他版本的 CDC 插件进行尝试。

2023-04-24 07:54:41赞同 展开评论 -

热爱开发

这个错误信息显示 CDC 连接 MySQL 数据库时出现了异常,可能是由于 binlog 文件在服务器端不可用,导致无法继续读取数据。建议检查 MySQL 服务器上当前 binlog 文件的状态,并确保该文件在服务器上是存在、可用的。如果该文件存在但是无法访问,可以尝试重启 MySQL 服务或者进行数据库恢复操作。另外,还可以检查一下 Flink CDC 配置文件中是否指定了正确的 binlog 文件名和位置参数,并适当调整配置参数以适应当前 binlog 状态。

2023-04-23 18:23:11赞同 展开评论 -

从报错信息看,可能是 CDC 的 binlog 文件已经被清理掉,而 Sink 端仍然在使用 binlog 文件中的某个位置进行消费,导致了报错。

解决该问题可以采取以下方法:

-

增加 binlog 文件的保留时间。

在 MySQL 中可以修改

log-bin和expire-logs-days参数来控制 binlog 文件的生成和保留时间,详细方法可以参考 MySQL 官方文档。 -

修改每个 Sink 端的起始位置。

由于报错信息中提示的是

binlog position has been updated on the master,因此可以通过修改每个 Sink 端的 binlog 起始位置来解决问题:-

首先需要确定当前已经解析到的 binlog 文件名和位置信息,可以通过查看每个 Sink 端的状态信息来获取。

-

然后,在 CDC 配置文件中的每个 Sink 端配置中添加

snapshot-offset参数,指定该 Sink 端的起始位置。例如:[mysink] type = "jdbc" ... snapshot-offset = "mysql-binlog.000123:456"其中

snapshot-offset参数的值为解析到的 binlog 文件名和位置。

-

-

恢复数据同步。

如果以上方法不能解决问题,可以考虑重新启动数据同步任务,但需要注意如果数据同步过程中有数据丢失或重复,可能需要手动处理或调整数据。

2023-04-23 17:38:50赞同 展开评论 -

-

存在即是合理

你的Flink CDC连接器在读取MySQL的binlog数据时,发现需要的某个binlog已经不可用,这可能是由于MySQL中的binlog已经被清理或过期导致的。

2023-04-23 16:38:36赞同 展开评论

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。