请问下,我在flink/lib下已经上传cdc的jar包了,pom的scope里如果改成provided,就会报类找不到,这是为什么昵

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

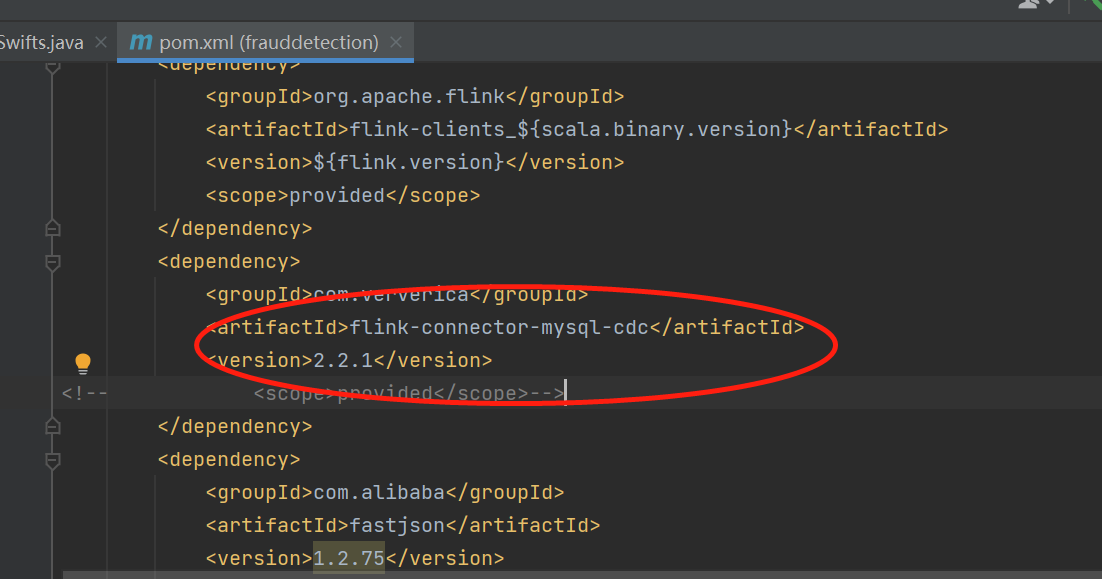

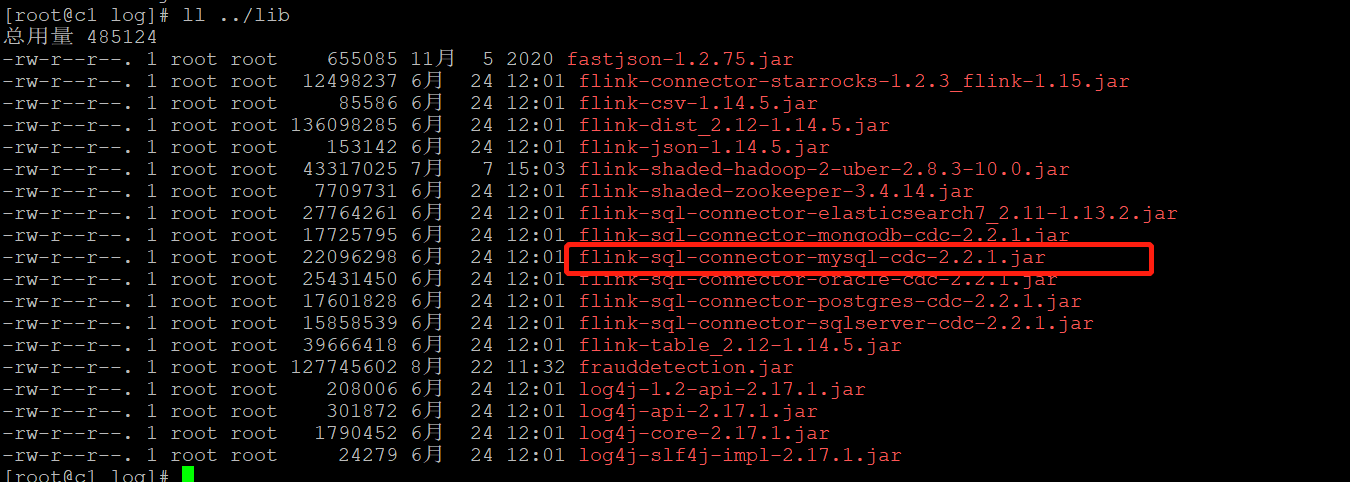

当您在Flink的lib目录下上传了CDC(Change Data Capture)相关的JAR包,并且尝试在您的项目pom.xml文件中将Flink依赖的Scope设置为provided时遇到类找不到的错误,这通常是因为以下原因:

Scope理解误区:在Maven中,<scope>provided</scope>意味着该依赖在编译和测试时需要,但在运行时不需要,因为预期运行环境会提供这个依赖。因此,如果您将Flink核心库或者任何直接用到的库(包括CDC库)设置为provided,构建系统会在打包时排除这些依赖,假设它们将在目标环境中可用。

类路径冲突或缺失:当您在Flink集群的lib目录放置了额外的JAR而项目POM中相应依赖设为provided,可能会导致以下情况:

lib的JAR可能没有涵盖所有必要的类,特别是当它是一个精简版或者与您项目直接引用的版本不同步时。解决策略:

flink/lib的JAR版本与项目POM中指定的版本相匹配,避免混合使用不同版本的依赖。provided,以确保这些库被包含在最终的作业JAR中。仅将那些确实由Flink运行时环境提供的依赖设置为provided。综上所述,报类找不到的错误是因为当您将必要的库设置为provided后,这些库在打包时被排除,而在实际运行时由于各种原因未能从集群环境正确加载。调整依赖管理策略,确保所有必需的库都被正确包含在应用程序的运行环境中是解决此问题的关键。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。