版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

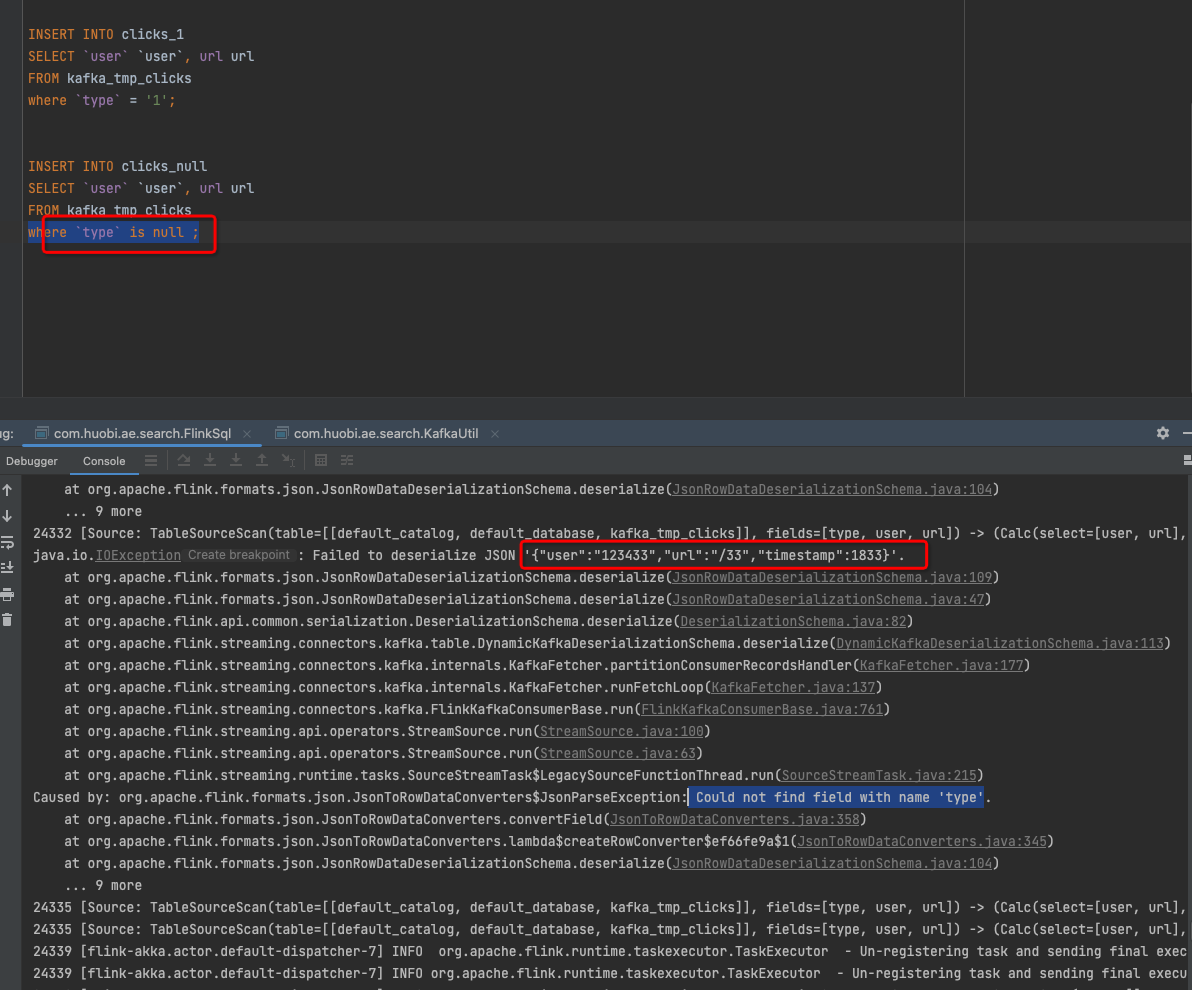

如果您在使用 Flink 或其他数据流处理框架时遇到了空字段报序列化异常的问题,这可能是因为您的数据流中包含了空字段,而 Flink 或其他数据流处理框架默认不会序列化空字段。

在 Flink 中,您可以使用 json 或 csv 转换器来处理数据流中的空字段。例如,您可以使用以下代码将 JSON 数据流转换为 CSV 数据流,同时处理空字段:

DataStream<String> jsonStream = ...;

DataStream<String> csvStream = jsonStream

.map(new MapFunction<String, String>() {

@Override

public String map(String value) throws Exception {

Map<String, Object> map = JSON.parseObject(value, Map.class);

if (map.get("name") == null) {

map.put("name", "");

}

return FlinkJsonUtils.objectToString(map);

}

})

.map(new MapFunction<String, String>() {

@Override

public String map(String value) throws Exception {

String[] fields = value.split(",");

return fields[0] + "," + fields[1] + "," + fields[2];

}

})

.map(new MapFunction<String, String>() {

@Override

public String map(String value) throws Exception {

String[] fields = value.split(",");

String[] names = fields[0].split("\\.");

String[] values = fields[1].split(",");

return names[0] + "." + names[1] + "." + values[0];

}

})

.csv();

在上面的代码中,我们首先使用 map 函数将 JSON 数据流转换为 CSV 数据流,同时处理空字段。在 map 函数中,我们首先将 JSON 数据流转换为一个 Map 对象,如果该对象中的 "name" 字段为空字符串,则将其设置为一个默认值。然后,我们将该 Map 对象转换为一个字符串,并使用逗号将字段分隔开。

接下来,我们使用 map 函数将 CSV 数据流转换为另一种格式的 CSV 数据流,同时处理空字段。在 map 函数中,我们首先将 CSV 数据流分隔为三个字段,然后将这些字段拼接起来,形成一个字符串。

希望这些信息能够帮助您解决问题。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。