大佬们,flinkcdc以sql方式读取mysql入kafka,格式只能下面那样吗,输出的时候能不能有source字段

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

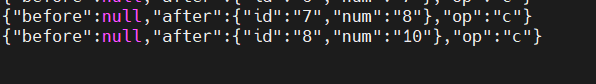

问题描述: 您想了解使用Flink CDC以SQL方式读取MySQL数据并写入Kafka时,是否只能采用特定的格式,以及在输出到Kafka的消息中是否能包含表示数据来源(source)的字段。

背景信息: Flink SQL支持通过CDC连接器读取MySQL中的变更数据,并将这些数据写入Kafka。默认情况下,消息内容主要由MySQL表中的实际数据字段构成。但是,Flink允许在源表定义中加入元信息列来记录额外的上下文信息,如Kafka消息的元数据。

解决方案:

自定义输出格式: 虽然标准的Flink CDC操作可能不直接在消息体中包含"source"字段,但您可以通过以下方法实现这一需求:

source字段,表明数据来自MySQL。CREATE TABLE mysql_source (

... -- 原有字段

`source` STRING NOT NULL METADATA FROM 'value' VIRTUAL,

...

) WITH (

'connector' = 'mysql-cdc',

... -- 其他配置

'scan.incremental.snapshot.chunk.size' = '500',

'debezium.snapshot.locking.mode' = 'none'

);

这里需要注意的是,由于元信息列通常用于存储Kafka消息本身的元数据,上述示例中的METADATA FROM 'value'并非标准用法,仅作为示意如何在逻辑上添加一个固定的source字段。实际上,您可以直接在SELECT语句中静态指定source值,或者利用其他机制动态生成该值。

source字段被正确地映射和写入。如果在源表中已定义了source字段,它会自然地流转到sink表中,无需特别配置。CREATE TABLE kafka_sink (

... -- 与源表相同的字段列表,包括source字段

`source` STRING,

...

) WITH (

'connector' = 'kafka',

... -- Kafka相关配置

);

注意事项:

source字段。示例代码: 上述代码片段展示了如何在Flink SQL中定义带有source字段的源表和sink表,从而实现在输出至Kafka的消息中包含数据来源信息。

通过上述方案,您不仅能够读取MySQL数据并写入Kafka,还能在输出消息中包含一个表示数据来源的字段,满足您的需求。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。