4.2.1 JDBC Sink Connector 如何保证一致性?我们在官网上发现对于 JDBC

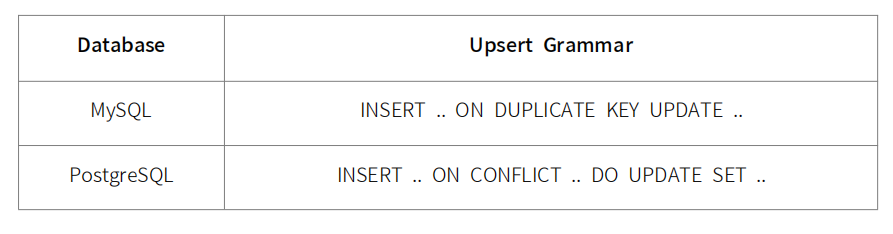

4.2.1 JDBC Sink Connector 如何保证一致性?我们在官网上发现对于 JDBC Sink Connector 的幂等性中有如下解释: 如果定义了主键,JDBC 写入时是能够保证 Upsert 语义的, 如果 DB 不支持 Upsert 语法,则 会退化成 DELETE + INSERT 语义。Upsert query 是原子执行的,可以保证幂等性。 这个在官方文档中也详细描述了更新失败或者存在故障时候如何做出的处理,下面的表格是不同的 DB 对应不同的 Upsert 语法: 因此我们可以通过写入时保证 Upsert 语义,从而保证下游 Sink 端的幂等性,再 Review 一次到 端到端一致性实现条件 4,下游去重也可以通过实现幂等从而实现下游的 Exactly Once 语义。 4.下游去重,应对下游处理完消息后发生 failure,重复接收消息的场景,这种可通过给消息设置 SequcenceId 实现去重,或者下游实现幂等。 官方的文档有提到这个,但是没有说明具体说要怎么解决。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

十分耕耘,一定会有一分收获!

楼主你好,对于下游去重和实现幂等的具体实现,可以根据实际情况采取不同的方案。比如说:

给消息设置 SequenceId:在 Kafka Producer 中,可以为每个消息设置一个唯一的 SequenceId,然后在下游进行去重。这种方式比较简单,但是可能会增加数据量和处理时间。

下游实现幂等:可以在下游系统中实现幂等,比如在数据库中使用唯一约束来保证数据的唯一性。这种方式相对较为复杂,但是可以减少数据量和处理时间。

无论采用哪种方式,都要保证幂等性的正确实现。如果实现不当,可能会导致数据的重复写入或者数据的丢失。

2023-08-22 17:12:14赞同 展开评论

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。