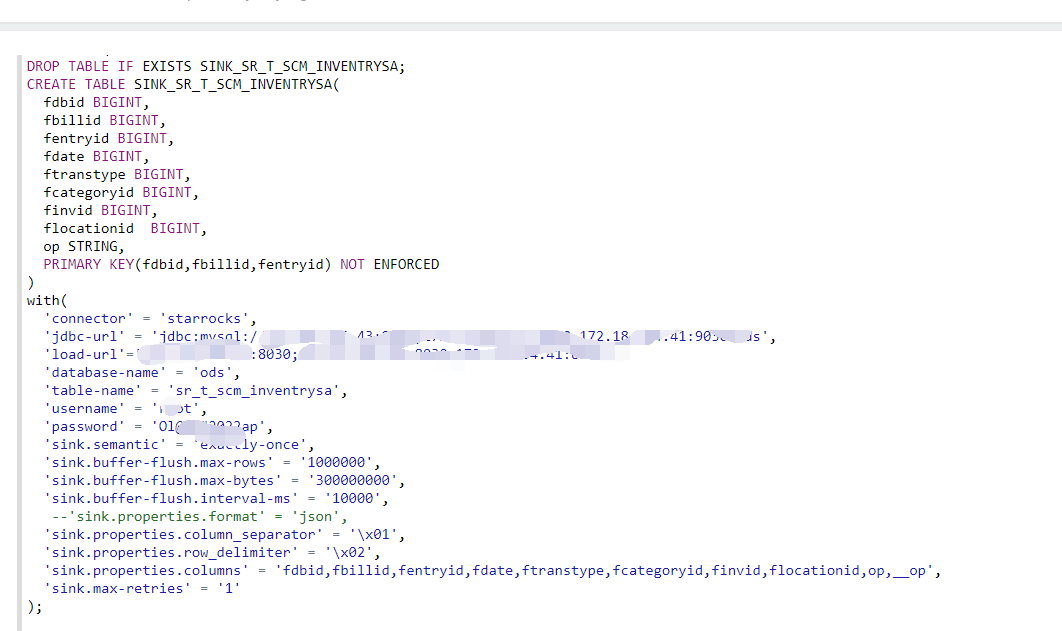

用flinksql的方式 写进 sr的表,发现需要删除的数据没有删除, 参照文档https://docs.starrocks.com/zh-cn/main/loading/PrimaryKeyLoad ,不知道哪里没有设置对,求解?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您的描述,您在使用Flink SQL向StarRocks表(基于文档中提及的主键加载方式)写入数据时,发现预期应被删除的数据没有被正确删除。为了解决这个问题,请按照以下步骤检查和调整您的配置:

确认主键设置: 确保您的Flink SQL定义的目标表已正确定义了主键。在StarRocks中,通过主键进行数据更新和删除操作是关键。请参照如下示例确保您的表定义中包含了正确的主键信息:

CREATE TABLE my_table (

id BIGINT PRIMARY KEY,

...

) WITH (

'connector' = ...,

'sink.operation' = 'upsert', -- 或其他支持删除操作的sink配置

...

);

检查Sink配置:

sink.operation配置为支持删除操作的模式,如upsert,这允许Flink SQL作业执行包括插入、更新和删除在内的操作。sink.ignore-delete参数。如果此参数被误设为true,Flink将忽略所有DELETE消息,导致数据无法被删除。确保该参数为默认值false或显式设置为false。SQL Hint与Filter下推: 虽然此情况可能不直接关联到问题,但请注意,如果您同时使用表作为源表和维表,并且对维表开启了Filter下推(lookup.filter-push-down.enabled=true),在某些特定场景下可能导致意料之外的行为。特别是当涉及到Delete操作时,务必确保配置正确无误,必要时可禁用Filter下推功能以排除干扰。

数据流检查: 确认上游数据流确实包含期望的删除操作(例如,Debezium等CDC工具生成的消息中应有DELETE事件)。如果数据源未发送删除消息,Flink自然无法执行删除操作。

版本兼容性: 确认使用的Flink版本与StarRocks的集成是兼容的,并且支持所需的sink特性。参考知识库中的配置说明,确保所有相关配置项符合要求。

错误日志分析: 查看Flink作业的运行日志,寻找任何与数据删除操作相关的错误或警告信息,这些日志可能会提供问题的具体原因。

综上所述,主要关注点在于确保表结构定义正确、sink配置支持删除操作、以及检查数据流和系统兼容性。如果以上步骤均未发现问题,建议深入查看日志并考虑咨询StarRocks或Flink社区获取更专业的帮助。

参考资料:[1]

阿里云EMR是云原生开源大数据平台,为客户提供简单易集成的Hadoop、Hive、Spark、Flink、Presto、ClickHouse、StarRocks、Delta、Hudi等开源大数据计算和存储引擎,计算资源可以根据业务的需要调整。EMR可以部署在阿里云公有云的ECS和ACK平台。