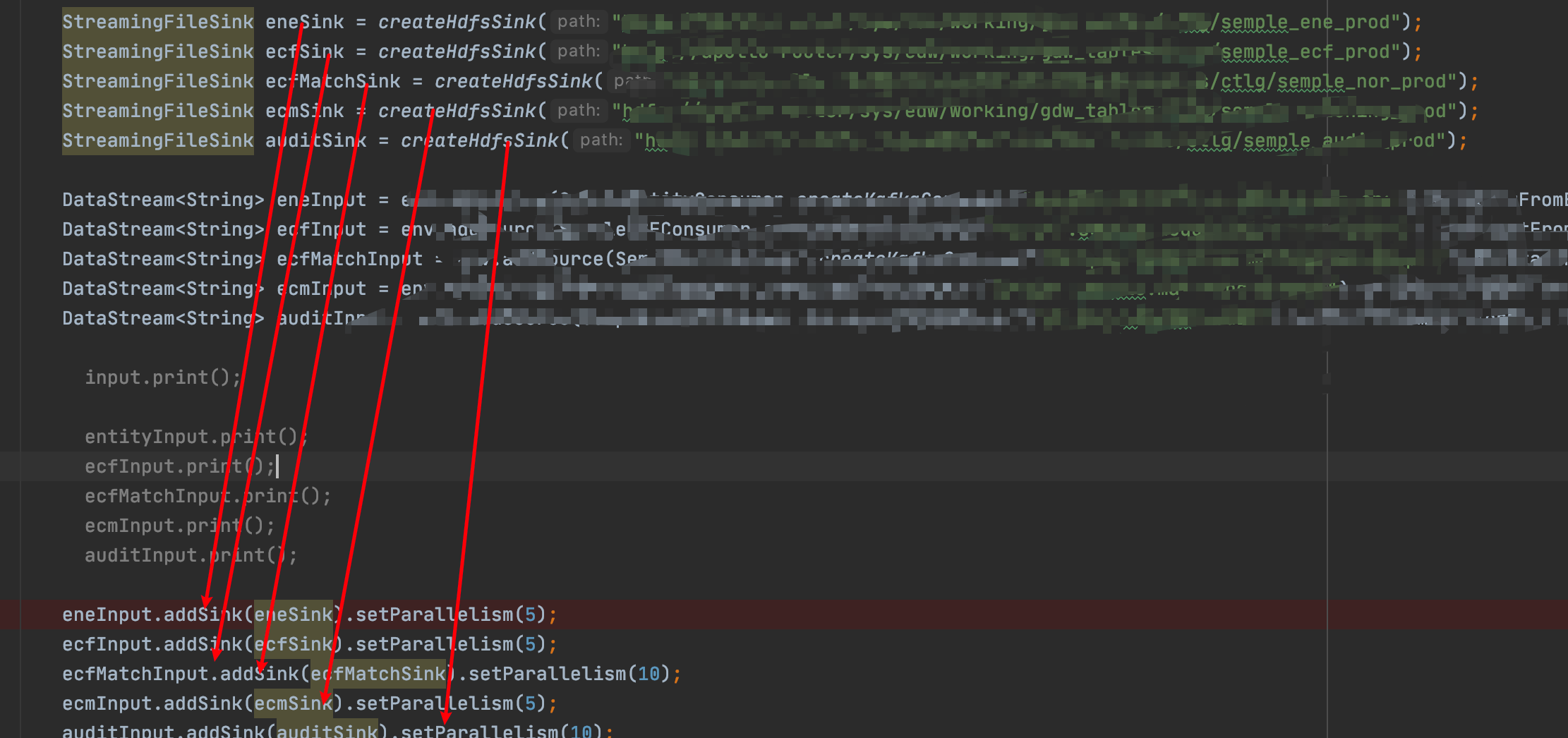

请问如图,这样操作flink会不会造成并发写?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您的问题描述,似乎没有直接附图或具体的操作细节,但基于您提及的“这样操作Flink会不会造成并发写”,我们可以从Flink作业配置的角度来分析可能引起并发写入的情况。

在Flink中,并发写主要由任务的并行度设置决定,尤其是在Sink端。以下是可能导致并发写入的情景:

Sink端并行度配置:如果Sink端的并行度设置得较高,并且与下游系统(如数据库、消息队列)的写入能力相匹配或超过其处理能力,那么确实会存在并发写入的情况。合理的并行度应当考虑下游服务的承受能力。例如,若不恰当地将Sink处的并行度设置得过大,而下游服务无法处理如此高并发的写入请求,可能会导致下游服务压力过大甚至崩溃。

动态分区写入:当使用Flink写入支持动态分区的数据存储(如Delta Table、时序引擎等),若配置不当,也可能引发高并发写入问题。特别是当动态分区数量过多且未合理限制时(如未适当设置sink.dynamic-partition.limit参数),容易因同时写入大量分区而导致内存溢出(OOM)或其他错误。

为了避免不必要的并发写问题,建议采取以下措施: - 合理设置并行度:确保Sink端的并行度与下游系统的处理能力相匹配。 - 监控与调整:实施监控机制,根据实际负载动态调整并行度和相关参数。 - 优化动态分区策略:对于动态分区写入,合理设置分区限制和分组策略,避免短时间内大量分区写入带来的资源压力。 - 利用缓存与批处理:在适用场景下,采用文件缓存模式(如Delta Table的FileCached模式)或增大批处理大小(如时序引擎的batchSize),以减少写入请求的频率,降低并发压力。

综上所述,Flink作业中的并发写行为受并行度及数据写入策略直接影响,通过精细配置可以有效管理和控制并发写的风险。